记者 李莉 张迪驰

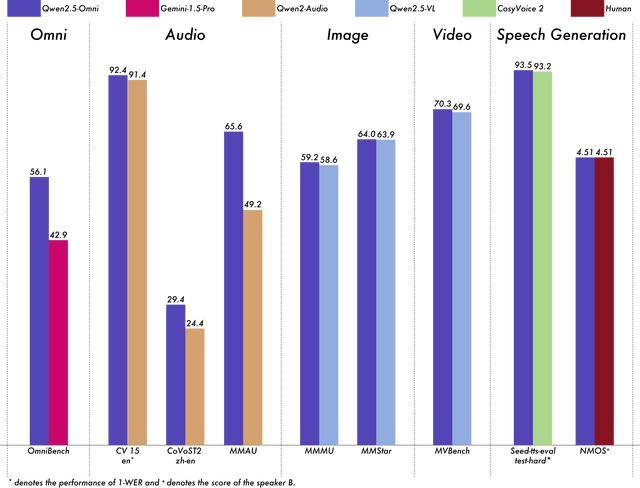

3月27日凌晨,阿里巴巴发布并开源首个端到端全模态大模型通义千问Qwen2.5-Omni-7B,记者了解到,该模型可同时处理文本、图像、音频及视频输入,并实时生成文本与自然语音输出。在权威的多模态融合任务OmniBench等测评中,Qwen2.5-Omni以全维度领先表现刷新业界纪录,大幅超越Google Gemini-1.5-Pro等同类模型,成为目前全球性能最强的全模态大模型。

据介绍,Qwen2.5-Omni采用通义团队首创的Thinker-Talker双核架构与TMRoPE位置编码算法,构建了类人“大脑”与“发声器”协同的端到端架构。通过实时流式处理,模型能统一感知所有模态信息,并高效完成语义理解与语音生成。其创新性的位置嵌入技术还实现了音视频时序对齐,使模型能以接近人类的多感官方式“立体”认知世界,甚至在交互中识别情绪,为复杂任务提供更智能、自然的反馈与决策支持。

在同等规模单模态权威基准测试中,Qwen2.5-Omni展现出跨模态的全面优势:语音理解、图片/视频解析等能力均超越专业单模态模型,其语音生成测评分数达4.51分,与人类水平持平。尤为重要的是,该模型仅以7B参数规模实现了上述突破,大幅降低全模态大模型的产业应用门槛。开发者可免费下载商用,手机等终端设备也能轻松部署运行。

目前,Qwen2.5-Omni已在魔搭社区、Hugging Face平台开源,用户还可通过Qwen Chat直接体验其多模态交互能力。

京公网安备 11011402013531号

京公网安备 11011402013531号