3 月 27 日消息,科技媒体 testingcatalog 昨日(3 月 26 日)发布博文,报道称 AI 公司 Anthropic 正计划“扩容”Claude 3.7 Sonnet 模型,将其上下文窗口将从 20 万 token 跃升至 50 万 token。

50 万 tokens 窗口可直接处理海量信息,避免检索增强生成(RAG)可能导致的上下文错乱问题,适用于政治文档分析、超长代码库管理(如数十万行代码)、跨文档摘要生成等复杂任务。不过该媒体也指出超大上下文可能带来内存和算力成本压力,模型实际利用率仍需验证。

注:上下文窗口(Context Window)是模型在生成每个新 token 时实际参考的前面内容的范围。可以将其类比为在某一特定时间内你能集中注意力的范围,就像你只能专注于手头的有限任务。

Context Window 决定了在生成过程中,模型可以参考的上下文信息的量。这有助于模型生成连贯且相关的文本,而不会因为参考过多的上下文而导致混乱或不相关的输出。

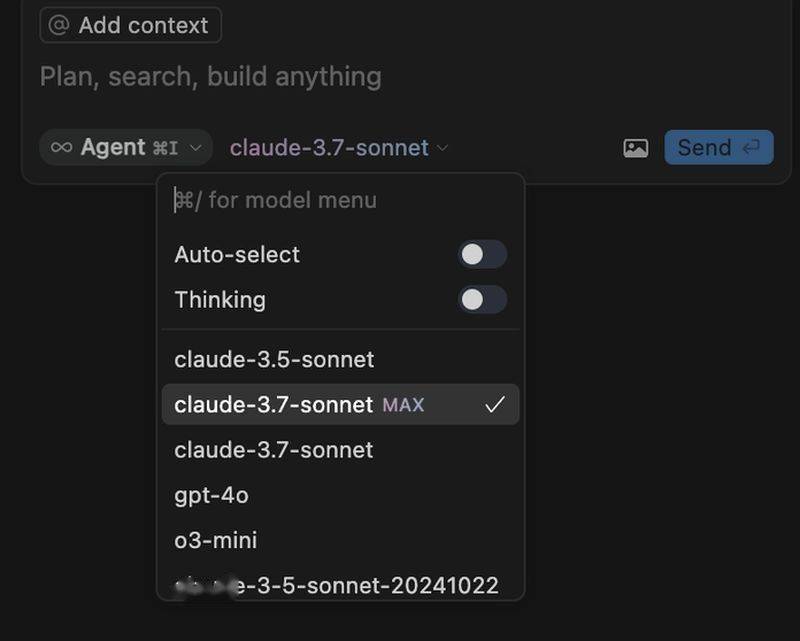

消息称该功能或先面向企业客户开放,如编程工具 Cursor 已在其 IDE 中提供 "Claude Sonnet 3.7 MAX" 选项。Anthropic 始终聚焦企业级解决方案,此次升级直指 Google Gemini 等竞品的超长上下文优势。

此次升级恰逢 AI 驱动的“氛围编程”(vibe coding)兴起。开发者通过自然语言描述生成代码,50 万 token 窗口可支持更大型项目连续开发,减少因 token 限制导致的中断,进一步降低编程门槛。

京公网安备 11011402013531号

京公网安备 11011402013531号