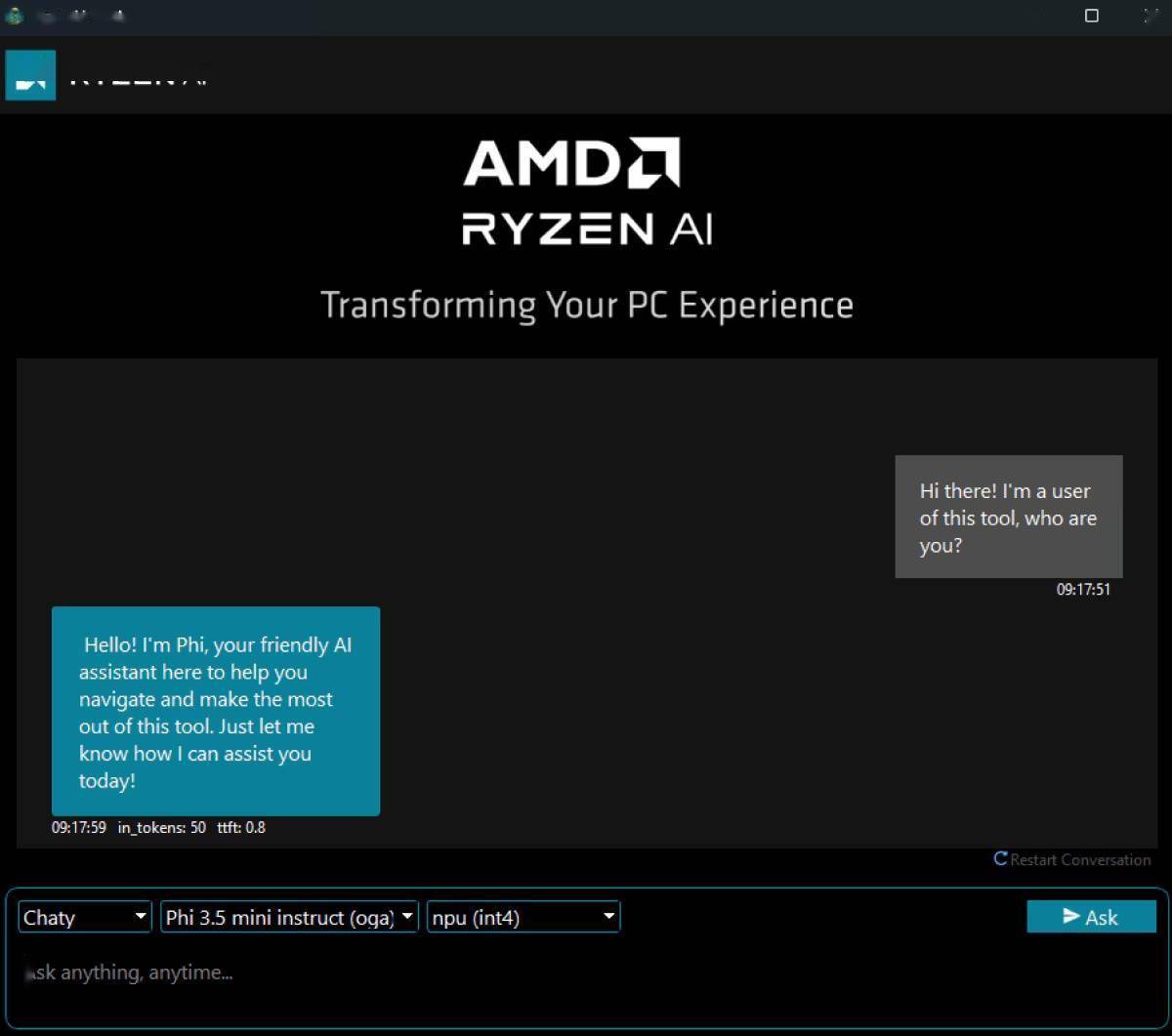

3 月 22 日消息,当地时间周四,AMD 宣布推出专为本地运行大语言模型(LLM)设计的应用 GAIA(发音为/ˈɡaɪ.ə/)并在 Github 开源,目前仅限于 Windows 平台。

GAIA 是一款生成式 AI 应用,能够在 Windows PC 上实现本地化私密运行 LLM,并针对锐龙 AI 300 系列处理器进行了优化,标志着 AMD 在边缘计算领域的又一重要布局。

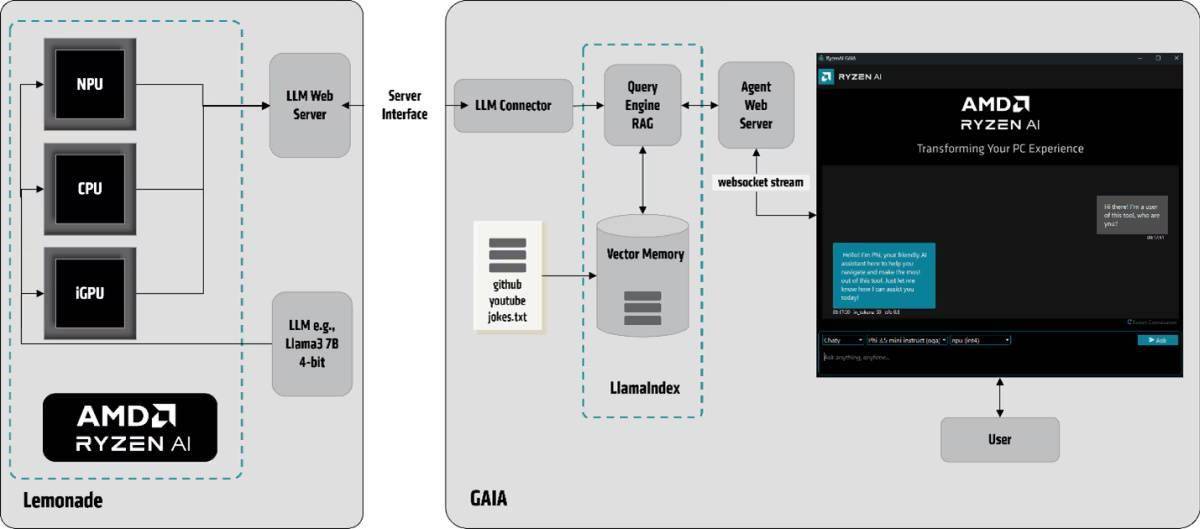

在 NPU 上运行 GAIA 可提高 AI 特定任务的性能。从 Ryzen AI 软件版本 1.3 开始,混合支持部署同时使用 NPU 和核显的量化 LLM。

其核心组件基于 onNX TurnkeyML 的 Lemonade SDK 开发,采用检索增强生成(RAG)技术框架,通过本地向量索引实现 YouTube、GitHub 等外部数据的实时检索与分析。

系统工作流包含 LLM 连接器、LlamaIndex RAG 管道和代理 Web 服务器三大模块,支持 Llama、Phi 等主流模型。功能模块包含四大 AI 智能体:

Chaty:支持历史对话的聊天机器人

Clip:YouTube 视频搜索与问答专家

Joker:具备幽默风格的笑话生成器

Simple prompt:模型直接交互测试工具

硬件方面,AMD 提供普通版与混合版两种安装方案。普通安装包兼容任意 Windows PC(含非 AMD 硬件设备),通过 Ollama 后端实现跨平台支持。

混合安装包专为配备锐龙 AI 300 系列处理器的设备进行优化,可智能分配 NPU 与集成显卡的计算负载。AMD 表示,Ryzen AI 软件自 1.3 版本起支持量化模型在 NPU 和集成显卡间的混合部署。

隐私与性能优势方面:

本地化处理确保医疗、金融等敏感行业数据不出境

响应延迟降低至毫秒级(相较云端方案缩短 40-60%)

NPU 专用架构实现每瓦性能提升,支持离线环境运行

该项目采用 MIT 开源协议,代码库已在 GitHub 开放。AMD 特别鼓励开发者贡献自定义代理模块,目前已有多个行业定制化代理处于开发阶段。

此外,尽管 GAIA 目前暂不支持 Linux / macOS 系统,但 AMD 官方文档透露未来可能扩展多平台支持。

附 Github 地址:

https://github.com/amd/gaia

京公网安备 11011402013531号

京公网安备 11011402013531号