新“核弹”要等明年,旧“核弹”还能战

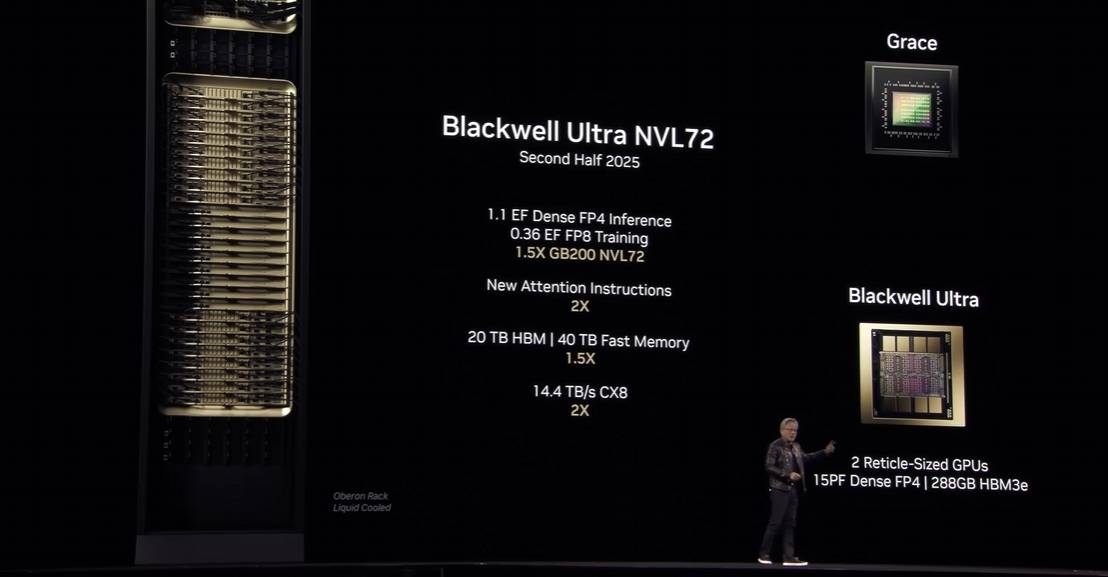

与往年一样,今年的英伟达同样带来了全新的计算芯片——Blackwell Ultra和“期货”芯片Rubin。其中,Blackwell Ultra实际上是Blackwell的升级版,已经开始接受预订,在性能与带宽等方面对比前代都有所升级,并且适配最新的NVlink技术,拥有更高的带宽和速度。

图源:英伟达

虽然在大会上并没有公布GB300的价格,但是参考GB200的售价来看,新芯片的价格显然不会便宜,而且英伟达貌似暂时并不打算单独出售显卡,目前还是以机柜的方式进行整套销售,不过和昂贵的芯片相比,机柜其他配件的价格倒也显得“微不足道”了。

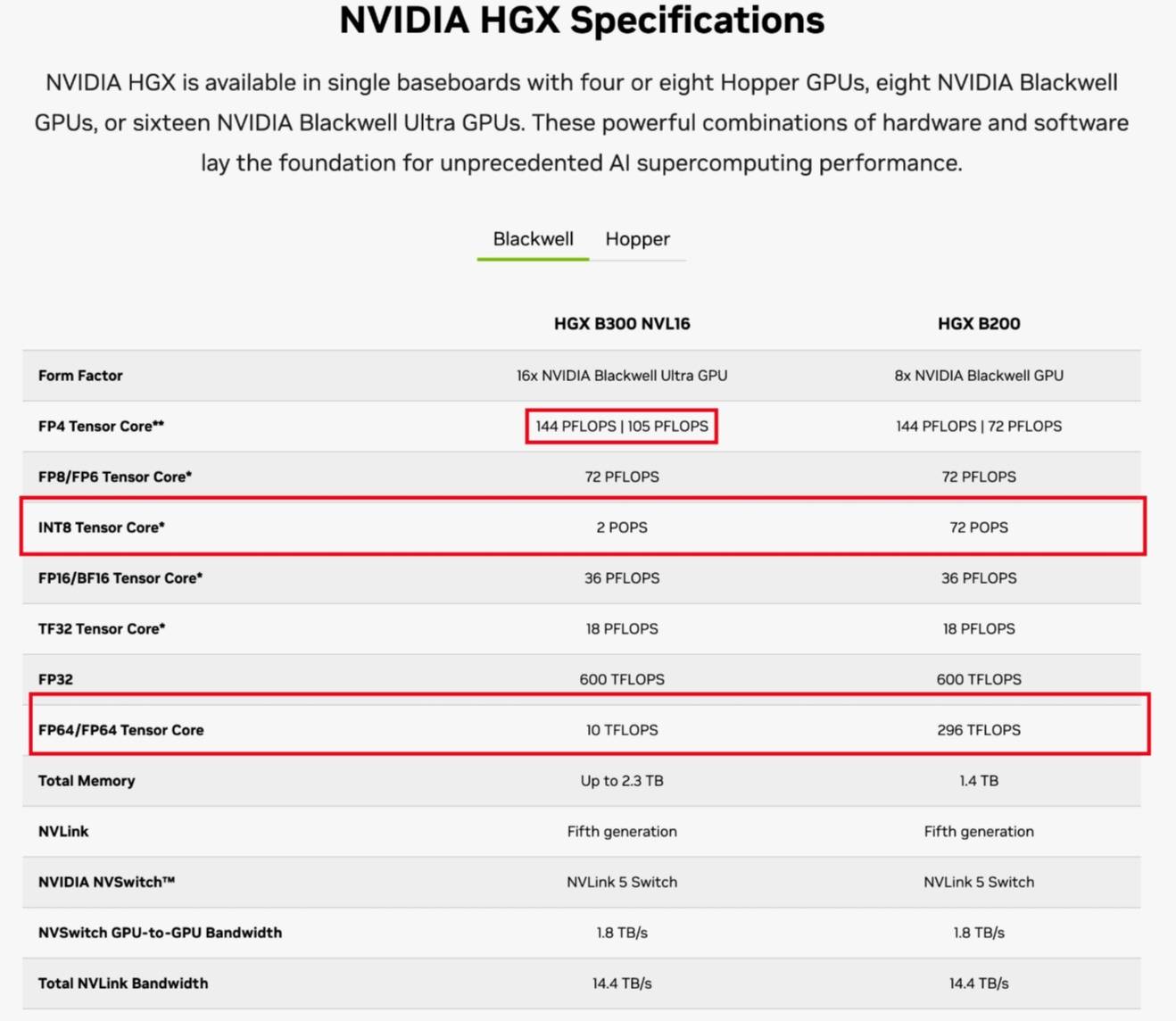

从英伟达公布的参数来看,Blackwell Ultra的显存从192GB升级为288GB,而在NVL72状态下(72颗芯片互联)AI性能是GB200的1.5倍。老实说这个数据远不如从Hopper架构跳到Blackwell架构时惊艳,而且官方给出的数据里对整体性能提升也是“语焉不详”,只是着重提到FP4推理性能提高50%。

而且从官网给出的数据对比来看,FP4推理性能的提升与FP64和INT8的推理性能被砍掉有关,前者从296 TFLOPS直接掉到10 TFLOPS,后者则是从72 PFLOPS掉到仅剩2 PFLOPS,省下来的算力资源都被塞到了FP4里。

图源:英伟达

显然,高精度的推理和训练已经逐渐被抛弃,以FP8、FP4为主的低精度训练正在成为主流。其实这里面也有不少DeepSeek的功劳,前段时间开源的一系列技术中就包括“如何在FP8低精度下保证训练和推理命中率”的相关方案,也正是靠着这套方案,DeepSeek的训练成本和推理成本才会远低于其他AI企业。

不过目前来看,通过降低精度来提高算力效率的路也差不多走到头了,FP4再往下的精度就很难确保效率和成本都满足需求了,为了纠正错误所需要付出的资源可能超过在更高精度下训练的成本。

虽然算力提升幅度存疑,但是显存的增长却是实打实的,特别是推理模型大行其道的当下,AI推理和训练对带宽的要求远比以前更高。所以GB300的销量还是很可观的,据黄仁勋透露,亚马逊、 微软等企业已经提前下了360万颗Blackwell Ultra芯片的订单,将进一步拓展他们位于全球各地的AI算力中心。

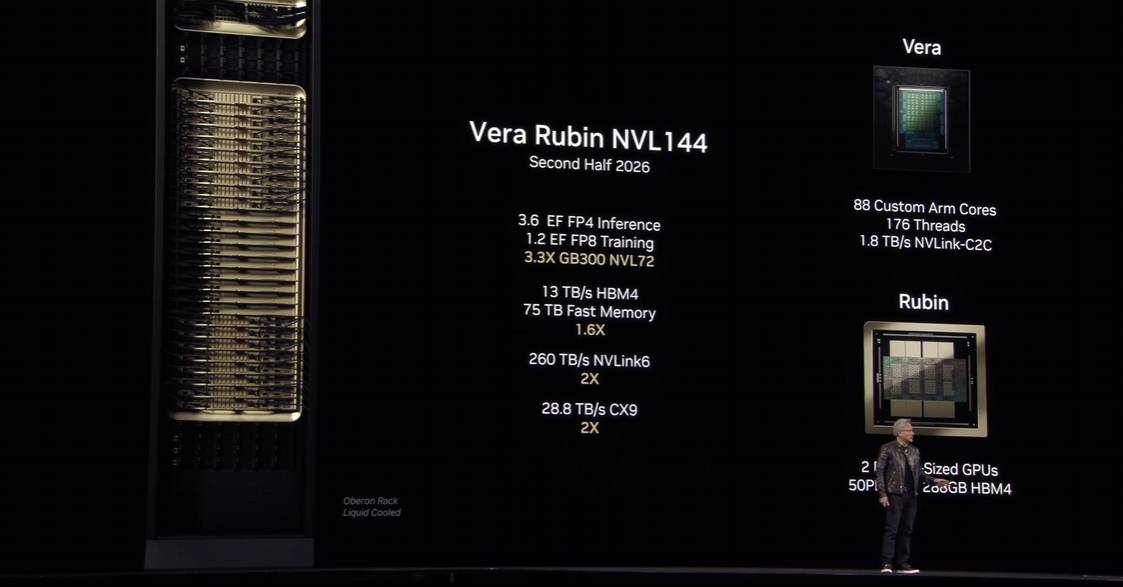

聊完Blackwell Ultra,再来看看“期货”芯片Rubin,这才是英伟达真正的下一代芯片,单芯片的FP4性能提升到25 PFLOPS,而完整的Rubin是双芯片设计,所以实际FP4性能高达50 PFLOPS,是Blackwell Ultra的三倍以上。此外,显存也升级为HBM4,虽然容量仍然是288GB,但是带宽从8TB/s升级到13TB/s,在NVlink状态下吞吐量高达260TB/s,是前代的两倍。

图源:英伟达

而且Rubin支持NVL144,也就是单个机柜最高可串联144颗芯片,提供高达3.6EF的FP4算力或1.2 EF的FP8算力。作为对比,NVL72的Blackwell Ultra只有1.1EF的FP4算力,FP8算力更是只有0.36 EF,差距非常明显。

除了Rubin外,英伟达这次也直接把Rubin Ultra一起展示了,最高支持NVL576,拥有15 EF的FP4算力和5EF的FP8算力,性能是GB300 NVL72的14倍,单组芯片配备1TB的HBM4e内存,显存带宽高达4.6PB/s,NVlink 7将为其提供高达1.5PB/s的带宽速度。

图源:英伟达

虽然数据看起来非常吓人,不过单从算力来看基本上没有多少增长,因为Rubin Ultra就是两个Rubin组合在一起而已(Blackwell的GB200也是如此),所以最主要的升级还是新的NVlink和显存。

虽然Rubin架构的参数很诱人,但是最快也要等到2026年下半年才会开始出货,而Rubin Ultra更是要等到2027年下半年,你可以理解为英伟达直接把未来两年的更新计划提前透了底,估计也是为了提振市场对英伟达的信心。

至于2028年才会上市的“Feynman”,就单纯只有一个名字了,更多的信息并没有公开,只能说英伟达是懂得画饼的。总体来说,Blackwell Ultra虽然不如此前猜测的那样提升巨大,但是也更契合当下的AI模型训练和推理需求,随着Blackwell Ultra的陆续普及,全球算力规模估计会迎来新一轮的暴涨。

DeepSeek让英伟达“卖得越多,赚得越多”

虽然新芯片的发布关注度很高,不过最有意思的还是老黄的新金句:“买得越多、赚得越多”,普罗大众是否认可这个观点尚且不谈,反正四大云服务器运营商是认可了,这也是英伟达“卖得越多,赚得越多”。

这让我不禁想起前段时间随着DeepSeek的爆火,一度有着很高讨论度的话题“AI不再需要英伟达显卡”,现在看来,市场给出了这个问题的答案:“AI或许不再独钟于英伟达显卡,但是我们现在需要更多的算力了。”而按下这场算力竞赛加速键的企业,或许正是DeepSeek。

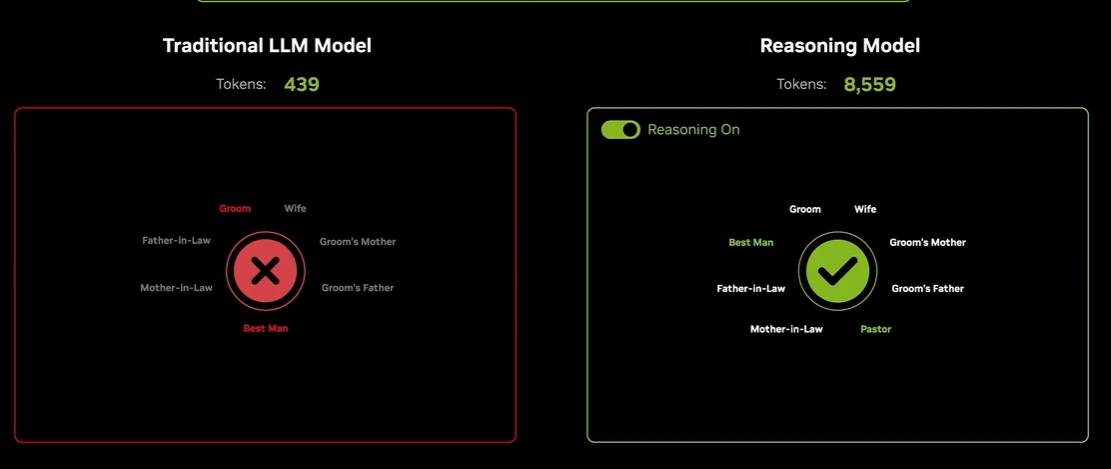

在今年的演讲里,DeepSeek的出场率相当高,直接取代了去年的主角ChatGPT,黄仁勋也用DeepSeek来解释为什么AI算力需求不仅没有下降,反而在增长。作为范例与DeepSeek对比的是LLama 3,一个传统的AI大模型,在回答同一个问题时,LLama只用了不到500 Token就输出了回答,而DeepSeek则是用了高达8559 Token来输出答案。

图源:英伟达

结果是显而易见的,LLama给出了错误答案,而DeepSeek则答对了,为了避免大家觉得DeepSeek-R1用671B的参数量“欺负”只有70B参数量的LLama,演示视频还贴心地备注“活跃参数37B”的字样。这也是DeepSeek-R1这类稀疏型AI大模型的特点,虽然参数量庞大,但是每次实际调用的参数量并不算多,甚至会比传统AI大模型更少。

不过,即使活跃参数量仅为37B,DeepSeek所使用的Token量也远超LLama,因为DeepSeek是推理模型,在输出实际答案前会先进行多轮思考,并且在得到结果后会主动进行验证,只有确定答案符合标准后才进行实际的回答输出。

随着DeepSeek将自己的优化过程和深度学习方案开源,许多AI模型都开始引入类似的长思考链步骤,虽然让回答的质量比以前高了很多,但是对算力的需求也与日俱增,如果不是DeepSeek公布了全套的优化方案,恐怕大多数AI公司的亏损要翻一倍不止。

以目前的形势来看,推理模型淘汰传统AI模型已经没有悬念了,这也意味着即使后续的AI模型及推理过程优化更进一步,想要满足更大参数规模和更复杂的推理所需要的算力资源仍然是个天文数字。而在算力性能上,英伟达仍然是断崖式领先的存在,即使DeepSeek证明了绕过英伟达显卡也能确保推理效率,但是英伟达还是多数厂商的首选。

图源:英伟达

这也是为什么在DeepSeek爆火导致英伟达股价暴跌后,黄仁勋接受采访时却表示DeepSeek其实是利好英伟达,并非“死鸭子嘴硬”,而是看到了DeepSeek所采用的稀疏架构推理模型方案背后对算力的恐怖需求。

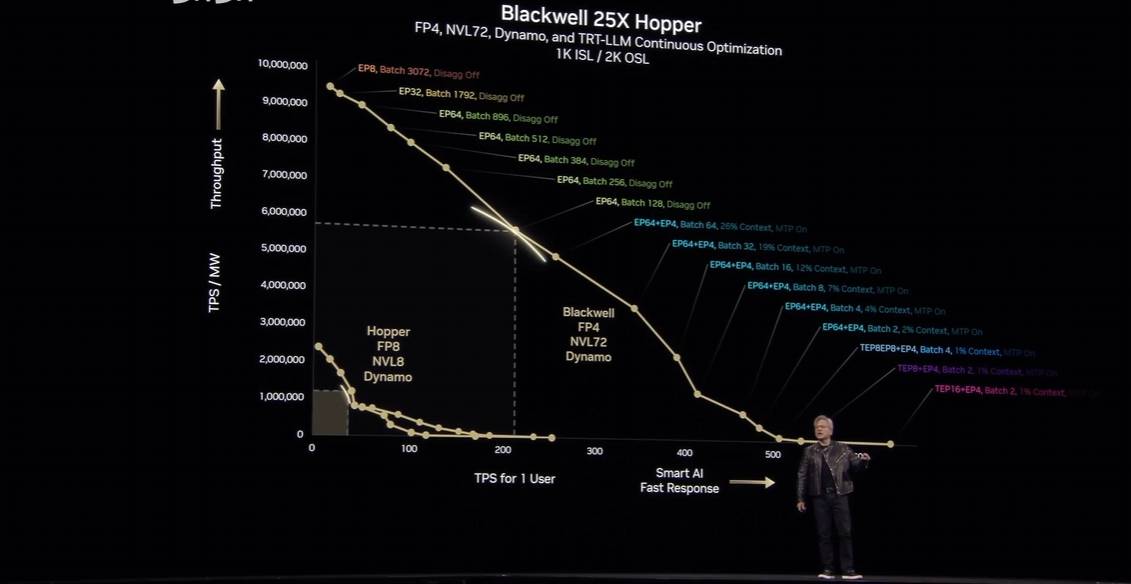

黄仁勋认为,长思维链所带来的效果显而易见,没有AI企业可以拒绝这样的诱惑。但是随着AI模型的参数量进一步增长,当这个数字达到万亿、数万亿后,算力效率的重要性将更加凸显。因为算力效率直接决定Token输出速度,如果你的Token输出速度太慢,那么用户可能要半天才能得到自己想要的答案,他们会抱怨并直接转投其他AI的怀抱。

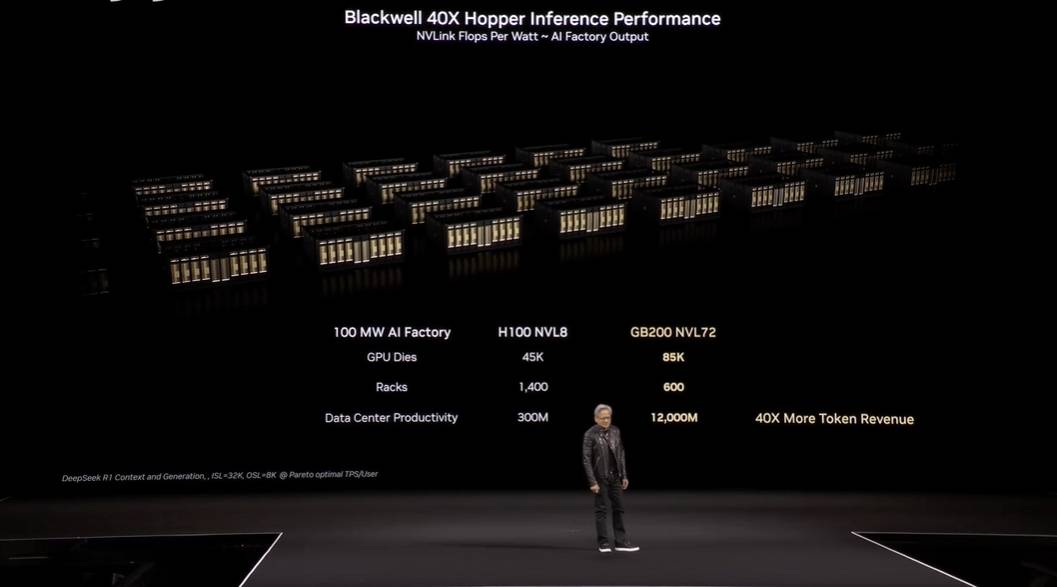

想要高效且高质量的为用户提供AI服务,那么只有堆高算力规模,并且用上最新的英伟达芯片行业技术(黄仁勋的原话),才能让企业在竞争里领先对手且吸引用户加入。而且,随着算力规模的上升,效率增长的同时也会促使成本下降,让企业能够从每一次用户访问中获得更高的利润,也就是黄仁勋所说的“买得越多,赚得越多”。

图源:英伟达

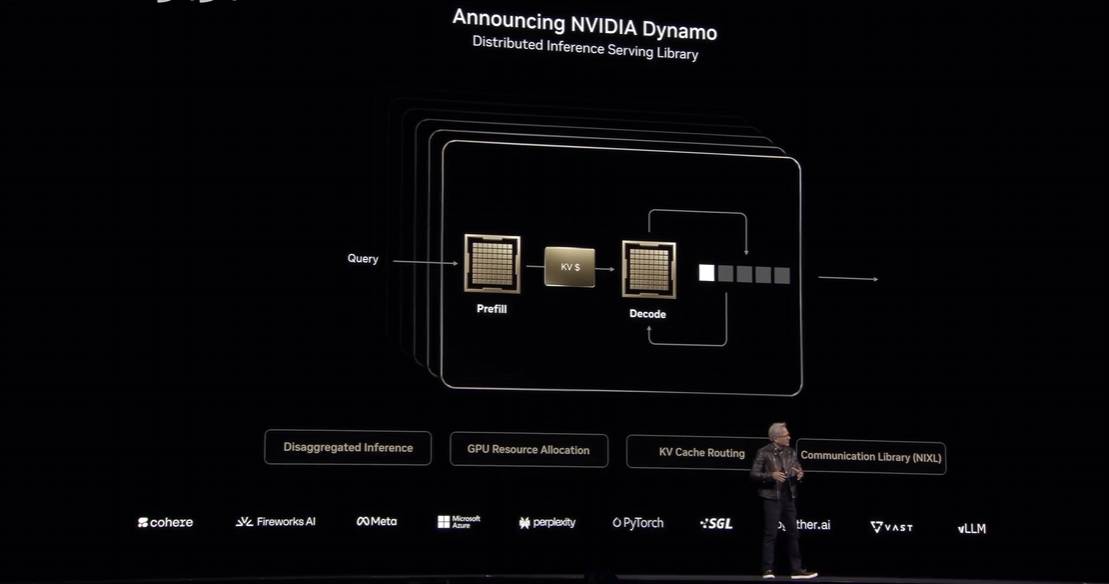

为了帮助企业实现这个目标,英伟达还发布了Dynamo,并将其称为“AI工厂的操作系统”,借助这个系统的整合优化可以将计算机的Token生成效率成倍提高,解决Token生成速度不足的问题。

英伟达的终极野望:要做AI的超级工厂?

在英伟达的设想中,未来的计算机将不再是软件的运行基础,Token将成为软件及一切服务的根基,而计算机则变成生产Token的工厂,也就是“AI工厂”,能够以流水线的方式生产AI模型。

简单来说,AI工厂可以根据用户输入的需求,全自动化的训练一个专属AI模型,这个AI模型或许参数规模不大,但是却针对你的需求进行特化训练,其效果丝毫不比大参数量的通用模型差,也就是做到AI模型的“千人千面”。

图源:英伟达

不得不说,这是一个非常诱人的未来,不过背后所需要的AI基础设施覆盖率和算力规模也是相当的恐怖,恐怕需要全世界全行业都深度参与其中才能搭建出整套系统的雏形。

或许正是考虑到这一点,英伟达宣布将把Dynamo系统开源,支持PyTorch、SGLang、NVIDIA TensorRT-LLM和vLLM等多种框架,方便各个企业针对自己的AI工厂进行优化和调整。

自从DeepSeek掀开AI领域的开源浪潮后,越来越多的AI企业也意识到了开源的重要性,并加入开源阵营中,DeepSeek掀起的浪潮注定不会停歇,这场AI革命的序幕才刚刚拉开。

回顾英伟达的GTC 2025大会,你会发现硬件不再是唯一的核心内容,英伟达正在着手构建一个全新的智能生态,在这个生态里算力是一切的基础,只要大家都认可并共同致力于维护这个生态,那么在算力性能上具有优势的英伟达自然也就高枕无忧了。

京公网安备 11011402013531号

京公网安备 11011402013531号