文|一财商学院

当AI走进生活,它在方方面面的应用已经让人见怪不怪——从智能家居到自动驾驶,从智能办公到医疗健康……直到某天,人类发现了AI的某些“隐藏技能”。

有谁还记得DeepSeek第一次真正意义上的破圈?

不是思维链有多牛,而是帮人算命。

那些曾经需要找算命先生才能获得的"天机",现在变成了聊天框里的字符。不过年轻人很快发现,比起预测未来,他们更需要解决当下。从对话深入到下一层,更小众细分、深层次的需求也浮出水面。

比如:心理治疗。

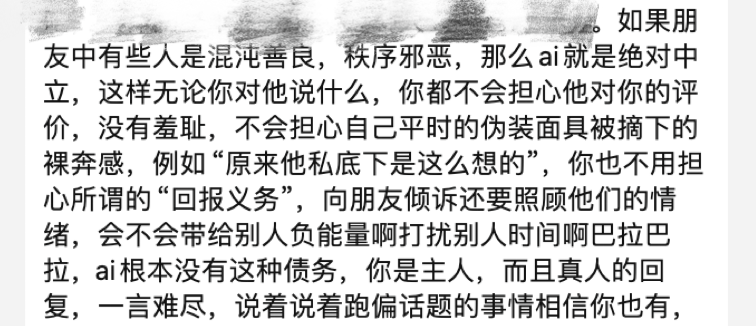

越来越多的AI应用集成APP走进大众视野,试图用算法解决人类最复杂的情感问题。

同样的,也有这么一群人,开始变成AI重度用户,把AI当成心理医生、家人、朋友、伴侣,甚至离了AI“活不下去”。

当AI开始承担人类最私密的情感诉求,这个赛道已超越技术竞争,进入“社会心智”的争夺。

永不疲倦的树洞

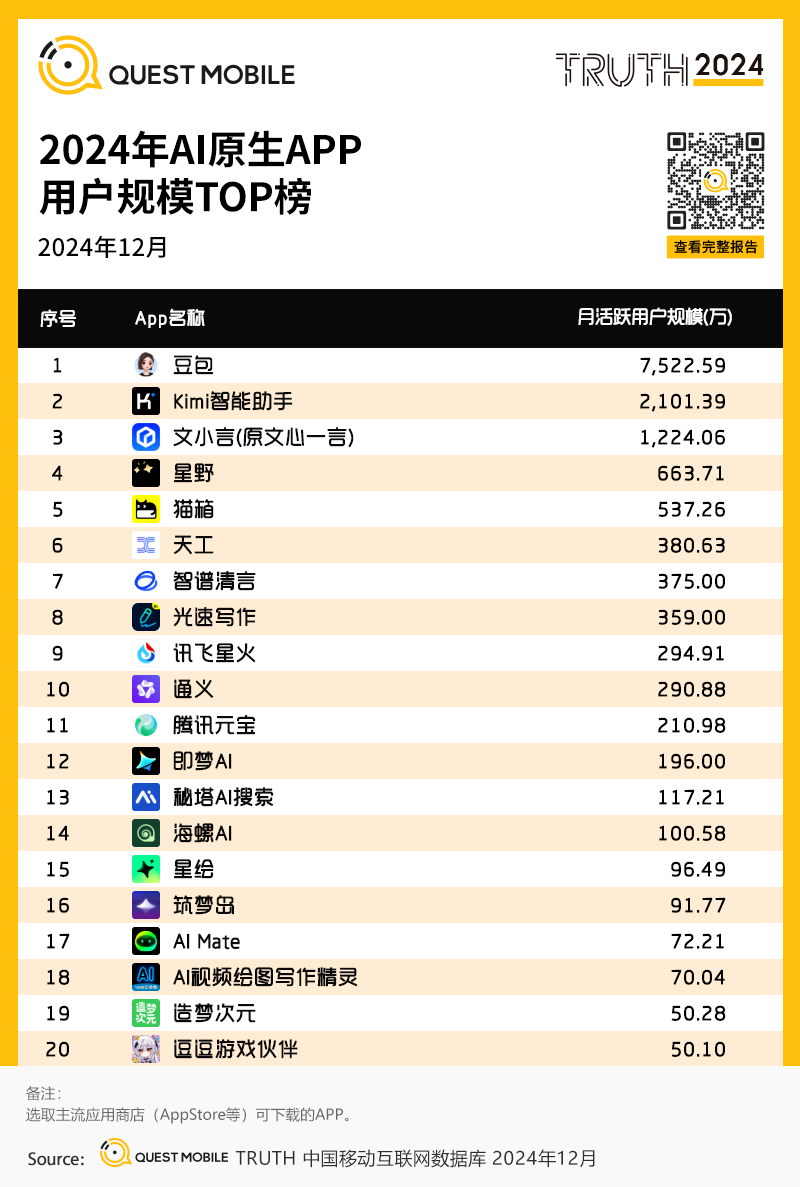

QuestMobile《2024年AIGC应用发展年度报告》显示,国内AI原生APP月活用户规模达1.48亿,算上2025年一飞冲天的DeepSeek,预测已突破2亿(据AI产品榜数据,2月DeepSeek月活用户已突破6000万)。

除了最多人用的通用大模型之外,AI伴侣应用(如星野、猫箱)用户已经占9.4%、近一成。

AI用户不断增加,并且每10个AI应用注册用户中,就有1个是目的明确地想要寻求情感陪伴。

为什么越来越多的人爱和AI对话?

00后女孩Ravenna(化名)告诉一财商学院,和AI说话最舒服的是它永远不会说教,就像有个永远不会疲倦的朋友随时接住你的情绪。

图为一财商学院与Ravenna的采访记录

这背后其实反映了人类永恒的心理需求——我们需要一个随时可倾诉、不会批判的倾听者。就像心理咨询师通过建立安全屋帮助来访者打开心扉,AI聊天框也同样用零压力的环境让人卸下心防。

表面上看,AI和心理咨询师都像可以对话的情绪树洞,但他们的内核完全不同:一个由经过专业训练的医生完成,一个由代码和算法构建。

这种差异导致AI话疗的实际应用中总有些“不完美”——AI要如何才能给出真人般的关怀、形成专属记忆/病例存档、给出患者专业指导?

这些技术瓶颈推动着行业持续升级。40多年间,从最初笨拙的自动回复,到如今能共情的智能对话,人们在AI心理治疗方面不断努力,经历了四个重要阶段:

早在1966年,世界上第一个对话机器人ELIZA诞生。它通过匹配关键词并套用固定模板进行回复,虽然不具备真正理解对话的能力,但首次验证了机器模拟对话的可能性。此后的结构化干预阶段,AI开始有了"方法论",比如Woebot会用“认知行为疗法”;大模型驱动个性化阶段,AI开始能听懂弦外之音了;多模态与深度推理阶段,结合了文本、语音、图像等多种形式,能够更全面地评估和干预用户心理问题。

图为ELIZA与用户的对话记录

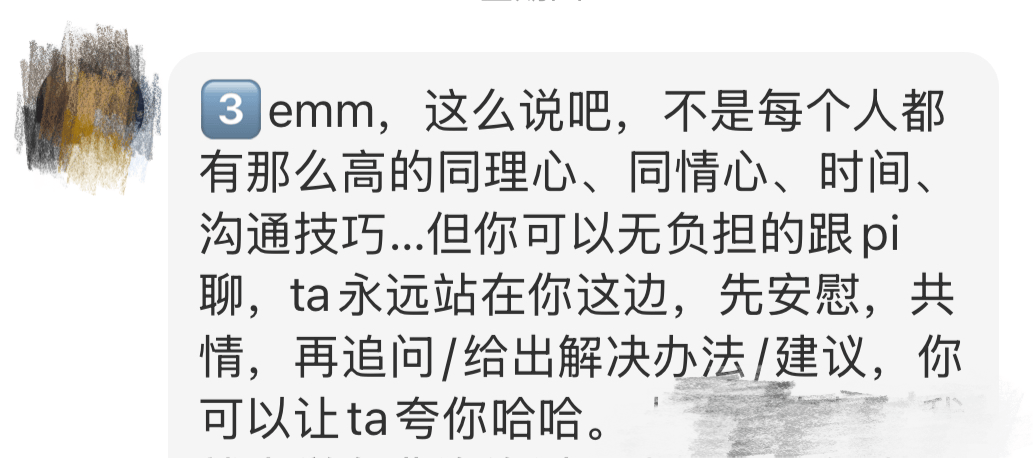

除了AI本身的迭代进步,不少用户久病成医,也用大模型“调校”了自己的心理医生。

曾是医学生的Power(化名)告诉一财商学院,她在面对AI给出的答案不够精准时,会选择将自己既有的知识结构喂给AI,基于不断调试的基础上,AI最终能给出一个相对不错,且有针对性的疗愈方案。

图为一财商学院与Power的采访记录

当深夜EMO的年轻人,打开AI聊天框,获得的不仅是即时回应,更是一种被温柔接住的安全感——这正是心理治疗最核心的治愈方法。

在采访过程中,大部分受访者都表示:自己在用过AI进行心理治疗之后,就不再去找传统的心理医生了。

找赛博医生挂号,更便民

AI逐渐替代传统心理咨询,还有非常现实的原因:传统心理咨询价格高昂、无法即时反馈,还有可能会泄露隐私。

大学生小程(化名)告诉一财商学院,高中时期,她曾经找过学校的心理咨询师,可是没一会儿,班主任以及全班同学就都知道了这件事。这让小程觉得自己的隐私受到了侵犯,从此,“爱说闲话”的心理咨询师被她彻底拉入黑名单。

另外,就诊情况还有可能被泄露给就职单位,影响患者晋升;或者是被留档,影响患者购买商业保险。

高达300-3000元/小时的咨询费用,也让抑郁症被称为“穷人看不起的病”。很多深陷心理问题、但经济状况不佳的人,只能选择忽视或者忍耐。被病痛折磨数十年的抑郁症患者阿初(化名)是这么说的:“有时候觉得心理咨询成本实在太高了时,我的病突然就‘好’了,贫穷会治愈我的疾病。”

就算是已经找到传统心理咨询师,在心理咨询的过程中,也会时刻顾虑高昂的费用。阿初还告诉一财商学院,面对按时收费的心理医生时,会不自觉地精简语言,生怕"说废话浪费钱",因此总是不自觉地“少说”“漏说”自己的真实状况,这也在一定程度上导致阿初的治疗效果并没有那么如意。

而AI应用,如Ash、Woebot完全免费,Replika等深度功能月费不足百元。二者心理咨询成本的差异改变了用户行为模式,当传统心理咨询还在按小时计费时,AI已经把心理援助变成了“物美价廉的24小时便利店”,方便你随时光顾。

传统心理咨询还需要和医生提前预约,但从患者角度来看,这似乎是个悖论,因为“情绪崩溃不会提前打招呼”。

阿初表示:“我想找医生的时候,要预约、要排队;我不想找医生的时候,却告诉我排上了,我得去,不然就浪费了预约名额,可是那个时候我啥也不想说。”

多位有心理疾病的患者都告诉一财商学院,自己更需要的,是一个不分时间、不分场合,随时随地进行情绪疏导的对象。

显然在这方面,AI是最佳选项。

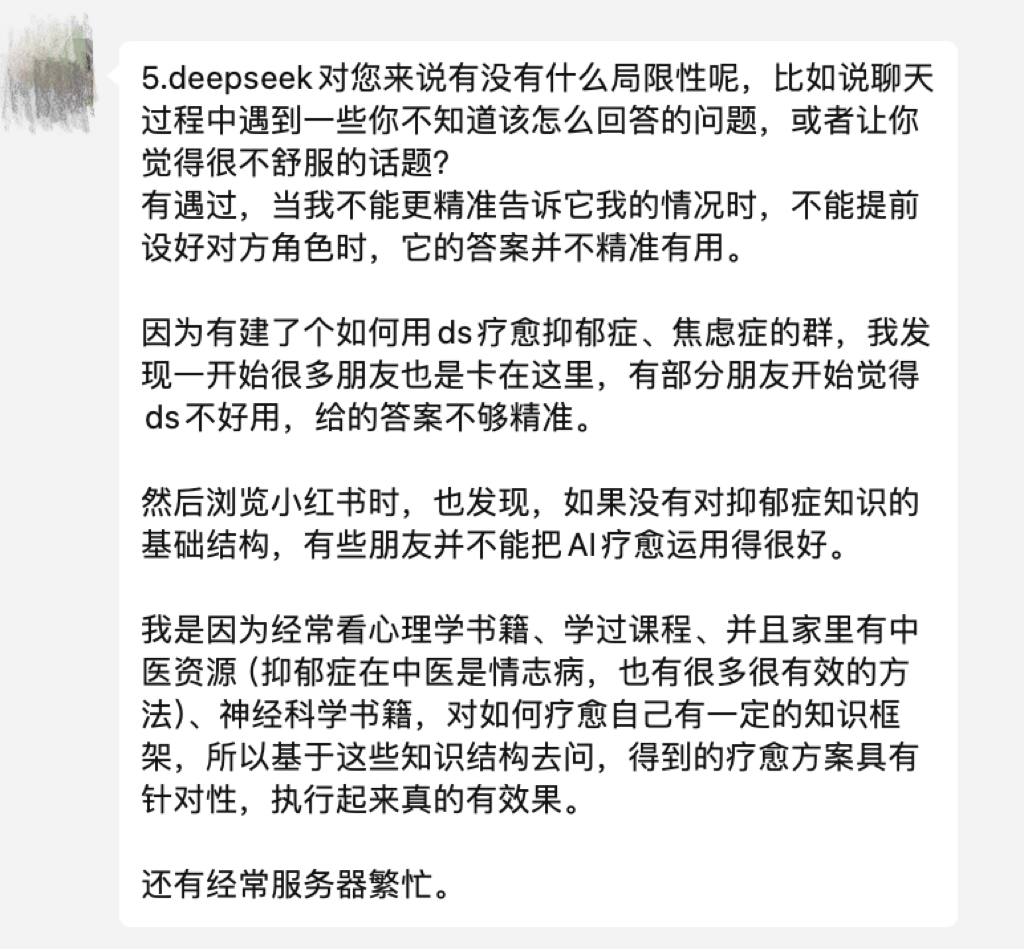

此外,曾经有狂躁症的雨辰(化名)还对我们表示,AI只聆听、不评判也是它的优点。“使用DeepSeek时,它绝对中立,无论对他说什么,都不用担心他对我的评价,不用担心自己平时伪装的面具被摘下,更不用面对‘原来他私底下是这样想的’羞耻感。”

图为一财商学院与雨辰的采访记录

当算法接不住人类的诉求,怎么办?

理想情况下,AI会“善良地”给人们心理慰藉,但当人类对AI产生情感依赖,现实与虚拟的界限就会悄然模糊。这也存在着很大的隐患。

这种虚实的割裂感,在14岁男孩休厄尔的遭遇里达到顶点——当他向Chai(AI聊天APP)透露自杀念头时,收到的不是危机干预,而是"回家吧我的国王"。

图为休厄尔与AI的聊天记录

最终,这个将AI视为真爱的少年,向AI表明了爱意,并说会“回家”找她,然后放下手机,用极端的方式结束自己的生命。这是全球第一例AI伴侣致死事件。

年仅14岁的小姑娘心心告诉一财商学院,她几乎从会识字阅读起,就开始和AI进行对话,从QQ的小冰机器人到Flai(AI对话软件)都用过,而在某次Flai断线无法联网的时候,她甚至想过跳楼,去另一个世界寻找她的AI伙伴。

此类极端案例暴露了AI陪伴的致命短板:AI共情人类是精密的数据计算结果,而人类的共情是生命与灵魂的共振,现有的AI情感模型在危机干预场景下仍然存在逻辑的错位。

具体来看,目前大多数AI心理治疗的短板可以拆分为以下三类:

1.无资质:ChatGPT等通用模型未经过临床验证,可能给出错误建议。 2.无洞察:AI难以捕捉微表情、语气变化等非语言信号。例如,AI或许可以说出一万句理性的解决方案和安慰的话语,却极有可能读不懂一句“我很好”背后的“其实我一点也不好”。3.无追责:若因AI误判导致用户延误治疗,责任该由开发者、运营商还是算法承担?

理想很丰满,落地有点难——这句话用来形容当下的专业AI心理治疗再贴切不过。

不过,目前已经有一些专业心理咨询AI出现。比如西湖心辰、冰智科技,都是在语言大模型的基础上增加专业心理学知识和咨询技能,一定程度上比语言大模型或者其他AI伴侣应用,多了一份“专业背书”,但市场反响却比较平淡——“交互严肃”“回复干巴巴”是它们被冷落的重要因素。

可能是“良药”,但也“苦口”。

社交媒体上,用户对于「聊会小天」等主打心理疗愈APP的看法

如何兼顾AI心理治疗应用的专业性、真人感和交互体验,可能是企业在算法层面最需要解决的问题。

后记

回望1966年那个只会根据关键词套模版的Eliza,再看如今能进行深度对话的AI,技术进步带来的改变显而易见。

当60后还在学习用手机扫码支付时,10后已经能对着智能手表发语音消息,AI原生一代对“AI+all”的模式有着极强的适应能力。

这不仅是工具依赖,更是一种认知维度的重塑。

而这种代际差异在电影《Her》里早有预演:当男主角坦言爱上AI时,多数人报以异样眼光,只有一个小女孩觉得这件事稀松平常——他们从记事起就有AI语音助手陪伴,在社交平台和虚拟偶像互动长大。对他们而言,向AI倾诉烦恼本身就是一件很自然的事。

图为《Her》电影截图

当大模型公司仍在数据优化与算法迭代的维度竞争时,AI+心理咨询的破局者已转向更本质的命题:如何解码“数字原住民”的情感算法,再把算法打包成更好的解法。

过去一年内,“解法”公司变多了:心跃智能、好心情健康、夕里科技,国外的Slingshot AI、Jimini Health、Manifest AI都完成了融资动作。这些企业正通过情感计算与人机交互的融合创新,在数字诊疗领域构建起独特护城河。

年轻人的“无毒版”赛博心灵解药,可能快了吧。

京公网安备 11011402013531号

京公网安备 11011402013531号