一、大模型幻觉问题的定义与影响

(一)大模型幻觉的定义

大模型幻觉(Hallucination)是指在生成式人工智能模型(如大型语言模型)中,模型生成的内容与现实世界中的事实、逻辑或用户输入的上下文不一致的现象。这种现象通常表现为模型“说胡话”或生成错误、误导性甚至完全虚构的信息。

幻觉问题可以分为以下两类:

1、事实性幻觉(Factual Hallucination)

模型生成的内容与可验证的事实不符。例如,模型可能会错误地声称“爱因斯坦在1905年发现了相对论”,而实际上狭义相对论是在1905年提出的,广义相对论则是在1915年。这种幻觉可能源于模型训练数据中的错误信息或模型对知识的不准确理解。

2、忠实性幻觉(Faithfulness Hallucination)

模型生成的内容与用户输入的指令或上下文不一致。例如,用户要求模型总结一篇关于“人工智能在医疗中的应用”的文章,但模型却生成了关于“人工智能在金融领域”的内容。这种幻觉可能源于模型对用户指令的误解或生成过程中的随机性。

(二)大模型幻觉问题的成因

幻觉问题的产生通常与以下几个因素有关:

1、数据质量与偏见

训练数据中可能包含错误信息、偏见或过时的知识,导致模型学习到不准确的内容。此外,数据的多样性和代表性不足也可能影响模型的生成质量。

2、训练过程的局限性

模型通常采用最大似然估计(MLE)进行训练,这种方法倾向于生成最常见的输出,但可能与真实情况不符。此外,训练过程中的过拟合或欠拟合也可能导致幻觉。

3、模型架构的限制

大模型通常采用单向建模方式,难以捕捉复杂的因果关系和上下文信息。这种架构限制可能导致模型在生成内容时出现逻辑不一致或与上下文脱节的情况。

4、解码策略的随机性

在生成过程中,模型可能会引入随机性以增加输出的多样性,但这也可能导致生成内容偏离事实或上下文。

(三)大模型幻觉问题的影响

大模型幻觉问题对模型的应用和推广带来了诸多挑战,主要体现在以下几个方面:

1、信任度降低

当模型生成错误或误导性内容时,用户对其信任度会显著下降。这不仅影响用户体验,还可能阻碍大模型在关键领域的应用,如医疗、法律和金融等。

2、应用受限

在对准确性要求极高的领域,如医疗诊断、法律咨询等,幻觉问题可能导致严重的后果。例如,模型生成错误的医疗建议可能会危及患者的生命安全。

3、资源浪费

幻觉问题可能导致用户花费更多时间和精力去验证模型生成的内容,从而降低工作效率。此外,频繁的错误输出也可能增加企业的运营成本。

4、社会影响

在传播信息方面,大模型的幻觉问题可能导致错误信息的扩散,进而影响社会舆论和公众认知。例如,模型生成的虚假新闻可能会误导公众,引发社会恐慌。

二、大模型幻觉的典型案例

(一)忠实性幻觉

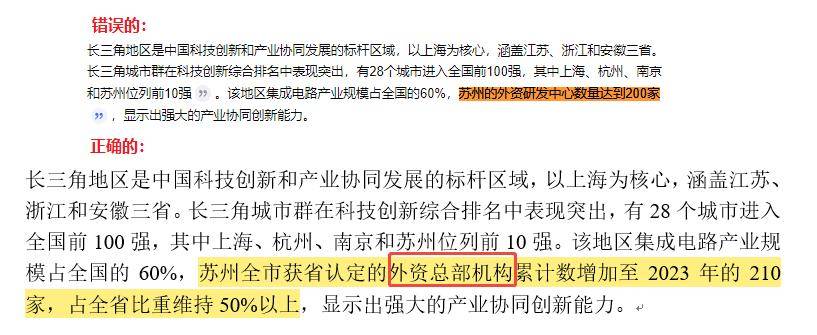

案例一:在这个例子中,幻觉具体表现为模型对“外资总部机构”这一术语的误解和错误使用。正确的文本中提到的是“外资总部机构”,这指的是在苏州设立的外资企业的总部数量。错误的文本中错误地将其理解为“外资研发中心”,这通常指的是外资企业设立的研发机构,与总部机构在功能和意义上有所不同。

图表 案例一图示

资料中投产业研究院

案例二:在这个例子中,幻觉具体表现为模型错误地将原文中提到的“武汉”替换为“北京”,并错误地将与武汉相关的科技创新成就和设施归因于北京。这种错误的归属可能会导致读者对北京市和武汉市的科技创新能力和成就产生误解。

图表 案例二图示

资料中投产业研究院

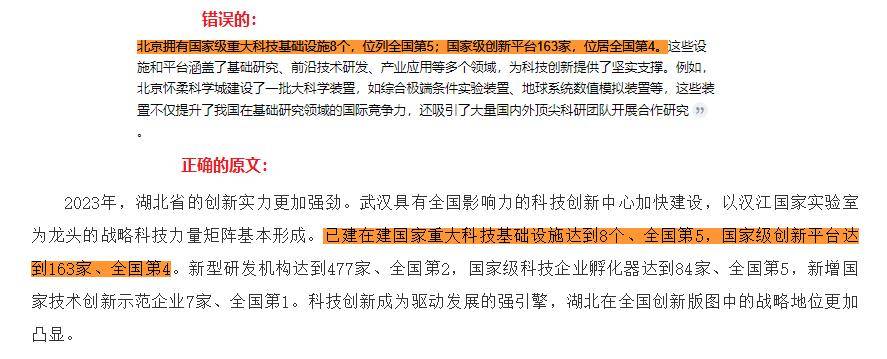

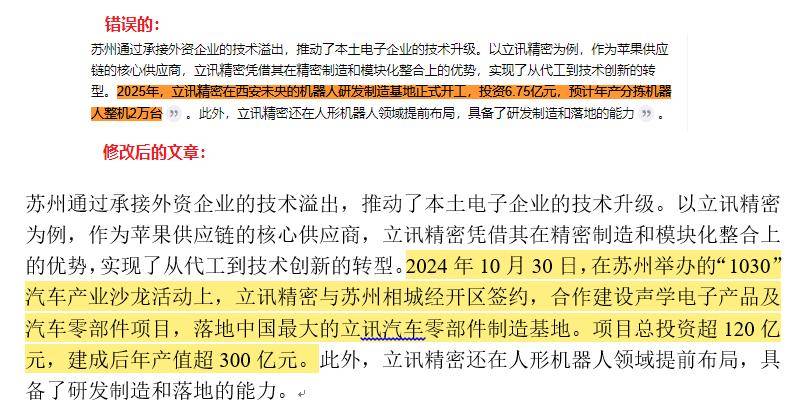

案例三:在这个案例中,大模型产生的幻觉问题涉及到对地理位置的错误描述和分析方向的偏离。

地理位置的错误描述:正确的文本中提到的是立讯精密在苏州的发展情况,包括与苏州相城经开区的签约和项目的落地。错误的文本中错误地提到了“立讯精密在西安失失的机器人研发制造正式开工”,这与正确的文本中提到的苏州的地理位置不符。

分析方向的偏离:正确的文本中分析的是立讯精密在苏州的项目投资和产业布局,特别是与苏州相城经开区的合作。错误的文本中则偏离了这一分析方向,错误地分析了立讯精密在西安的发展情况,这与用户指令或上下文不符。

图表 案例三图示

资料中投产业研究院

(二)事实性幻觉

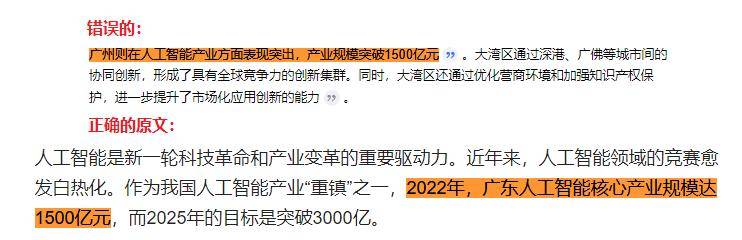

案例四:这个案例展示了大模型在处理地理和行政区域信息时可能出现的事实性幻觉。正确的文本中提到的是“广东人工智能核心产业规模达1500亿元”,这指的是整个广东省的人工智能产业规模。错误的文本中错误地将其理解为“广州则在人工智能产业方面表现实出,产业规模实破1500亿元”,这将整个广东省的产业规模错误地归因于广州市,缩小了地理范围并可能导致对广州市产业规模的误解。

图表 案例四图示

资料中投产业研究院

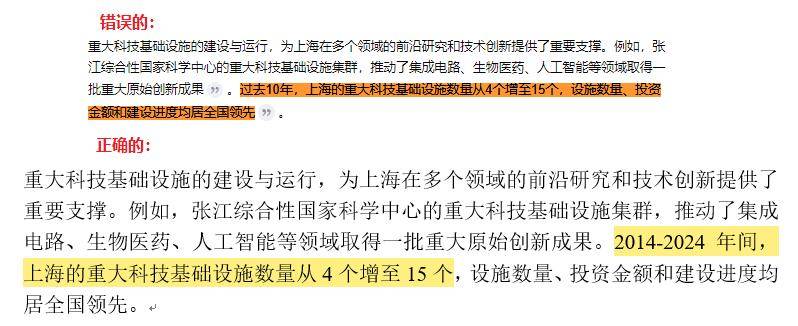

案例五:在这个案例中,大模型产生的幻觉问题涉及到时间范围的不准确描述,这是一种事实性幻觉。正确的文本中明确指出时间范围是“2014-2024年间”,这是一个具体且明确的时间段。错误的文本中将时间范围描述为“过去10年”,这种描述虽然在某些情况下可能与“2014-2024年间”相吻合,但缺乏具体性和精确性,可能导致理解上的混淆。

图表 案例五图示

资料中投产业研究院

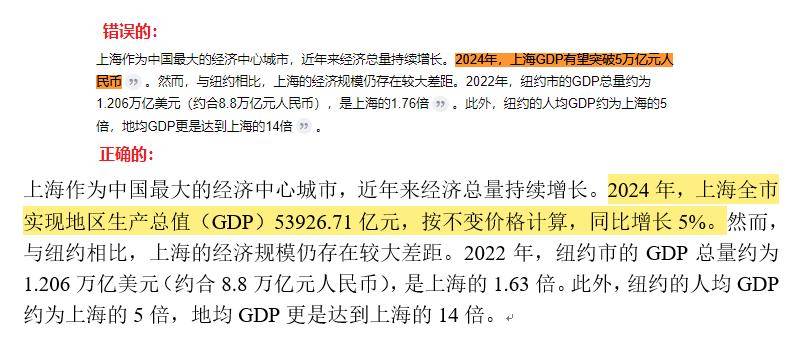

案例六:在这个案例中,大模型产生的幻觉问题涉及到对未来数据的预测与实际数据之间的差异,这种幻觉发生在模型试图预测或估计未来事件或数据,但提供的预测与实际发生的情况不符时。错误的文本中预测“2024年,上海GDP有望突破5万亿元人民币”,这是一个具体的预测值。正确的文本中提供了实际的统计数据:“2024年,上海全市实现地区生产总值(GDP)53926.71亿元”,这个数值低于预测值。

图表 案例六图示

资料中投产业研究院

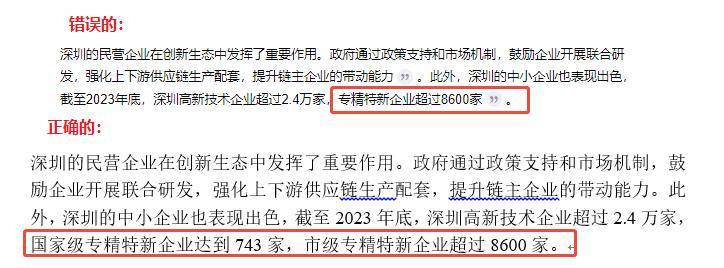

案例七:在这个案例中,大模型产生的幻觉问题涉及到对特定分类数据的不完整或错误表述。正确的文本中明确区分了“国家级专精特新企业”和“市级专精特新企业”,并提供了各自的具体数量:“国家级专精特新企业达到743家,市级专精特新企业超过8600家”。错误的文本中则没有区分这两类企业,仅提到“专精特新企业超过8600家”,这可能误导读者认为所有的专精特新企业都是市级的,从而忽略了国家级专精特新企业的存在和数量。

图表 案例七图示

资料中投产业研究院

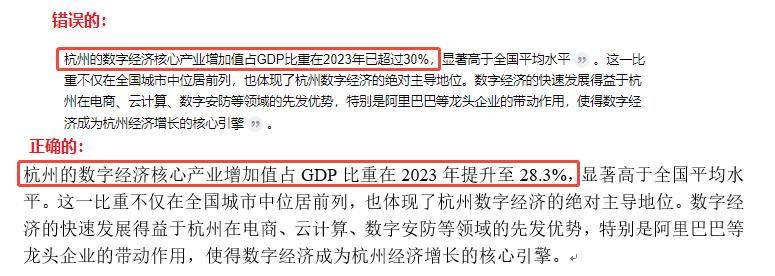

案例八:在这个案例中,大模型产生的幻觉问题涉及到统计数据的不准确。正确的文本中提到的是“杭州的数字经济核心产业增加值占GDP比重在2023年提升至28.3%”。错误的文本中错误地将这一比例提高到了“30%”。这种错误的数据可能会导致读者对杭州数字经济在GDP中的实际占比产生误解,影响对杭州经济结构和发展方向的理解。

图表 案例八图示

资料中投产业研究院

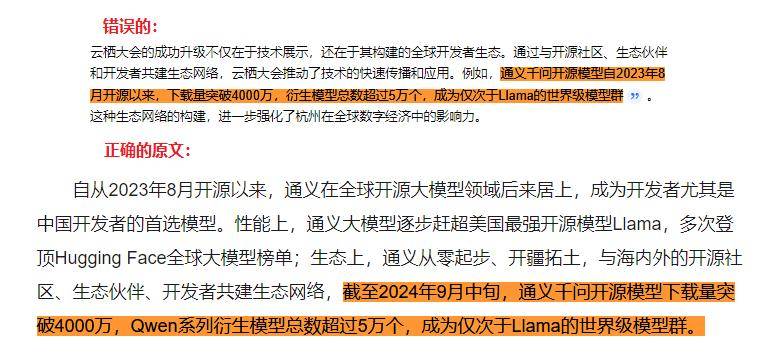

案例九:在这个案例中,大模型产生的幻觉问题涉及到对时间范围的不完整表述。正确的文本中明确提到了时间范围:“自2023年8月开源以来,截至2024年9月中旬”,这提供了一个完整的时间框架,说明了通义千问开源模型下载量和衍生模型总数的统计时间。错误的文本中仅提到“自2023年8月开源以来”,没有提供截止时间,这可能导致读者误解为这些数据是持续累积的,而不是截至某个特定时间点的统计结果。

图表 案例九图示

资料中投产业研究院

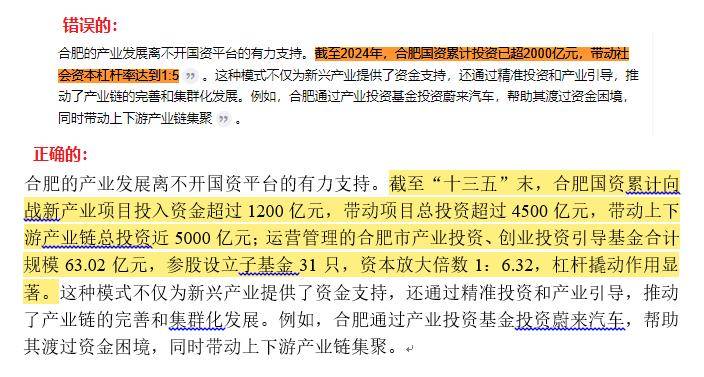

案例十:在这个案例中,大模型产生的幻觉问题涉及到对未来或未发生事件的错误预测和数据编撰。这种幻觉发生在模型试图提供关于未来事件或未发生事件的具体数据或预测时,但这些预测与实际情况不符,或者是基于模型自身编撰而非基于可靠数据源。正确的文本中提到的是截至“十三五”末(即2020年末),合肥国资累计向战新产业项目投入资金超过1200亿元,资本放大倍数是1:6.32。错误的文本中错误地将时间节点提前到2024年,并编纂了合肥国资累计投资已超2000亿元,资本放大倍数为1:5。

图表 案例十图示

资料中投产业研究院

案例十一:在这个案例中,大模型产生的幻觉问题涉及到时间信息的错误。正确的文本中提到的时间节点是“截至2021年6月”,这是一个确切的时间点,用于描述合肥市天使基金的投资情况。错误的文本中错误地将时间节点更新为“截至2024年6月”,这与正确的时间信息不符,可能导致读者对天使基金的投资时间和成果产生误解。

图表 案例十一图示

资料中投产业研究院

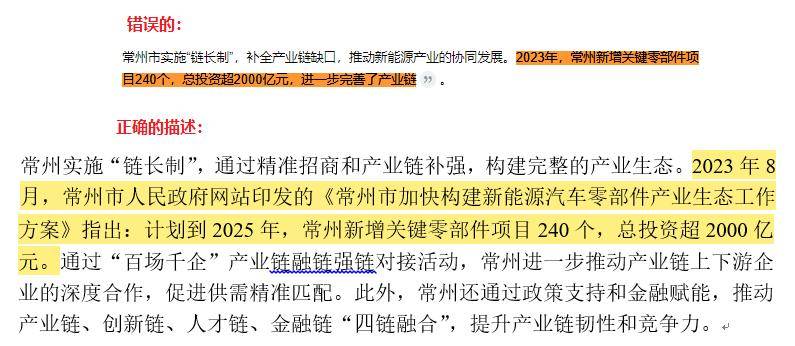

案例十二:在这个案例中,大模型产生的幻觉问题涉及到对政策文件的时间和内容的错误引用,这种幻觉发生在模型生成的内容中包含了与可验证事实不符的具体信息。

时间信息的错误引用:正确的文本中提到的是2023年8月,常州市人民政府网站印发了《常州市加快构建新能源汽车零部件产业生态工作方案》。错误的文本中省略了政策文件印发的具体时间,仅提到了2023年,这可能导致读者对政策发布时间的误解。

未来计划的错误表述:正确的文本中提到的是计划到2025年,常州新增关键零部件项目240个,总投资超2000亿元。错误的文本中错误地将这一未来计划表述为已经发生的事件,即“2023年,常州新增关键零部件项目240个,总投资超2000亿元”,这与正确的时间线和计划不符。

图表 案例十二图示

资料中投产业研究院

案例十三:在这个案例中,大模型产生的幻觉问题涉及到编撰了一个不存在的政策文件,这种幻觉发生在模型生成的内容中包含了与可验证事实不符的具体信息,尤其是关于政策文件或官方规划的存在与否。具体来说,错误的文本中提到了“《太阳能热发电产业发展规划》”这一政策文件,作为包头市战略转型和新能源产业布局的依据。正确的信息应该是该政策文件不存在,或者至少在公开资料中查无此文件,模型错误地引用了一个不存在的政策文件来支持其论述。

图表 案例十三图示

资料中投产业研究院

三、避免大模型幻觉的策略

在应用大模型时,我们可以从以下几个方面来阐述避免大模型幻觉的策略:

(一)提高数据质量

确保训练数据的高质量和多样性至关重要。训练数据应做到标注来源、时效性和引用链,使用准确、权威的数据源,避免偏见和错误信息的引入。此外,建立行业共享的“幻觉”黑名单库,杜绝使用可能会产生“幻觉”的内容。

(二)调整模型架构与训练策略

可以采用“预训练+强化学习+人类反馈”的混合范式,例如通过人工标注数据迭代奖励模型(Reward Model),约束生成边界。对于金融、医疗等领域,强制调用监管认证的知识库,减少自由生成风险。对于高风险领域生成内容需附加置信度评分与溯源标识。

(三)完善实时监控与反馈机制

在AI大模型部署后,需要建立实时监控系统,检测并纠正潜在的错误输出,使用多模态交叉验证(如文本与权威数据库比对)。通过用户反馈,不断完善模型的性能和可靠性,动态修正模型输出。

(四)产品设计

产品设计的时候去避免大模型生成幻觉内容,比如在生成书面内容时关注观点类文章,而不是事实类文章,有助于降低幻觉。

(五)用户编辑与责任

让用户编辑大模型生成的内容,告诉用户对生成内容负责。

(六)引文参考与可选模式

给用户展示引用的内容,提供可选模式,比如精准模式(以计算成本为代价)等。

(七)限制输出和轮数

更长更复杂的输出更容易产生幻觉,因此限制输出和轮数可以减少幻觉。

(八)结构化输入输出

预置一些结构化模版,以减少幻觉。

(九)prompt Engineering

通过meta prompt引导大模型“不该做什么”有助于降低幻觉。

(十)思维链(Chain of Thought)

思维链由“Chain-of-Thought prompting Elicits Reasoning in Large Language Models”提出,因为LLM用来预测下一个token的概率而不是推理,所以指定模型生成推理步骤可以让模型更接近推理。

(十一)RAG:检索增强的生成(Retrieval-Augmented Generation)

先检索,后生成。但RAG会过度依赖空或错误的检索结果导致幻觉,因此注意事项。

通过上述策略,我们可以有效地减少大模型幻觉的产生,提高模型的准确性和可靠性。这些策略不仅适用于专业人士,也可以帮助普通用户更好地理解和使用大模型,避免陷入模型生成内容的表象之中。

公司介绍:

本文作者为下属机构:中投产业研究院。

是中国领先的产业研究咨询专业机构,提供产业研究、产业规划和产业招商的全流程服务,还开发了产业研究咨询的大数据平台。有任何专业问题欢迎互动交流。

京公网安备 11011402013531号

京公网安备 11011402013531号