2 月 27 日消息,在 DeepSeek 开源周第四日,摩尔线程宣布已成功支持 DeepSeek 开源通信库 DeepEP 和并行算法 DualPipe,并发布相关开源代码仓库:MT-DeepEP 和 MT-DualPipe。

据介绍,DeepEP是一个用于 MoE(混合专家)模型训练和推理的开源 EP(expert parallelism,专家并行)通信库,主要适用于大模型训练,特别是需要 EP 的集群训练。它通过优化通信信道的使用率,提升了训练效率。摩尔线程基于 MUSA Compute Capability 3.1 全功能 GPU 适配了 DeepEP,并支持以下特性:

高效优化的 All-to-All 通信,支持 dispatch & combine

支持 MTlink + GPU(MUSA Compute Capability 3.1)节点内通信

训练及推理预填充阶段的高吞吐量计算核心

推理解码阶段的低延迟计算核心

原生支持 FP8 数据分发

灵活控制 GPU 资源,实现计算与通信的高效重叠

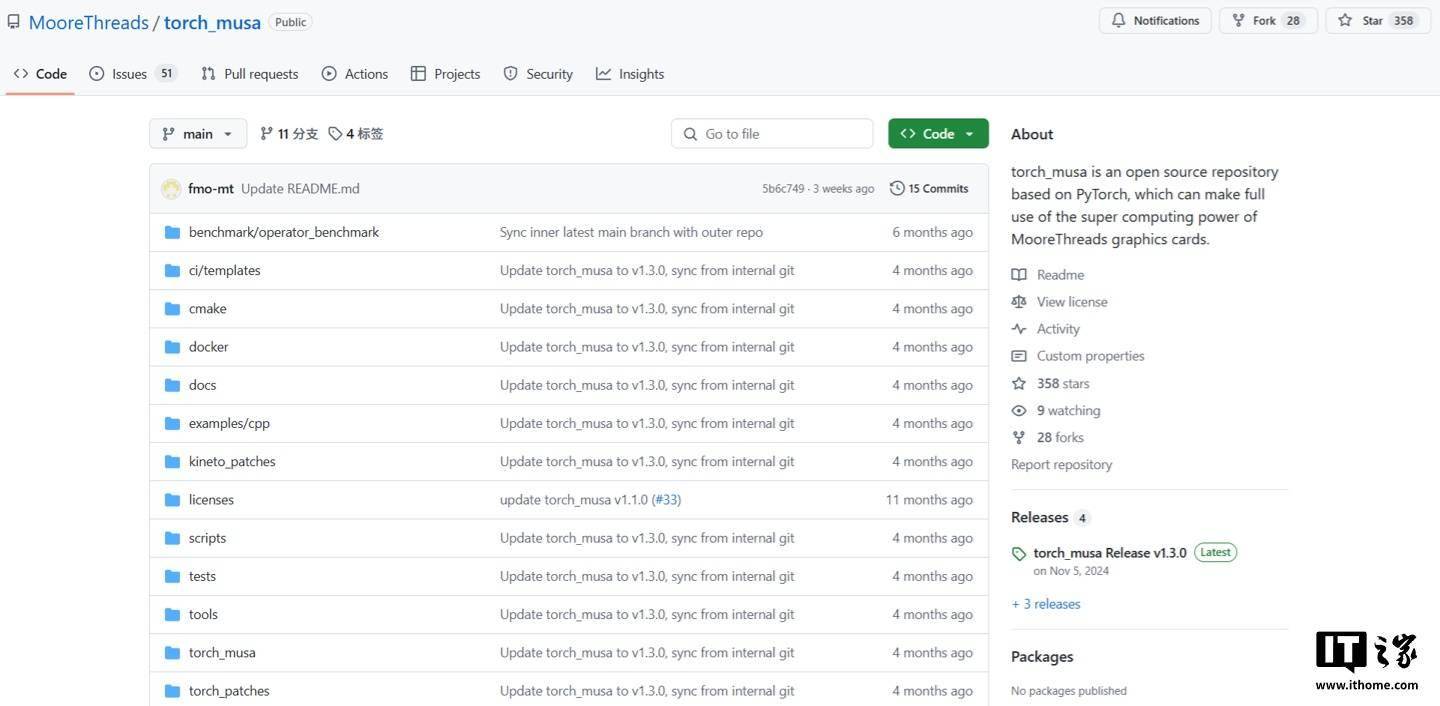

DualPipe是 DeepSeek-V3 提出的双向流水线并行算法,通过前向计算与后向计算阶段的计算与通信完全重叠,减少了“流水线气泡”(设备空闲等待)。摩尔线程依托深度学习框架 Torch-MUSA(已开源)和 MUSA 软件栈全方位的兼容性,实现了对 DualPipe 这一算法的支持。

目前,MT-DualPipe 可以完整接入摩尔线程 MT-Megatron 框架和 MT-TransformerEngine 框架(即将开源),实现 DeepSeek V3 训练流程完整复现。此外,MT-DualPipe 结合 MT-Megatron 可实现完整 DeepSeek V3 模型 MLP-FFN 分离以及 DW-DG 分离,进一步降低气泡占比,优化通信效率。同时,MT-DualPipe 与 MT-TranformerEngine 和 MT-DeepEP 的结合,可利用 MT-DeepEP 和异步通信引擎实现更高效的通信掩盖,降低对计算资源损耗。

附 Torch-MUSA 开源地址如下:

京公网安备 11011402013531号

京公网安备 11011402013531号