马斯克推出的最新版AI大模型,可能正式宣布了,西方大模型路线即将终结。

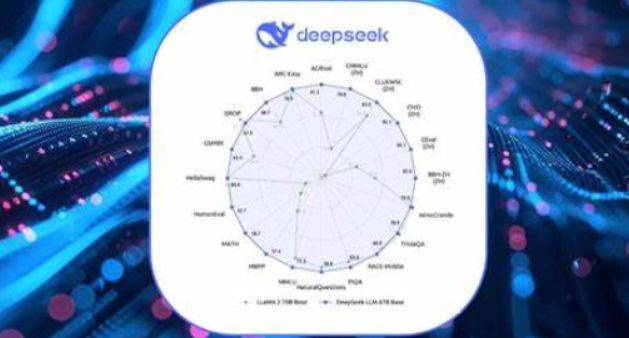

马斯克除了用政府效率部,最近在美国搅的翻天覆地之外,其实本职工作他倒是也没耽误。一方面,他的火箭正常上天,不断的送卫星。二方面,马斯克名下的xAI公司,最近也推出了号称,到目前为止最强的人工智能大模型,也就是grok3。grok3的发布会上,马斯克是展示了它,在包括推理能力等等,针对,已有的包括了,谷歌的大模型,包括我们,非常熟悉的DeepSeek的大模型,是有相当大的长进。只不过,在PPT里面我们看到,其实它所谓的大幅的性能增长,用了一点点,我们说叫做比例尺的魔法。大家如果看它的比例尺就会发现,比例尺并不是从0开始,而是截取了一段数字,然后专门显示差距部分,特意的放大了差距。更让大家感到惊讶的是,马斯克在grok3上面,投入了巨量的计算资源。

有消息称,为了运行大模型,马斯克新增加了一个20万张计算卡的计算中心,它整个模型推理的计算量,比起我们DeepSeek最新版本,它的计算量是达到了263倍之距的计算量。相比之下,我们的DeepSeek只用了2048张,比马斯克还要低几个档次的计算卡,就实现了非常好的推理性能,这一下就比出了两条路线,两个大模型之间巨大的差别。说白了,马斯克的大模型,还是在尊重所谓的scaling law,也就是比例缩放的定律,迷信的是什么?我的参数规模越巨大,它的性能就会越优异。而我们中国的这些大模型,以DeepSeek为代表大模型,走出了另外的一条路,我们从模型的基础架构上,就相对的不同。

DeepSeek,使用了一种叫做Moe的基础的架构,因此它的训练的效率会更高。不仅如此,不只是一个DeepSeek团队,中国还有其他的一些人工智能团队,还提出了更新的人工智能算法的架构,甚至能比DeepSeek效率再提高83%。这也就意味着,我们是在有限的算力条件下,搞多、快、好、省的计算方向。比起那种纯粹靠堆料,靠上计算卡,来搞的人工智能的大模型,它的使用成本是远远降低的,这其实是有非常大深远的意义的。

我们都知道像DeepSeek这样的一个模型,是可以在个人的电脑上,或者说,中小型企业搭建的小型数据中心上,进行计算运行的,并且还是一个满血版的。这就意味着,这些大模型,它的应用场景会极大的丰富,它的使用门槛会极大降低,特别是我们之前说到的,大模型全世界平权的时代,在DeepSeek这类开源。而且非常节约算力的大模型下,会更快的到来。

相比之下,西方走的还是那一套,靠垄断资源大量计算,去提高性能,去进行应用的大模型思路,恐怕已经接触到了它的天花板,已经遇到了瓶颈,这也很好想象,不是说我多加几块计算卡,大模型的性能就会增加,它最终会触达一个极限,它的边际效应,随着卡的数量的增加,是一个递减的一个效果。因此只有,从根本上去改变一个基础的逻辑,才有可能进一步的提升大模型的,运用的场景,才有可能提升它的效率。现在看来,包括马斯克,包括open AI,西方一众的这些大模型,恐怕都在接触到大模型,它们算法的上限。而反观包括中国在内的,我们这些新兴的大模型玩家,我们可能正在走向,大模型未来发展的正确道路。

京公网安备 11011402013531号

京公网安备 11011402013531号