机器人前瞻(公众号:robot_pro)

作者 | 许丽思

编辑 | 漠影

机器人前瞻2月21日报道,刚刚,美国人形机器人独角兽Figure AI重磅推出了一款通用型视觉语言动作(VLA)模型——Helix,能够将感知、语言理解与学习控制融为一体,首次实现了对人形机器人完整上半身高速连续控制。

只需一句自然语言指令、不需要任何事先演示或定制编程,人形机器人就能抓取几乎所有家庭小物件,包括数千种训练时从未接触过的物品。

一、首次实现人形机器人上半身高速连续控制

Figure表示,Helix模型创造了多项业界首次:

全上半身灵活操控:Helix是首个能对仿人机器人完整上半身(包括手腕、躯干、头部及每根手指)实现高速连续控制的VLA模型。 多机器人协作:Helix首次让双机器人系统协同完成长期复杂任务,两台机器人能共同处理从未见过的物品,例如合作整理陌生杂货。 万物皆可抓取:机器人现在只需一句自然语言指令,就能抓取几乎所有家庭小物件,包括数千种训练时从未接触过的物品。 单一神经网络:与过往技术不同,Helix仅用一套神经网络参数就能学习所有技能——取放物品、开关抽屉冰箱、跨机器人交互等,无需任何任务专属微调。 商用就绪:Helix是首个完全运行在低功耗嵌入式GPU上的VLA系统,已具备直接商业部署能力。在测试中,机器人机器人成功地处理了数千件杂乱无章的新物品——从玻璃器皿和玩具到工具和衣服,并且无需任何事先演示或定制编程。

值得一提的是, 当提示“捡起沙漠物品”时,Helix 不仅会识别出玩具仙人掌符合这个抽象的概念,还会选择最近的手并执行所需的精确运动命令,牢牢地抓住它。

这种通用的“从语言到动作”的抓取功能为在非结构化环境中部署人形机器人提供了更大的可能性。

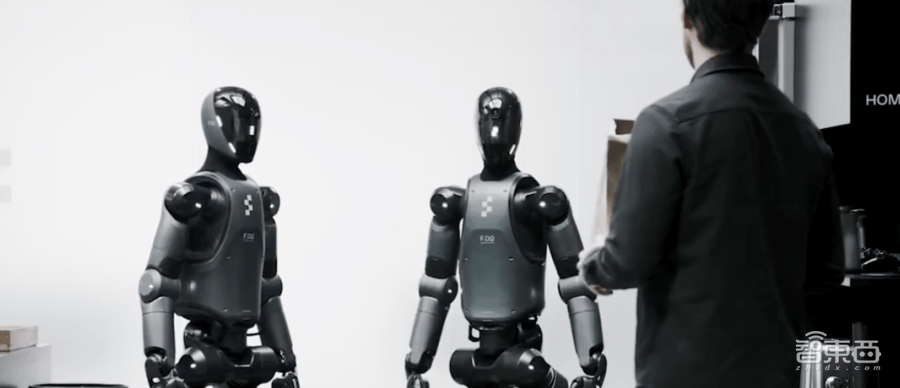

在一个更加复杂的应用场景中,当主人把Figure机器人从未见过的杂物放置在桌上时,两个机器人可以进行相互协作,把杂物进行归类放置。

机器人甚至细心到,知道瓶装的物品应该放置在冰箱门上的置物筐中才不会容易翻倒,而不是往冰箱里随便一塞就了事;另一个机器人,还明白饼干应该放置到抽屉中。

收拾好后,它们还会记得贴心地把抽屉关好、关上冰箱门。

二、开创性采用双系统架构

Helix的系统由两个部分组成——即”系统1+系统2″架构,实现对仿人机器人上半身的高速精准控制:

系统2:基于7B参数的开源VLM,以7-9Hz频率运行,负责场景理解与语义解析,确保跨物体、跨场景的泛化能力。

系统1:80M参数的视觉运动策略模型,以200Hz频率将S2的语义表征转化为连续动作指令,实现毫秒级实时响应。

这种解耦架构让两个系统各司其职:S2专注慢思考,负责制定战略,S1负责实时执行和调整行动术。

和现有方法相比,Helix采用的这种设计,使其可以兼顾速度和泛化,在保持专业单任务策略速度的同时,零样本泛化处理数千种新物品,并且可拓展性强、架构极简,还能允许开发者单独迭代每一个系统。

据了解,Helix仅凭借极少的资源,就实现了强大的物体泛化能力。团队训练Helix总共使用了约 500 小时的高质量监督数据,这只占先前收集的视觉语言动作(VLA)数据集规模的5%不到,而且无需依赖多机器人实体收集或多阶段训练。

并且,尽管数据需求相对较少,但Helix依旧能够扩展应用到更具挑战性的全身型仿人机器人上半身控制的动作空间,实现高速率、高维度的输出。

结语:人形机器人加入融入人类生活

与在规范化的工业环境不同,机器人如果要真正应用到家庭环境中,就必须应对家庭环境中各种不可控的因素,每个物品都有不可预测的形状、大小、颜色和纹理,机器人会面对许多以前从未见过的物体,需要能够按照实际情况生成智能新行为。

而作为首款能根据自然语言指令直接控制整个人形机器人上半身的VLA模型,Helix无需任何针对特定任务的示范、无需大量的手动编程,就能即时生成长期的、协作性的、灵巧的操作动作,展现出了强大的物体泛化能力。

这种能力,展现出人形机器人实现近乎人类的环境适应性的巨大潜能。而随着模型规模的不断扩展,也将为人形机器人真正进入家庭等更多负责环境、融入人类生活创造了更多可能性。

京公网安备 11011402013531号

京公网安备 11011402013531号