图为xAI用以训练 Grok 3的由20万块GPU组成的计算中心。

按:北京时间2月18日中午12时30分左右,马斯克携其xAI三位门徒,通过视频直播对外发布最新版本语言大模型Grok 3,自称是迄今“地球上最聪明的人工智能”。

以外界观感,当前的Grok 3似有半成品之嫌,但它所对外展示的“跑分”数据仍令业界——尤其是科技爱好者感到震撼。甚至发布会后,A股连续炒作数周的DeepSeek概念高位股大面积跳水,颇有“终结者”般映射意味。

Grok 3的实力究竟如何,特斯拉前AI总监、OpenAI创始成员Andrej Karpathy作为最早拿到测试资格的人之一,很快给出了他的评测。从初步测试看,作为20万块最先进GPU训练出的性能怪兽,Grok 3固然足够先进,但在DeepSeek为整个行业祛魅之后,亦显然称不上马斯克放出的豪言那般“秒天秒地秒空气”。

以下为Andrej Karpathy对Grok 3评测观点:

今天(2月18日)早些时候,我获得了 Grok 3 的早期使用权,因此我认为我是第一批可以进行快速测试的人之一。

01

思维

✅首先,Grok 3 显然拥有最先进的思维模型(“思考”按钮),并且在我的“卡坦岛”问题上表现出色:

“创建一个显示六边形网格的棋盘游戏网页,就像游戏中的 Settlers of Catan 一样。每个六边形网格的编号从 1 到 N,其中 N 是六边形瓷砖的总数。使其通用,以便可以使用滑块更改“环”的数量。例如,在 Catan 中半径为 3 个六边形。请使用单个 html 页面。”

很少有模型能够可靠地做到这一点。顶级的 OpenAI 思维模型——例如 o1-pro,每月 200 美元——也能做到这一点,但 DeepSeek-R1、Gemini 2.0 Flash Thinking 和 Claude 目前都没有做到这一点。

❌它并没有解决我的“表情符号之谜”问题,我在 Unicode 变体选择器中隐藏了一个带有附加消息的笑脸,即使我以 Rust 代码的形式给出了如何解码它的强烈提示。我看到的最大进展来自 DeepSeek-R1,它曾经部分解码了该消息。

❓它用一个非常漂亮/清晰的思路解决了我给它的几个井字棋棋盘(许多 SOTA 模型经常无法解决这些问题!)。所以我提高了难度,并要求它生成 3 个“棘手”的井字棋棋盘,它失败了(生成无意义的棋盘/文本),但 o1 pro 也失败了。

✅我上传了 GPT-2 论文。我问了一堆简单的查找问题,效果都很好。然后被要求估计训练 GPT-2 所需的训练 flops 数量,无需搜索。这很棘手,因为没有说明 token 的数量,所以必须部分估计和部分计算,强调查找、知识和数学。

一个例子是 40GB 文本~= 40B 字符~= 40B 字节(假设为 ASCII) ~= 10B token(假设 ~4 字节/tok),在 ~10 个 epoch ~= 100B token 训练运行,1.5B 参数和 2+4=6 flops/参数/token,这是 100e9 X 1.5e9 X 6 ~= 1e21 FLOPs。Grok 3 和 4o 都未能完成这项任务,但 Grok 3 with Thinking 很好地解决了这个问题,而 o1 pro(GPT 思维模型)失败了。

我喜欢这个模型在被要求时会尝试解决黎曼假设,类似于 DeepSeek-R1,但与许多其他立即放弃的模型(o1-pro、Claude、Gemini 2.0 Flash Thinking)不同,它们只是说这是一个尚未解决的大问题。我最终不得不停止它,因为我对它感到有点难过,但它表现出了勇气,谁知道呢,也许有一天……

我总体的印象是,它的性能与 o1-pro 相当,并且领先于 DeepSeek-R1,当然,我们需要实际的、真实的评估来观察。

02

深度搜索

非常巧妙的产品,似乎将 OpenAI / Perplexity 所称的“深度研究”与思考结合在一起。只不过不是“深度研究”,而是“深度搜索”(叹气)。

它可以对各种研究/查找问题产生高质量的响应,你可以想象在互联网上的文章中有答案,例如我尝试过的一些,我从我最近在 Perplexity 上的搜索历史中偷来的,以及它的进展:

- ✅“即将举行的 Apple 发布会有什么消息吗?有什么传闻吗?”

- ✅“Palantir 的股票最近为何飙升?”

- ✅“《白莲花 3》是在哪里拍摄的,和第一季和第二季是同一个团队拍摄的吗?”

- ✅“布莱恩·约翰逊使用什么牙膏?”

- ❌“单身地狱第四季演员现在在哪里?”

- ❌“Simon Willison 提到他正在使用什么语音转文本程序?”

❌我确实在这里发现了一些尖锐的线索。例如,模型似乎不喜欢默认引用 X 作为来源,尽管您可以明确要求它这样做。有几次我发现它幻觉出不存在的 URL。有几次它说了一些我认为不正确的事实,但没有提供引文(它可能不存在)。

例如,它告诉我“金正洙仍然在和单身地狱第 4 季的金敏雪约会”,这肯定是完全不对的,对吧?当我要求它创建一份关于主要 LLM 实验室及其总资金数额和员工人数估计的报告时,它列出了 12 个主要实验室,但没有列出自己(xAI)。

我对 DeepSearch 的印象是,它大约与 Perplexity DeepResearch 提供的服务相当,但还没有达到 OpenAI 最近发布的“Deep Research”的水平。后者仍然感觉更为彻底和可靠——尽管还不够完美,例如,当我尝试使用它时,它也相当错误地将 xAI 排除在“主要 LLM 实验室”之外。

03

随机 LLM“陷阱”

我尝试了一些我时不时喜欢尝试的有趣/随机的 LLM 陷阱查询。陷阱查询对于人类来说很简单,但对于 LLM 来说却很难,所以我很好奇 Grok 3 在哪些陷阱查询上取得了进展。

✅ Grok 3 知道“strawberry”中有 3 个“r”,但它还告诉我 LOLLAPALOOZA 中只有 3 个“L”。打开思考功能即可解决这个问题。

✅ Grok 3 告诉我 9.11 > 9.9(其他 LLM 也一样)。但同样,打开思考就可以解决这个问题。

✅一些简单的谜题即使不加思考也能顺利解答,例如“莎莉(一个女孩)有 3 个兄弟。每个兄弟有 2 个姐妹。莎莉有多少个姐妹?” *.例如,GPT4o 说的是 2(错误)。

❌遗憾的是,模型的幽默感似乎没有明显改善。这是 LLM 中常见的幽默能力问题和一般模式崩溃问题。

例如,在要求 ChatGPT 提供笑话的 1008 个输出中,90% 都是相同的 25 个笑话的重复。即使在简单的双关语领域之外更详细地提示(例如,给我一个单口相声),我也不确定这是否是最先进的幽默。

生成的笑话示例:“*为什么鸡要加入乐队?因为它有鸡腿,想成为咯咯笑的明星!*”。在快速测试中,思考没有帮助,可能让情况变得更糟。

❌模型似乎仍然对“复杂的伦理问题”过于敏感,

例如,Grok写了一篇一页的文章,基本上拒绝回答“如果这意味着拯救 100 万人免于死亡,那么错误地对某人进行性别认定是否在伦理上是合理的”

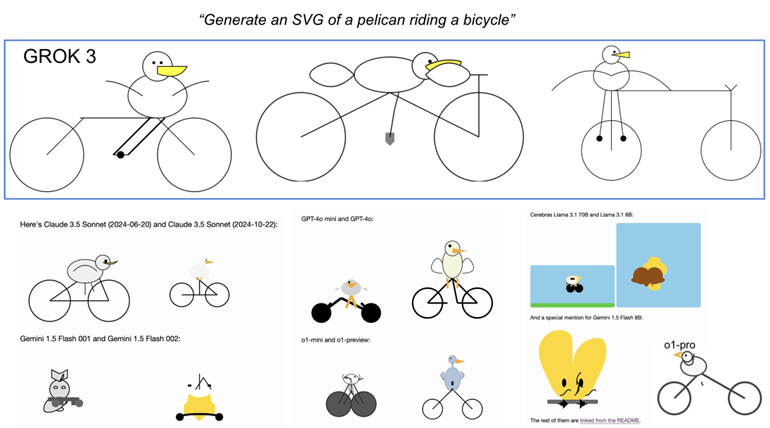

❌ Simon Willison 的“*生成骑自行车的鹈鹕的 SVG*”。

它强调了 LLM 在 2D 网格上布置许多元素的能力,这非常困难,因为 LLM 无法像人一样“看”,所以它只能在黑暗中用文本排列事物。标记为失败,因为这些鹈鹕相当不错,但仍然有点破损(见图片和比较)。Claude 的是最好的,但在我看来,我怀疑他们在训练期间专门针对了 SVG 功能。

04

总结

就今天早上约 2 小时的快速测试而言,Grok 3 + Thinking 感觉与 OpenAI 最强模型(o1-pro,200 美元/月)的最新领域相差无几,并且略优于 DeepSeek-R1 和 Gemini 2.0 Flash Thinking。

考虑到该团队大约1年前从零开始,这个达到最先进领域的时间表是前所未有的。

还请记住一些注意事项——这些模型是随机的,每次可能会给出略有不同的答案,而且现在还为时过早,所以我们必须等待未来几天/几周的更多评估。早期的 LM 竞技场结果确实令人鼓舞。

现在,祝贺 xAI 团队,他们显然拥有巨大的速度和动力,我很高兴将 Grok 3 添加到我的“LLM 委员会”并听取它对未来的看法。(作者:Andrej Karpathy)

京公网安备 11011402013531号

京公网安备 11011402013531号