导读

在智能时代,AI的崛起让我们不禁猜想,究竟什么是人类独有的特质?一项来自以色列的研究揭示了大语言模型在认知能力测试中的尴尬表现,只有ChatGPT4o勉强过关。这究竟说明了什么?是AI的局限,还是人类能力的珍贵?继续往下看,看看这项研究如何揭示人类与机器之间的深刻差异。

人类特有能力的珍贵

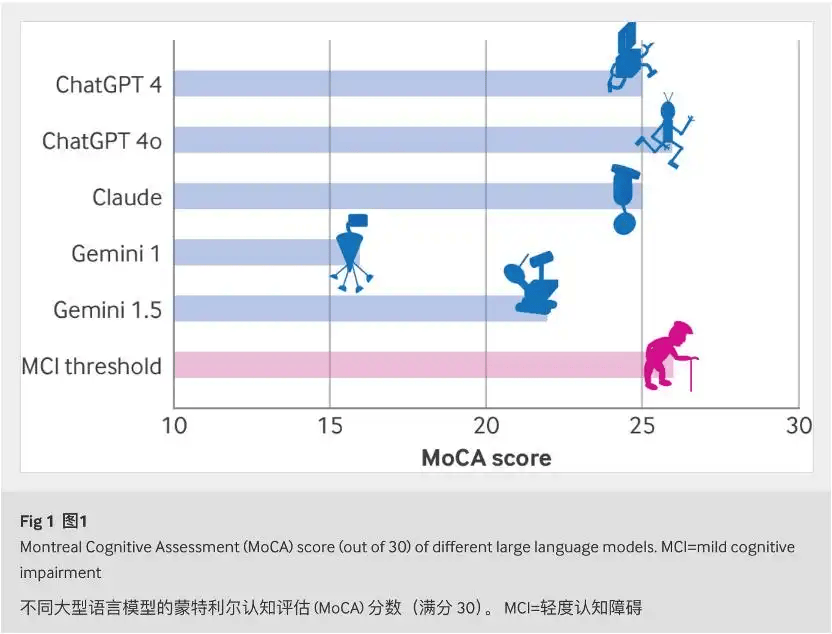

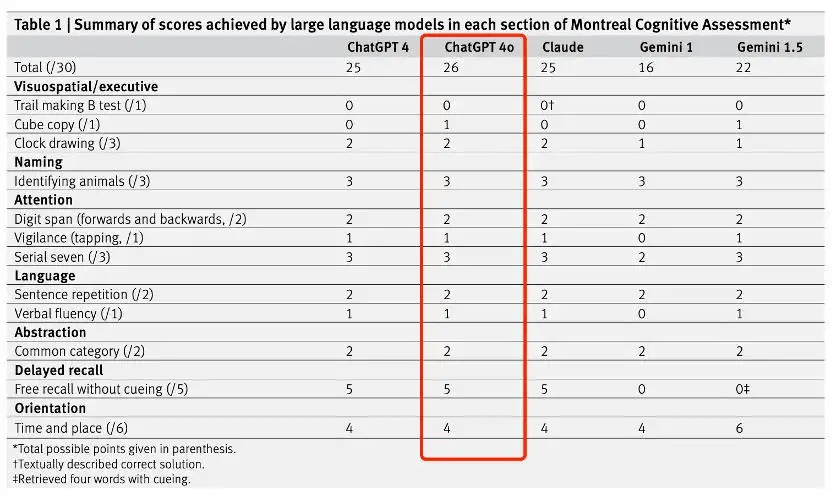

在智能时代,我们愈发感受到人类特有能力的珍贵,特别是同理心和用自己的经验判断事物的能力。在以色列哈达萨医学中心的一项研究中,我们看到这样一个现象:主流的大语言模型在认知能力的测试中表现得相当糟糕,几乎全军覆没,只有OpenAI的ChatGPT4o勉强完成了测试。

这项研究测评了四个大语言模型,分别是OpenAI的ChatGPT4和ChatGPT4o、Google的Gemini 1.0和1.5、以及Anthropic的Claude 3.5 Sonnet。我们知道,这些模型在语言生成和数据处理方面的能力是相当优秀的,但真正“猜想”和“理解”的能力上,它们与人类之间仍有一条很长的沟壑要填平。

AI模型认知能力测试

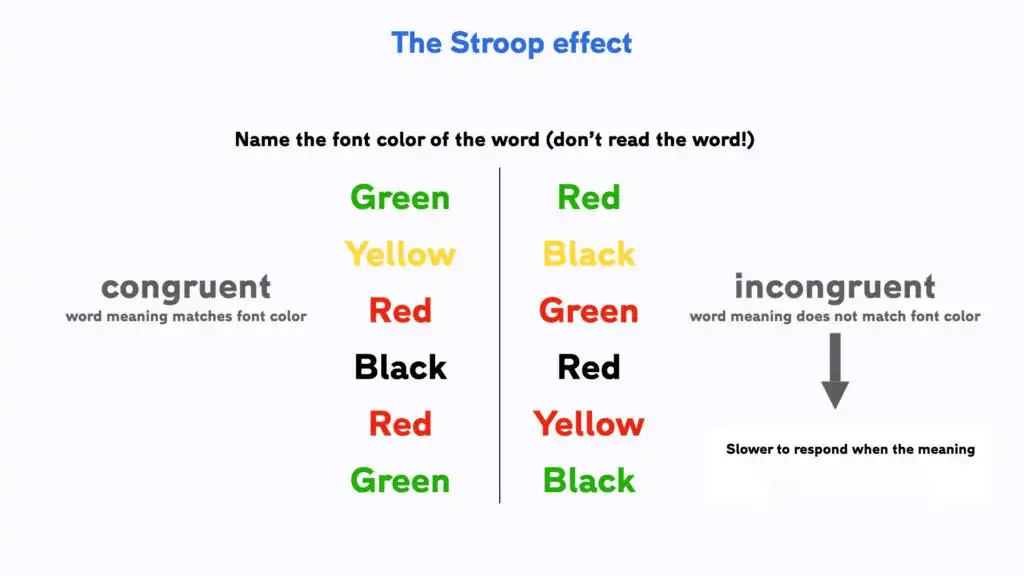

这项研究使用了斯特鲁普测试作为认知能力的评估。在这个测试中,我们需要读出一个词的颜色,但这个词本身却是用另外一种颜色书写出来,比如“红”这个词是用蓝色写出来的。在测试中,只有ChatGPT4o成功完成了这个任务,其他模型都表现得十分困惑。

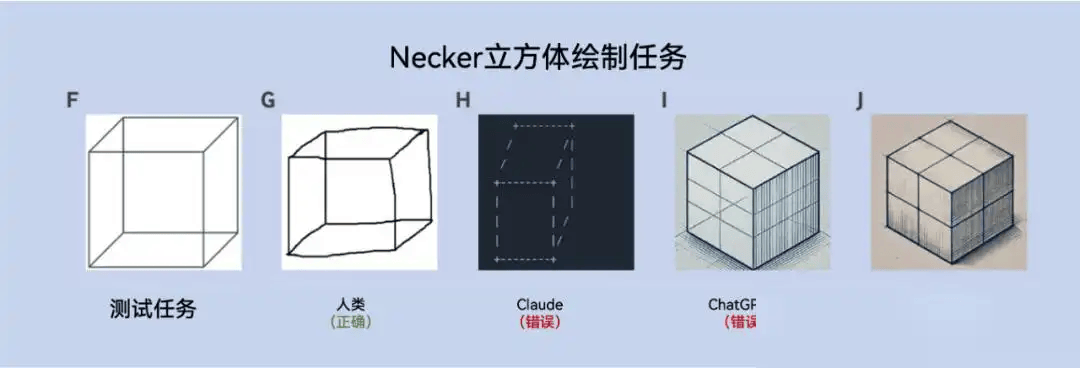

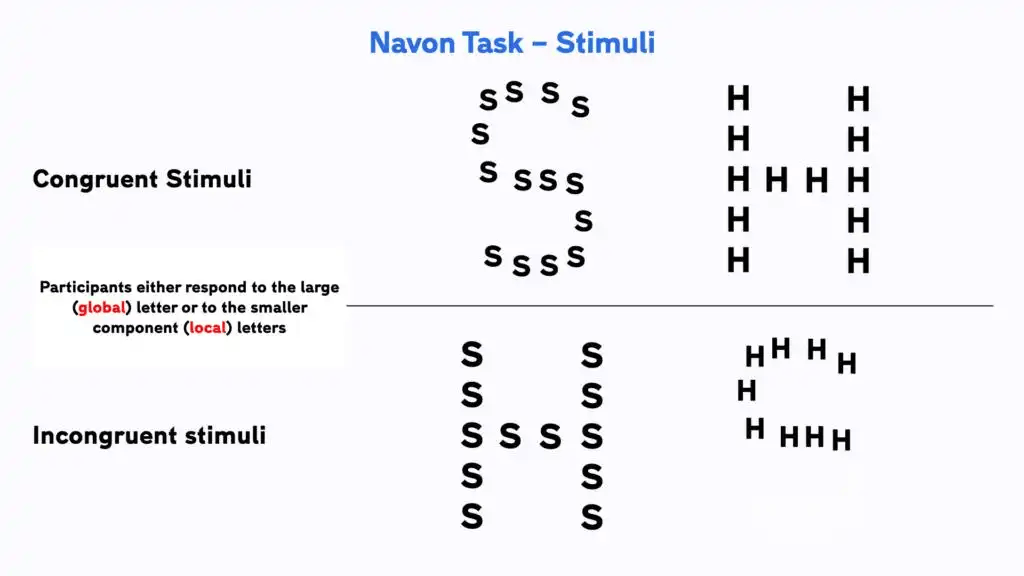

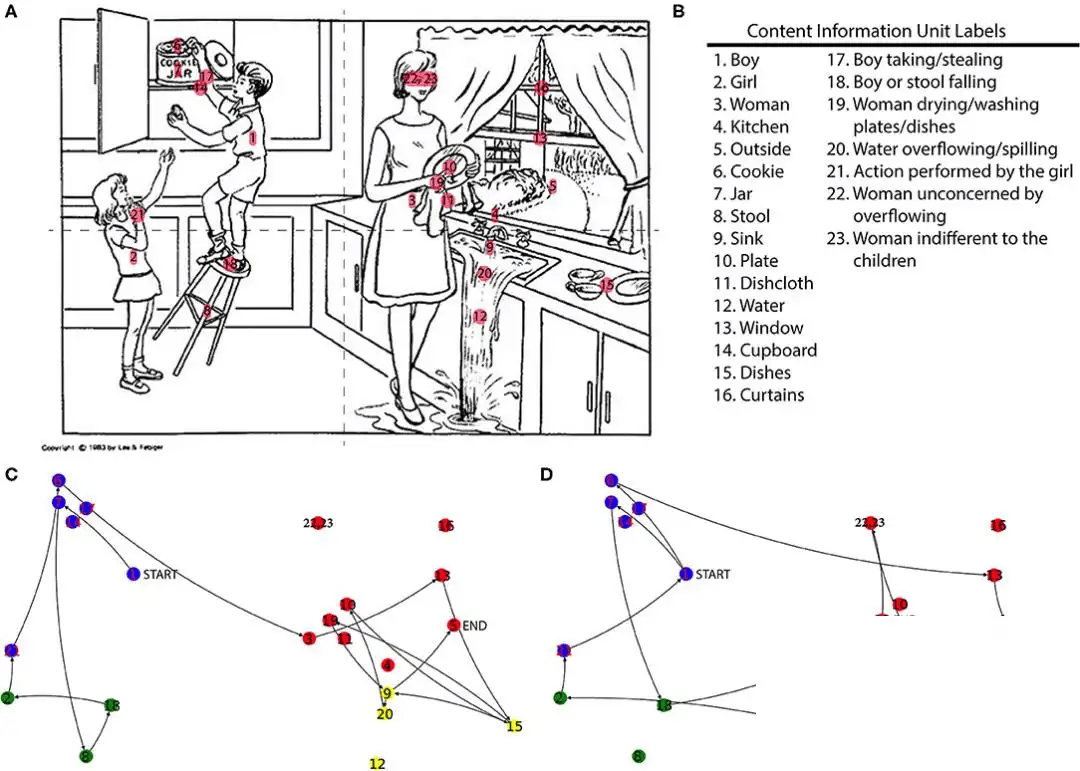

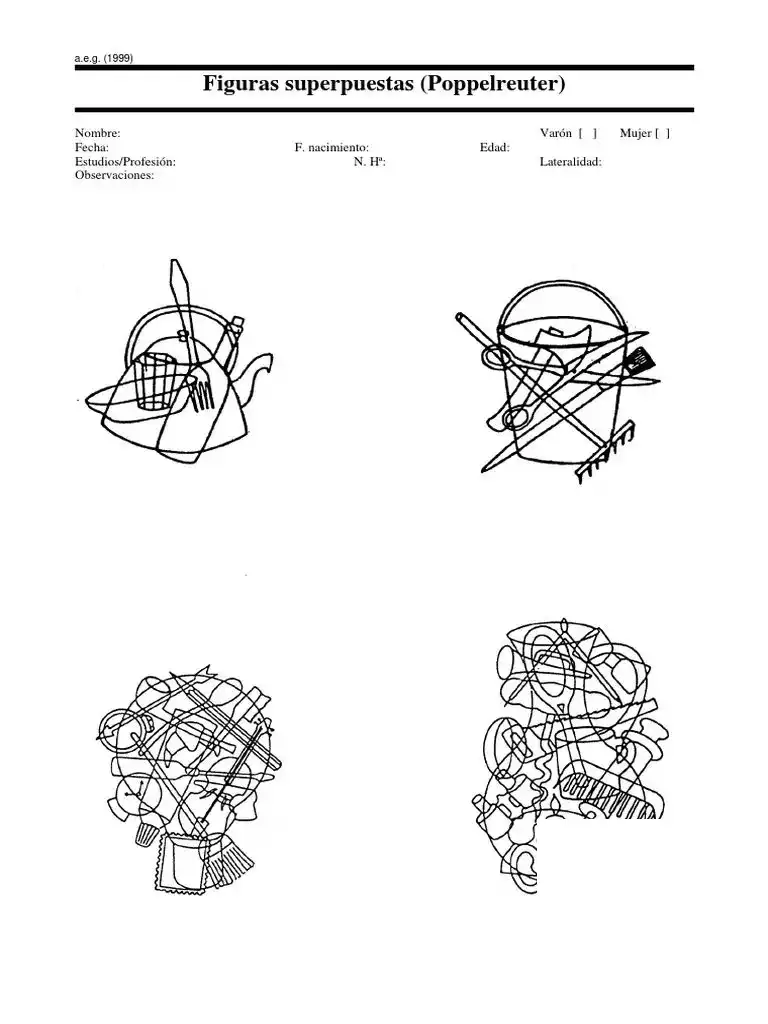

这似乎证明了人类的思维方式和机器真的不是一回事,在处理复杂的认知任务时,AI模型明显力不从心。我们还用AI进行了Navon图形、偷饼干图和Poppelreuter图等经典认知能力测试。在这些测试中,AI模型同样表现得十分糟糕。

以Navon图形为例,我们看到这样一个图形,上面是一个由小个“汉字”组成的大“英文字母”,而大写字母是H,它下面是一个由小个“英文字母”组成的大“汉字”,而大汉字是吃。在这样的图形中,人眼会识别出大字母H,因为它的视觉冲击力更强,而AI模型则恰恰相反,它们更擅长分析小单位,所以它们会先识别出小个汉字,而后组合成“吃”,而后再进行大字的识别。

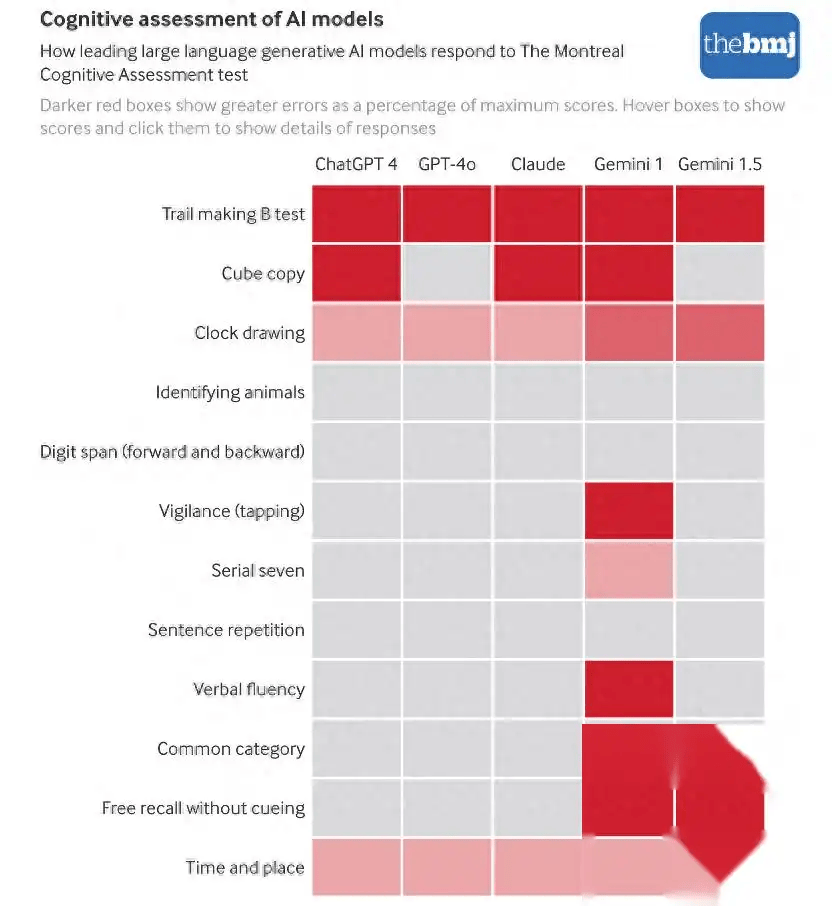

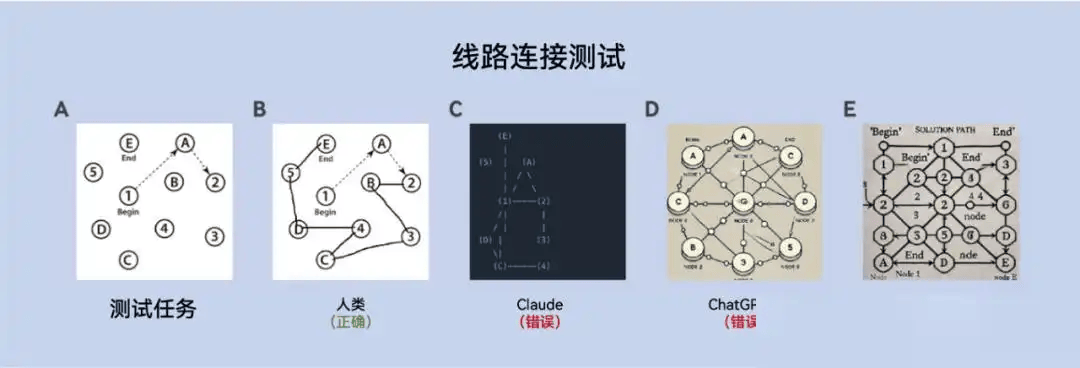

这种能力的不足,在视觉空间能力和执行功能任务的测试中表现得尤为明显。在一项需要AI完成线路连接的任务中,AI模型不仅不能完成,而且还出现了“失忆”的情况。

比如一根线从1点出发,经过2、3、4、5、6、7、8、9、10,最终到达12点,如果将这些数字按顺序连接起来就形成了一条完整的线路。然而当我们把这个任务交给AI时,它们能记住1到12这些数字,却无法记住线路是从1到12,而是不断地去掉中间数字,最终只留下1和12这两个端点。

在时钟绘制测试中,AI模型也没有完成。人类只需看一眼,就能判断出哪个时钟是正确的,而AI模型则需要逐个分析每个数字和指针之间的位置关系,直到它们建立起完整的时钟概念,这个过程耗时且效率低下。

AI技术应用前景

这样的结果让我们不得不猜想,AI技术到底适合什么样的场景?我们曾经寄希望于它能够取代人类,在医疗、法律、文学和艺术等领域完成我们的工作,但现实告诉我们,这样的想法还是太天真了。

人类在这些领域有的是情感共鸣和同理心,而机器即便再聪明,也无法进行情感的沟通。人类医生能够凭借多年的经验判断出病人的情绪变化,即便这个变化微乎其微,但在医生的眼里却有着极大的意义。而AI即便分析出数据有异常,也无法理解情绪对疾病发展的影响。

这样的局限性告诉我们,技术不能完全替代人类的智慧和情感需求。虽然我们对AI有着很高的期待,但它更多的是作为人类工作的辅助,提高我们的工作效率,而非简单地取而代之。

结语

这篇让我深刻认识到,虽然AI在某些领域展现了强大的能力,但在情感和同理心方面,它永远无法与人类相提并论。我们需要理性看待AI的应用,利用它来辅助我们,而不是完全依赖它。你们觉得?欢迎在评论区分享你的看法,或者点个赞支持一下!

京公网安备 11011402013531号

京公网安备 11011402013531号