日前,支付宝上线了全新AI视觉搜索产品“探一下”。用户遇到感兴趣的事物,就能够让AI通过摄像头,“探一探”花草动物潮玩、做旅游的随身讲解、查询商品药品详情等。

距离蚂蚁集团正式提出AI战略仅一年时间,AI对传统应用的覆盖已如此全面而深入。就拿支付宝App来说,2024年以来,支付宝接连发布“支小宝”等AI独立应用以及智能体开发平台,支付宝App当中也集成了各种智能助理。支付宝此次的“探一下”则是聚焦视觉多模态赛道的一次尝试,其体验到底如何呢?

不是机械的画面解读,而是用户的“随身解说”

进入“探一下”主界面后的第一件事就是定格摄像头获得的画面并开始生成分析结果,这一套操作差点让小雷没有反应过来。但换个角度想想,“探一下”本身是集成在支付宝扫一扫当中的扩展能力,并不是独立的App,通过搜索进入可能不是最好的交互方式。

功能划分上,“探一下”主要有“探知识”“探灵感”“探文字”“AR”四个选项,最后两个其实是常规的文字识别和AR显示,小雷认为前两个功能才是“探一下”的核心能力所在。

(图片来自摄制)

“探一下”和其它主流视觉识别型AI的工作原理相差无多,都是通过识别并分析摄像头传来的画面,不同之处在于,“探一下”会在捕捉画面主体后主动生成识别结果,还可以根据图片特征关联商品信息,像是结合了拍图搜物的能力。后者则是需要用户向发起提问,比如希望获得画面当中的什么信息,AI才会分析,但可能由于没有对应的接口,一般不会生成具体的产品型号等信息。

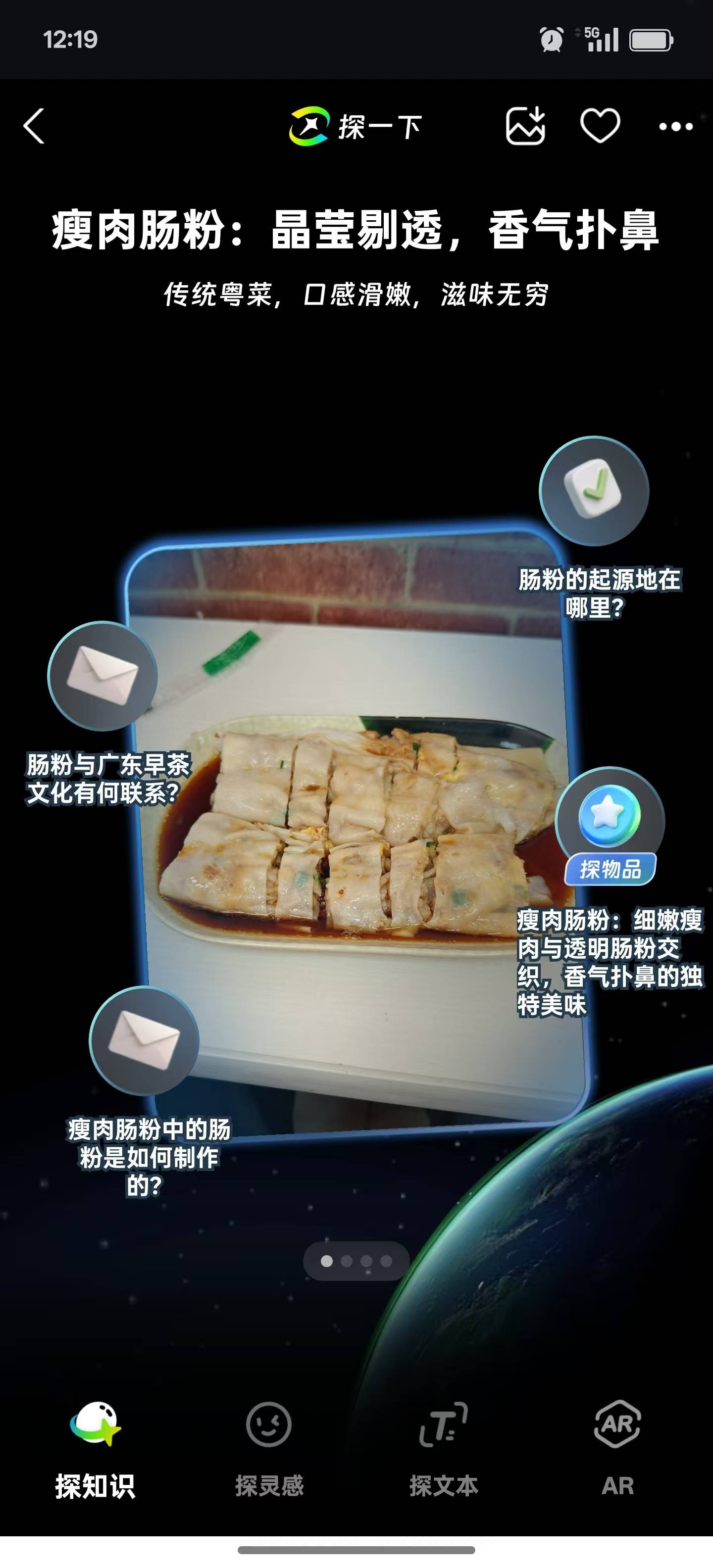

和常规的视觉识别大模型APP不一样,“探一下”在生成识别结果之后会进一步发散,识别的范围很大,绿植、饮料、食物等都可以识别。比如小雷识别了眼前的肠粉之后,“探一下”会基于识别结果提供额外的生成选项,例如“肠粉的起源地”“肠粉与广东早茶文化有何联系”之类的。个人感受来说,如果当下小雷遇到从未见过但又很好奇的事物,“探一下”的探知识能力的确会是一种相对有效的引导。

(图片来自)

网传“探一下”能够准确识别各个版本的奥特曼,小雷用一个动漫手办尝试了一下,结果并没有网传的厉害,大概是数据库没有对应的角色。

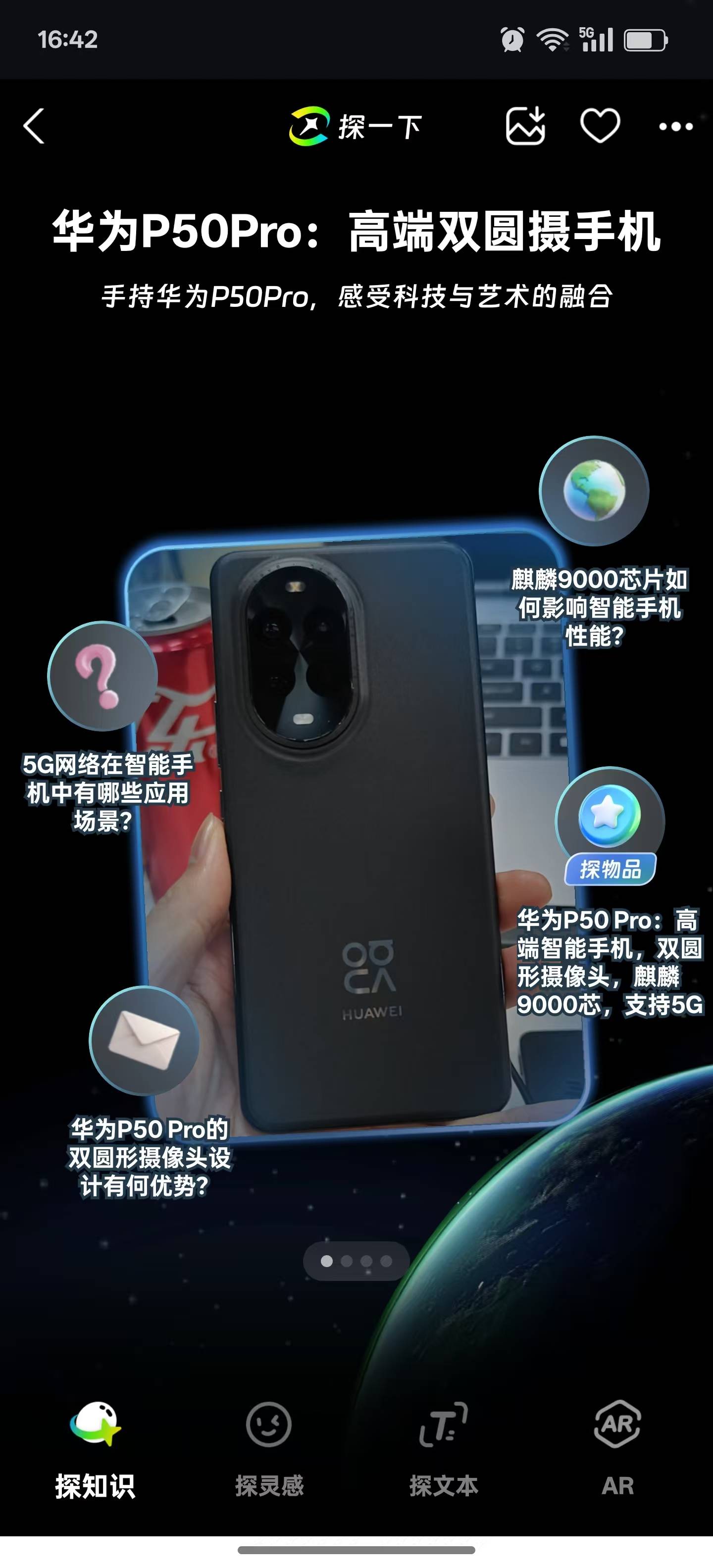

换作是菊花茶这种有明显商品特征的识别结果,“探一下”会在探知识的选项当中接入商品链接,这就是小雷前面提到的拍图搜商品的能力,这在日常中可能会用得比较多。只不过目前“探一下”识别结果的准确性还有提升空间,就比如它会将小雷手上的华为nova 13 Pro识别成华为P50 Pro,猜测识别的准确性与数据库、摄像头画面有一定的关联。

(图片来自)

小雷还发现“探一下”在识别上的一些细节,当系统直接框选或抠出重点物体时,识别结果和发散内容可能会多一些(增加探商品、探实物等词条),如果保留原始画面,一定程度上说明识别结果不一定准确。

而“探灵感”则类似于看图配文,提供“幽默”和“治愈”两种文本生成风格,前者会以漫画对话气泡展现,有点像是物品的“内心OS”之类的,看起来还算有趣,“治愈”就是正能量文本输出,这些文本内容都是基于AI对画面内容识别之后延伸出来的答案,把视觉识别与AI帮写结合在了一起。

简短体验下来,小雷认为支付宝“探一下”更像是一种带有玩乐和创意属性的生成式AI轻应用,它不会针对画面内容输出具体的识别结果,而是简化识别结果,并以科普、搜同款、AI创意文案这几点为核心,可以把它看作是“随身讲解”。

(图片来自)

但本质上小雷认为“探一下”的出现还是支付宝对本土服务的整合,比如以图搜商品之类的,再通过AI视觉识别和知识科普、文字灵感推荐这样的亲民玩法,带动更多人使用AI功能,亦或是引导用户养成一种全新的搜索习惯。

对战理想同学、智谱:视觉识别能力强大

前面聊了关于支付宝“探一下”的体验和玩法分析,为了弄清楚和常规的视觉模型App区别在哪里,小雷找来了理想同学、智谱两款支持视觉识别的App进行简单对比。

小雷前面有提到,支付宝“探一下”不需要用户主动发文,也不会输出摄像头画面的具体分析结果,而是跳过这一步骤,直接提供知识科普、AI个性化文案这样的发散选项。作为对比,常规的视觉大模型App先是收集画面内容,再等待用户提问,往往能够得到十分具体的画面解读。另外,“探一下”不支持文字输入,它就是单纯的视觉识别。

都是画面识别,“探一下”走的是一条不同于常规视觉大模型的道路,后者强调看到了什么内容,前者强调的是物体背后的内容(购物链接、历史背景等)。面对同样的现代风格建筑画面,理想同学和智谱的解答方向是一致的,智谱的解答更详细,具体到画面周边的元素,以及建筑表面可能会被植被覆盖这样的细节,甚至还会进一步猜测这张图片所处的环境。

(图片来自,图一为“探一下”,图二为理想同学,图三为智谱)

而“探一下”直接跳过了画面分析这个步骤,直接摆出“石材的使用如何提升建筑物的视觉质感”“玻璃幕墙在节能方面有哪些技术优势”等,来引导我们进一步了解。事实上,对于正在游览景点的人而言,这种发散式的知识科普可能比游园内的讲解器还有用。

识别花花草草,支付宝的“探一下”还是有点实力,和理想同学、智谱的对比当中,“探一下”和理想同学都能准确识别眼前的花卉的品种(千日红),而智谱输出成鸡冠花。实际上千日红和鸡冠花两个品种的颜色比较接近,只在造型上有明显区分,更考验AI对画面内容识别的准确性。

(图片来自,图一为“探一下”,图二为理想同学,图三为智谱)

至于文字生成、图片生成一类的,我们就没有必要折腾支付宝的“探一下”了,它和理想同学、Kimi、豆包之类的大模型App并不在一条赛道上,并不具备查询资料、写作、画图之类的生产能力,本质上还是一个更趣味的以图搜索的轻量AI工具。

单论视觉识别的话,虽说视觉模型对具体产品的识别能力普遍比较弱,但支付宝“探一下”的识别水平至少不弱于主流,得益于背后有本土服务等数据资源,它的周边搜索能力可能还比常规的视觉模型更强,比如识别到具体的饮料或药物,适合什么时候、什么人群服用,“探一下”更集中于这些日常生活的服务。

AI视觉爆发,“探一下”掀起视觉搜索大战?

2023年,蚂蚁战略集团对外宣布了AI提速战略,确定了“AI First”,正式将AI作为公司发展的核心战略之一。如今,除了最近上线的“探一下”视觉AI产品外,支付宝今年也完成了AI智能助理的布局,出行、健康、政务等30多项场景服务当中,都接入了AI大模型能力。

支付宝推出“探一下”AI视觉产品,本身不是为了和智谱、Kimi等主流大模型展开竞争,严格来说,支付宝和他们完全不在一条赛道上。在小雷看来,无论是智能助理还是“探一下”,又或者是“支小宝”等AI独立应用,帮助我们解决问题,

厂商狂卷AI大模型规模的“玩概念”时代已经过去,如何让AI落到实处,引导用户使用AI能力,才是当下行业普遍关注的重点。

官方表示,人类获取的信息有超过80%来自视觉,以视觉为中心的人工智能产品,可以极大地降低人与AI交互的门槛。事实上,AI大模型供应商也在加紧视觉模型的铺开和开发,Google Lens、理想同学、智谱等视觉模型,利用广泛知识库识别、理解视觉内容,已经成为一种新浪潮。

(图片来自摄制)

再加上“探一下”这种本身带有一定趣味性的视觉AI产品,主打普及知识和娱乐性,而不是常规AI大模型那种冰冷的文字输出,一定程度上更容易让普罗大众接受,甚至是将其作为常用的内容搜索方式。

另外考虑到当前的功能丰富度,小雷并不认为“探一下”具备独立出来的条件。

就目前来看,视觉作为“探一下”唯一的识别手段和生成依据,准确度上还有待加强,毕竟它的任务就是做大家的“AI眼睛”,更需要完善背后的知识库,错误的识别结果有时候也会误导用户,这是“探一下”当前需要完善的地方。

25年1月7日,CES(国际消费电子展) 2025 即将盛大开幕,报道团蓄势待发,即将飞赴美国·拉斯维加斯现场全程报道,敬请关注。

京公网安备 11011402013531号

京公网安备 11011402013531号