一颗改变世界的芯片

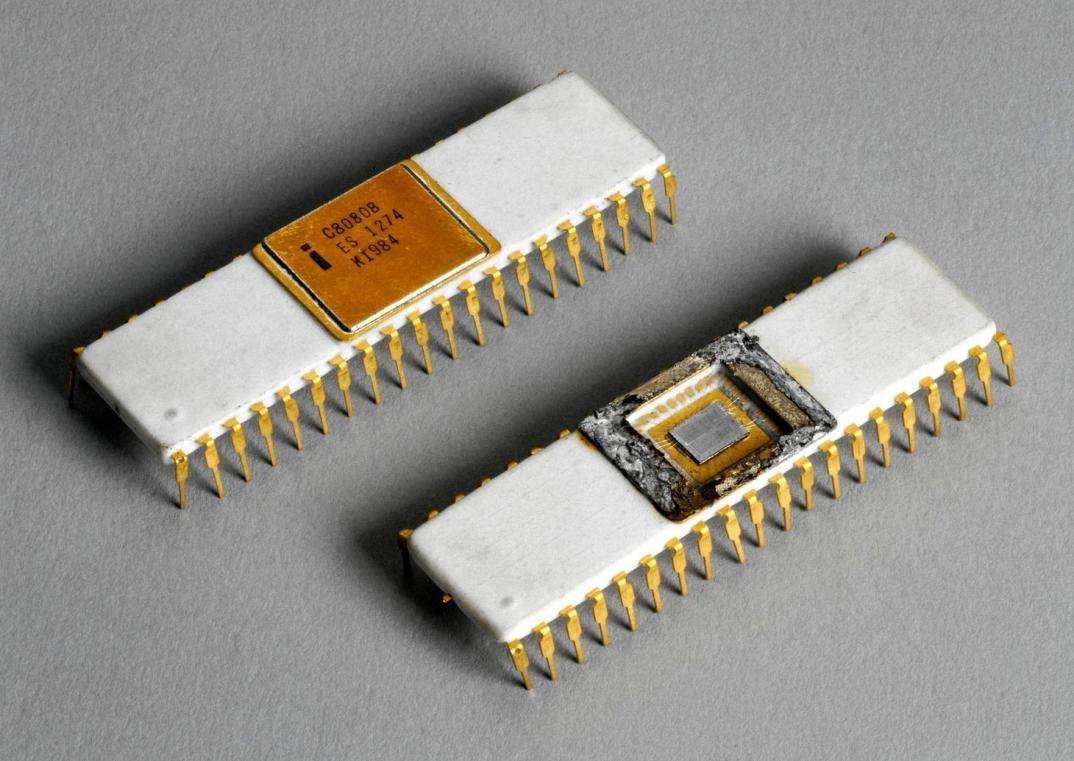

1974年4月,Intel发布了一颗改变世界的芯片:8080。今天,当我们打开家中的个人电脑时,很少有人会想到,正是这颗50岁的芯片,开启了个人计算机的新纪元。

当时的Intel还主要是一家内存芯片公司。处理器业务始于1971年为日本计算器公司开发的4004芯片——这是世界上第一个商用微处理器,但仅被视为公司的边缘业务。

8080的开发团队只有不到10个人,由"微处理器之父"Federico Faggin领导。在开发过程中,他面临着巨大压力。不仅要实现技术突破,还要应对公司管理层的质疑——在当时的半导体行业,很少有人能预见微处理器的广阔前景。然而,正是这个"副业",最终成就了Intel的辉煌。

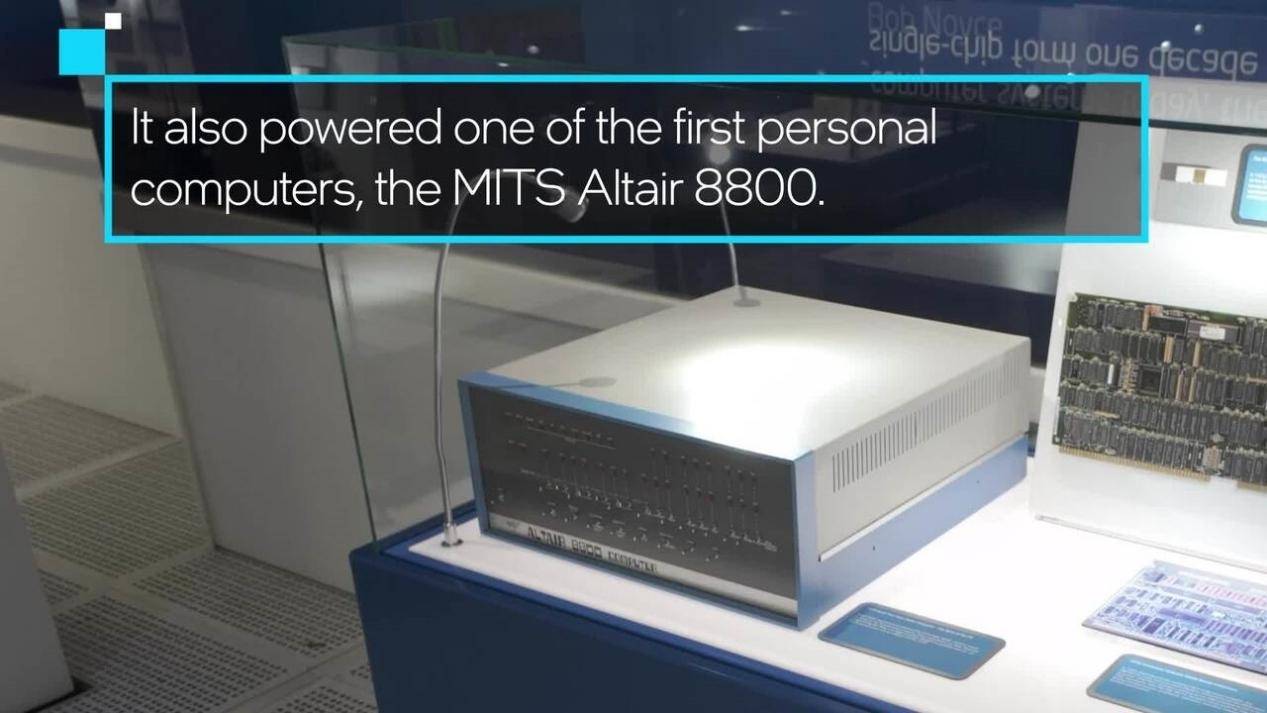

个人计算机革命:MITS Altair 8800

1975年,美国一家名为MITS的小公司推出了Altair 8800计算机。这台售价397美元的组装电脑,搭载了Intel 8080处理器,首次让普通人能够拥有自己的计算机。正是这台机器,吸引了年轻的比尔·盖茨和保罗·艾伦的注意,促使他们开发了第一个个人电脑版BASIC程序,并最终创立了微软公司。

一颗芯片,带来了两个改变世界的公司:Intel和Microsoft。这种蝴蝶效应在科技史上并不罕见。往一个小小的创新或者发明,都有可能引发一系列意想不到的巨大变革,进而推动整个世界不断向前迈进。

IBM PC:改写历史的选择

1981年,IBM做出了一个改变历史的决定:选择Intel 8088作为其个人电脑的处理器。这个决定不仅确立了PC的技术标准,更重要的是构建了一个全新的产业生态。Intel的处理器、Microsoft的操作系统,加上IBM的品牌影响力,这三位组合创造了一个全新的"Wintel"帝国。

游戏与多媒体变革:从游戏机到 3D 图形

1990 年代,随着个人电脑的逐步普及,人们对于图形处理能力的要求也在不断攀升。当时市面上的游戏、多媒体内容等,对画面呈现效果的需求越来越高,仅靠传统的图形处理方式已经难以满足大众的期望,大家渴望看到更加逼真、细腻的图形画面,对图形处理能力的需求与日俱增。就在这样的背景下,一家名为 NVIDIA 的公司精准地抓住了这个机会,开启了图形处理领域的新纪元。

1999 年 8 月,NVIDIA 推出了极具革命性的 GeForce 256 显卡,这款显卡首次将 “GPU”(图形处理器)这个概念带入大众视野。在它出现之前,显卡主要分为 2D 和 3D 两种类型,各自有着不同的功能和局限。而 GeForce 256 显卡集成了硬件 3D 加速单元,奠定了现代显卡的基础。它在技术上实现了诸多突破,首次带来了 256 位 3D 单元、首个几何变换引擎、首个动态光照引擎,还首次集成了 4 像素渲染管线,并能够支持 DX7.0 及 OpenGL。

从规格上来看,GeForce 256 集成了 2300 万个晶体管,这个数量是当时 P3 处理器的 2 倍以上,其浮点性能达到 50Gflops,具备每秒 1500 万个三角形、4.8 亿像素的渲染能力,这在当时是前所未有的水平。当时首发 GeForce 256 显卡的厂商有 Creative Labs、ELSA、Guillemot、ASUSTeK、Canopus 及 Leadtek 等,其售价为 28800 日元(按照当时 1999 年的汇率,约合 1898 元人民币),不过在那个年代,这样的价格对于大多数人来说,还是比较昂贵的,也只有少数铁杆 PC 游戏玩家和技术爱好者才会去购买体验。

回顾电子游戏的发展历程,早期的游戏大多是简单的 2D 画面,比如像《超级马里奥》《冒险岛》等经典游戏,它们虽然有着独特的趣味性,但画面表现相对简单,以像素风格为主。

随着计算机技术的发展,游戏开始向 3D 化迈进,像《VR 战士》等游戏的出现,开启了 3D 游戏的探索阶段,但当时的图形处理能力还相对有限,画面的精细度、真实感等都有待提升。而 GeForce 256 显卡的诞生,正好迎合了游戏从 2D 向 3D 转型的关键时期,它为游戏开发者们提供了更强大的图形处理工具,让他们能够打造出更加逼真、复杂的游戏场景和角色。

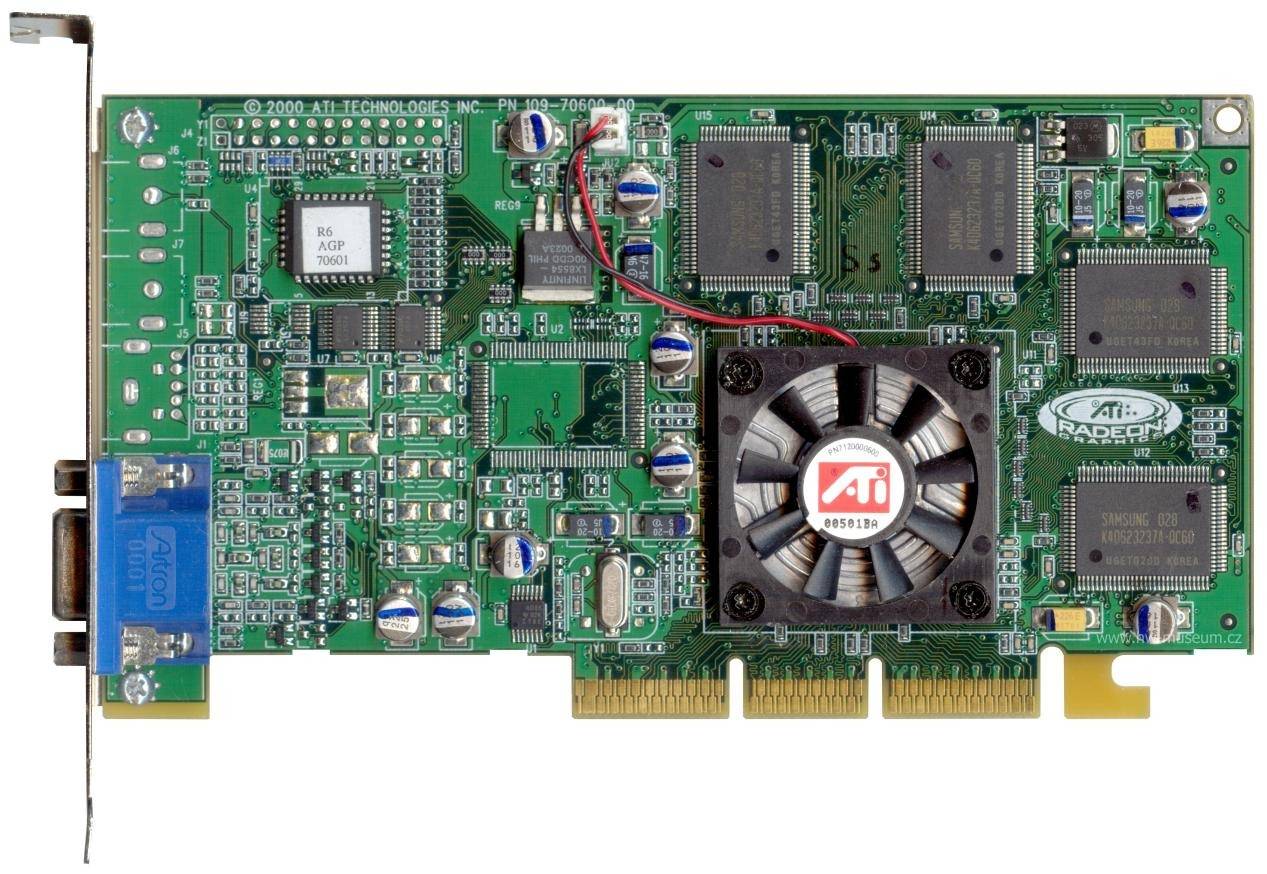

例如,对于支持 T&L 引擎的第一人称射击游戏《雷神之锤(Quake)》来说,GeForce 256 的效能可以完全发挥出来,它能够分担处理器的运算负载,使得游戏的画面更加流畅,光影效果更加逼真,大大提升了玩家的游戏体验,这是当时其他 3D 图形处理厂商如 3d fx、S3 Graphics 等所望尘莫及的,只有在一年后出现的 ATI Radeon 256 显卡才能与之抗衡。

从最初的 2D 图形加速,到后来推动 3D 游戏革命,GPU 的发展所带来的影响远不止局限于游戏产业。在后续的发展过程中,人们逐渐发现 GPU 内含成千上万个计算核心,能够同时处理大量数据流,这使其在深度学习、大数据分析等高计算密集型任务中大放异彩,显著加速了模型训练过程,降低了 AI 研究的门槛,也为后来的 AI 时代埋下了伏笔。

ARM的崛起:功耗之战

在过去几十年的芯片发展历程中,ARM 的崛起堪称一段传奇,它彻底改变了移动设备乃至整个科技领域的格局。

故事要追溯到 1990 年,当时英特尔在个人电脑领域已然占据着统治地位,而 ARM 这家公司却悄然开启了一条与众不同的道路,开发出了具有划时代意义的处理器架构。英特尔的策略侧重于追求极致的性能,以满足个人电脑在复杂计算任务等方面的需求,而 ARM 则独具慧眼地选择了低功耗路线。

要知道,在那个时期,电脑大多还是体积较大、需要稳定电源供应的设备,移动设备也尚未像如今这般普及和强大。但 ARM 仿佛预见了未来移动互联时代的需求,低功耗的处理器架构意味着设备能够在有限的电池电量下长时间运行,这为移动设备的发展埋下了关键的伏笔。

时间来到 2007 年,这一年堪称移动计算领域的分水岭,第一代 iPhone 横空出世,并且果断选择了 ARM 架构的处理器。这一选择犹如一颗火种,瞬间点燃了移动计算的新纪元。iPhone 凭借 ARM 架构处理器带来的低功耗优势,能够让用户在外出等场景下长时间使用,摆脱了频繁充电的困扰,同时也为各种丰富的移动应用提供了稳定的运行基础。

此后,众多手机厂商纷纷效仿,ARM 架构处理器在智能手机领域的应用越来越广泛。发展至今,全球超过 95% 的智能手机都在使用基于 ARM 架构的处理器,从高端旗舰机型到中低端普及型手机,ARM 架构无处不在。

不仅如此,ARM 架构的影响力还延伸到了平板电脑、智能手表、智能音箱等众多移动设备和物联网设备中。比如在平板电脑领域,iPad 等产品依靠 ARM 架构处理器实现了轻薄便携与长续航的完美结合,让用户可以随时随地用它来办公、娱乐;智能手表凭借低功耗的 ARM 芯片,能够在小巧的机身内维持数天甚至数周的续航,时刻监测用户的健康数据;智能音箱基于 ARM 架构也能稳定运行语音交互等功能,成为智能家居的控制中枢。

可以说,ARM 通过功耗之战,在移动革命中牢牢站稳了脚跟,并且持续推动着整个行业不断向前发展,让移动设备真正融入了人们生活的方方面面,成为了不可或缺的一部分。

AI 时代到来:从深蓝到 AlphaGo

1997 年,IBM 的超级计算机 “深蓝” 击败国际象棋世界冠军卡斯帕罗夫,这场人机对决轰动了全球,让人们第一次真切地感受到计算机在特定领域对人类智慧的挑战。当时的 “深蓝” 虽然展现出了强大的运算能力,但从本质上来说,它仍然依赖传统的运算方式,为了应对国际象棋复杂的棋局计算,使用了大量定制化的 ASIC 芯片来实现其功能。

然而,时间来到 2016 年,情况发生了巨大的变化。谷歌的 AlphaGo 与世界围棋冠军李世石展开了一场人机大战,最终 AlphaGo 以 4:1 的比分战胜了李世石,这场比赛标志着人工智能真正展现出了超越人类的能力,也让全世界对人工智能刮目相看。要知道,围棋相较于国际象棋,其复杂程度呈指数级上升,每个回合可能有 250 种走法,一场比赛可达 150 个回合,棋盘上的可能局面数量更是高达 3 的 361 次方。传统的人工智能方法面对围棋这样复杂的棋类游戏很难取得好的效果,但 AlphaGo 基于深度学习技术,将高级 “搜索树” 与深度神经网络巧妙结合,成功突破了这一难题。

而这场比赛的背后,有一个关键因素不容忽视,那就是 NVIDIA GPU 强大的并行计算能力。NVIDIA 的图形处理器最初是为了提升游戏中的图形处理效果而设计的,没想到在人工智能发展的浪潮中,意外地成为了 AI 时代的重要推手。那些能够同时处理大量数据、进行高速并行运算的 GPU 芯片,为 AlphaGo 这样复杂的人工智能程序提供了强大的算力支持,使其能够快速分析棋局、做出决策,从而在与人类顶尖棋手的对决中脱颖而出。

NVIDIA:从游戏到 AI

如果说 Intel 开创了 PC 时代,那么 NVIDIA 则无疑是 AI 时代的领军者。回顾 NVIDIA 的发展历程,它诞生于 1993 年,在那个电动游戏风靡全球的年代,NVIDIA 将自己的主战场设定在了游戏与多媒体市场。经过数年的研发,终于在 1999 年成功发明了绘图处理器(GPU),也借此成为了游戏公司的重要供应商。不过,在当时以中央处理器(CPU)为主导的芯片设计领域,NVIDIA 还只能算是边缘角色,不像英特尔那样能搭上个人电脑快速发展的列车。

但 NVIDIA 并没有局限于此,早在推出初代 GPU 后,业内就有人意识到这种独特的运算模式有着更广阔的应用前景,只是当时还不太明确具体的发展方向。而 NVIDIA 做出了一项关键决策,那就是通过建立统一计算架构(CUDA 平台),将 GPU 的运算功能拓展到科学研究等领域。这一举措堪称神来之笔,它让开发者们能够更加简单便捷地运用 GPU 进行各种计算任务,NVIDIA 也借此逐步建构起了属于自己的独家生态系统。

发展到如今,NVIDIA 已经成功地将 GPU 从单纯的图形处理器转变为 AI 时代的核心计算平台。从自动驾驶领域,帮助汽车实现智能驾驶、环境感知等功能;到大语言模型的训练与推理,为自然语言处理技术的飞速发展提供算力支撑;从科学计算中的复杂模拟、数据分析,到元宇宙概念下虚拟世界的构建与渲染,到处都能看到 NVIDIA 芯片的身影。可以说,NVIDIA 在 AI 时代的影响力已经渗透到了众多行业和领域,成为推动科技进步的关键力量。

结语:芯片与未来

这50年的芯片发展史,不仅是技术进步的历史,更是一部商业传奇。从Intel到NVIDIA,从IBM到苹果,每一家公司都在用自己的方式改写着历史。

而今天,随着AI时代的到来,新的故事正在上演。就像50年前Intel的工程师们可能想象不到8080会带来的变革一样,今天的我们或许也难以预见未来50年芯片技术会带来怎样的改变。但可以确定的是,这个充满创新与竞争的产业,将继续推动人类文明向前发展。

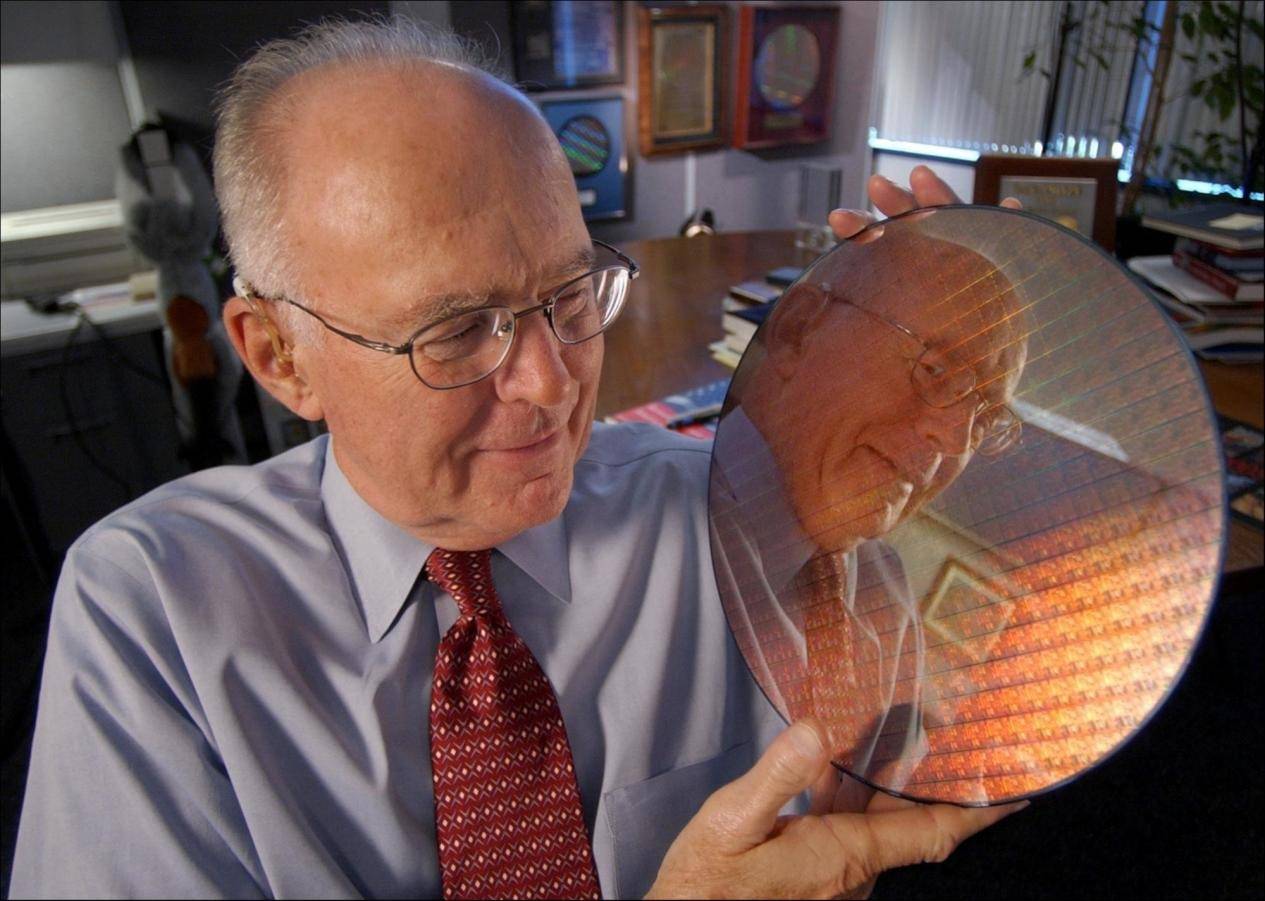

后记:摩尔定律的传奇

1965年,戈登·摩尔提出了著名的摩尔定律。有趣的是,这个"定律"最初只是他在一篇文章中的观察,预测周期还是每年翻一番。后来他在1975年将预测修改为每两年翻一番。这个简单的观察,却准确预言了半个世纪的芯片发展轨迹。

众多芯片企业都将摩尔定律当作重要的参考,围绕着它来制定自身的研发计划和发展战略。英特尔就是典型的例子,在很长一段时间里,英特尔依照摩尔定律,不断推进芯片制程的升级,比如其 CPU 制程从 65nm 到 22nm,每 2 年实现一次制程升级,晶体管数也相应翻番,密度持续增大。其他像 NAND 闪存、显卡、内存等产品的制程进步也基本遵循着这一规律。

然而,随着时间的推移,摩尔定律面临的挑战也越来越多。晶体管尺寸不断缩小,逐渐逼近物理极限,像短沟道效应、漏电流和隧道效应等问题日益凸显,使得芯片技术继续按照摩尔定律所设定的节奏进步变得愈发艰难。

尽管如此,业界也一直在积极探索,试图突破这些限制,让芯片发展能够延续摩尔定律的辉煌或者找到新的发展规律来替代它。例如,台积电展示了 3D 异质集成等新技术,通过垂直堆叠并互连具有不同功能的芯粒,期望在未来能够实现集成超过1万亿个晶体管的芯片解决方案,等效达到1nm工艺;英特尔也在不断努力,通过像PowerVia背面供电技术、采用新型2D通道材料等方式,致力于继续推进摩尔定律,争取在 2030 年前实现在单个封装内集成 1 万亿个晶体管。

京公网安备 11011402013531号

京公网安备 11011402013531号