大模型点燃的算力市场有多火热,厂商退潮的时候就有多仓促。

AIGC驱动了智能算力市场爆发,《中国算力发展报告(2024年)》显示,全球算力规模持续增长,2023年底已达到910EFLOPS(FP32),同比增长40%。其中,智能算力规模同比增长达136%,远超算力总规模增速。

在这种情况下,不仅包括云服务商等在内的原有算力供应商加码投入,一些传统企业也入局算力租赁领域。据统计,仅2023年下半年,鸿博股份、莲花控股、锦鸡股份、平治信息、湖北广电、软通动力等近40家上市公司“跨界”算力租赁。

但是,一年不到的光景,部分企业就主动终止跨界项目,从玩家涌入市场到市场降温,跨界算力租赁业务的热潮逐渐消退,主要原因在于对算力市场的资金投入、技术门槛等估计不足。

大模型算力市场三大变化

“国内智算行业发生了很大的变化,甚至可以认为是180度的变化。”鸿博股份CFO兼英博数科CEO浦威表示。从英博数科的视角看,通用大模型训练算力集群从千卡移向万卡,垂直大模型训练算力使用从定量移向弹性,商业化加速驱动算力市场从训练移向推理,是目前算力市场的主线逻辑。

首先,从通用大模型的训练来看,基础大模型预训练的需求会朝着“少而尖”的方向发展,例如国外OpenAI和xAI都在建设十万卡集群,国内字节跳动、阿里、百度等也在朝着数万甚至十万卡规模迈进,对于更多厂商的模型来说,万卡集群已经是当下能触碰到的天花板。

“之前都是千卡或者更小规模的智算中心,目前在国家的有序引导下,都往万卡规模去建新的智算中心,没有万卡的通用模型很难再进一步迭代,这是件‘卡脖子’的事情。”浦威说。

其次,相对于基础大模型,由少数科技巨头主导发展,算力需求更集中化和规模化,垂直大模型主要面向科研、教育、金融、零售、影视等细分行业,或聚焦于特定任务应用(如代码生成、音视频生成、对话客服等),其算力需求更具分散性、临时性和动态变化的特点,因此逐步从大规模定量模式向可伸缩、弹性的算力模式转变,兼顾成本和体验。

“我们和很多企业做了交流,他们正在逐步往行业走,基于基座模型做大量的行业精调、微调,其实他们的需求非常分散,仅在做模型微调等操作时才用算力,对成本也非常关注,这是我们看到的新机会。”浦威表示。

最后,随着大模型的商业化落地和多模态模型的普及,推理需求迅速增长。相关数据显示,从2022年到2027年,中国AI服务器的推理工作负载比例预计将从58.4%增长至 72.6%,逐步取代训练成为主导。

多模态模型的普及推动了文本生成、图像生成、视频生成等广泛的推理需求,AI模型应用也从通用模型延展至垂直行业,如代码生成、图像转3D、文生视频等多样化场景。

同时,推理算力需具备更快、更灵活的特点,以满足实时性和动态变化的需求,特别是在高频商业化任务中(如客服对话、营销文案生成等),这种需求进一步刺激了推理算力市场的持续扩张。

图片系AI生成

算力需求分层的应对措施

“从预训练本身来讲,大模型企业的格局相对比较稳定,因为基座大模型训练需要投入大量资金,未来不会有大量新玩家入局,更多企业开始谋求商业化的转型和商业化的落地。”英博数科副总裁宋琛谈到。

她还表示,“我们观察到,核心的算力需求并没有像外界猜测的遇冷,虽然大家也感受到一些大模型企业因为资金压力,对预训练规模做一些缩减,但是大模型技术本身并没有遇冷,还在做预训练的大模型企业,他们训练规模反而越来越大,而且对于集群的规模要求也在增加。”

大模型算力产业不会缩减,但会用变化淘汰反应不及的厂商,算力服务商需要与时俱进。

英博云专注于做两点:一是针对大模型预训练规模增长的头部客户,英博云本身有算力集群的建设和运维的经验,可为客户提供量身定制的集群选型、建设、运维,到整体解决方案;二是针对有弹性算力需求的应用领域的中小客户,英博云以VCluster的形式提供GPU 和CPU资源混合的弹性K8S集群服务。

宋琛提到,相对原来公有云厂商来讲,英博云更专注于GPU算力云领域,为客户提供灵活定制服务以及精准把控成本。“在整个GPU算力云市场中,我们填补了细分缝隙。”她说。

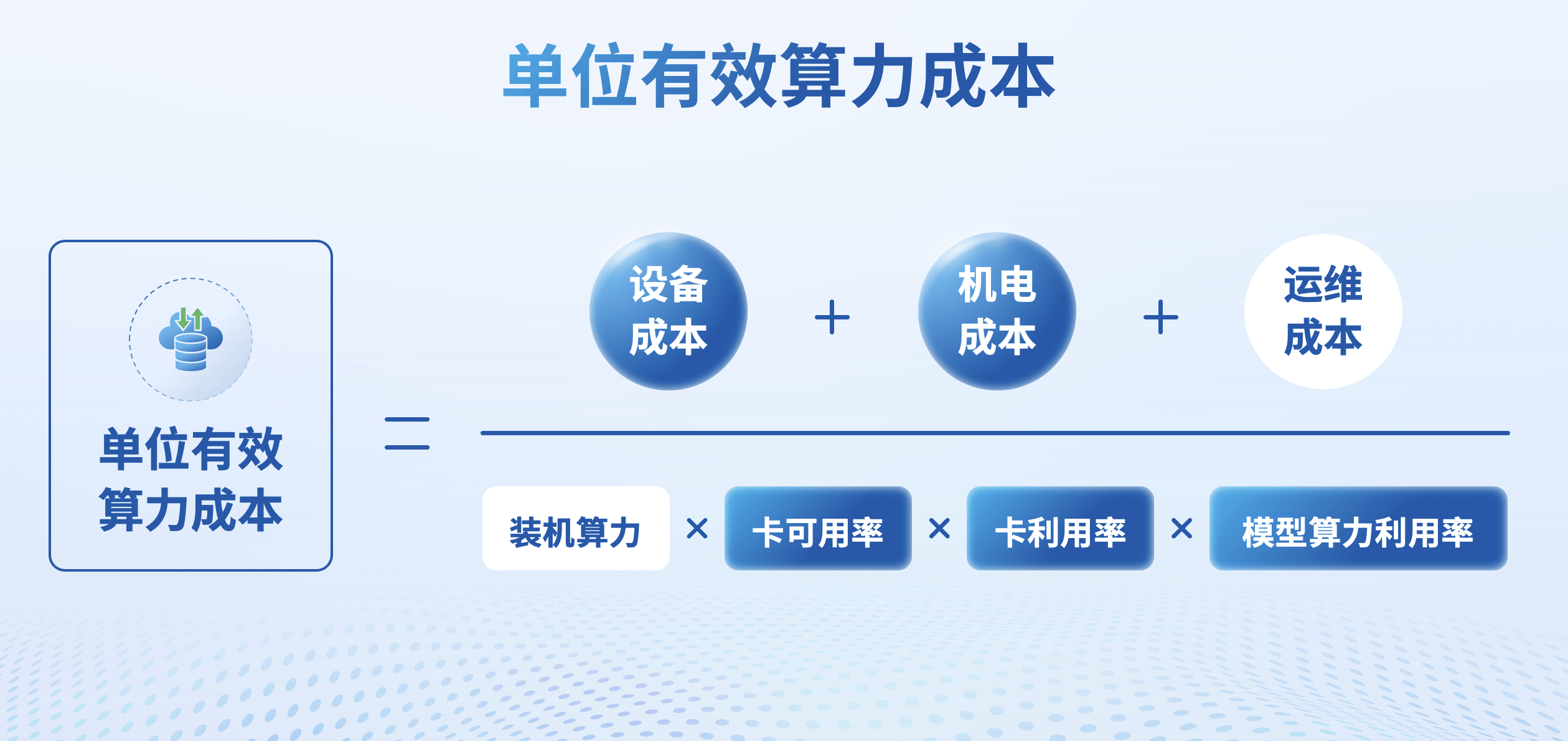

英博云还提出了一个“单位有效算力成本”的成本评估框架,通过算力投入成本(设备成本、机电成本、运维成本)与有效计算能力(装机算力、卡可用率、卡利用率及模型算力利用率)的比值,可作为评价算力服务质量的唯一标准。

英博数科副总裁秦伟俊表示,从最早期的IDC建设,到训练过程中会不会有折损、故障,到模型框架的选择,训练模型的时间长度和效率,英博云对整个链条通盘考虑,为大家提供算力提升的空间。

下一阶段,算力产业系统运营

对于智算中心的核心网络难题,英博数科CTO李少鹏表示,多个算力集群加在一起的一万张卡,做不了万卡级别的并行训练。只有在单一物理空间内,使用高功率机柜,通过统一的计算网和存储网,将所有GPU服务器组成单一集群,才能做万卡级别的并行训练。。

李少鹏指出,当前算力成本主要来自设备采购、机电支持和运维费用。算力资源的实际利用率普遍偏低,这与硬件匹配、调度策略以及训推框架配置等因素密切相关。

随着长尾客户逐渐成为算力服务的主要消费群体,弹性算力服务将成为他们的首选,推动智能算力行业向高效、低成本的新阶段迈进。

在提供高效益、多样化的智算产品与服务之外,英博数科还提供了算力实验室,对主流算力卡和设备进行测评,以便提供更适配于客户业务类型的服务。例如,某3D视频生成企业此前一直使用英伟达A卡,在英博数科结合客户模型的特点和参数,提出客户模型更适合用H卡进行训练,整体测试效率有两倍以上的效率提升,同时性价比也远远优于A卡做训练。

据悉,在投融资层面,智算中心建设是资本密集型行业,英博数科也在建设产业孵化器,对AI垂直应用公司给予相应的扶持,不仅仅是从资金,也包括算力、人才培养等,帮助繁荣和建立整个AI应用的生态。(作者 | 张帅,编辑 | 盖虹达)

京公网安备 11011402013531号

京公网安备 11011402013531号