文|光锥智能 白 鸽

OpenAI最新大模型o1的发布,标志着大模型正式迈入推理时代。但迈入推理时代后,大模型的不可能三角问题更加凸显——成本、效率和性能难以平衡。

一般来说,想要模型效果好,就需要模型大,但模型越大,意味着参数越多,参数越多其背后的算力成本就不断提升,甚至是几十上百倍的提升。同时,在模型大、成本低的情况下,还要求模型响应延迟足够低。

想要破解大模型不可能三角的问题,通过优化算力资源,在不牺牲模型性能的前提下尽可能降低模型部署成本,成为行业中的关键解法。

此背景下,聚焦智能算力优化的AI Infra赛道崛起。AI Infra,是指在大模型生态系统中,链接算力和应用的中间层基础设施,包括硬件、软件、工具链和优化方法等,是一个整体解决方案。

那么,AI Infra到底怎么实现算力资源的优化?又如何跑通其中的商业闭环逻辑?作为AI Infra赛道的创企,脱胎于清华大学高性能研究所的趋境科技给出了自己的思考和解法。

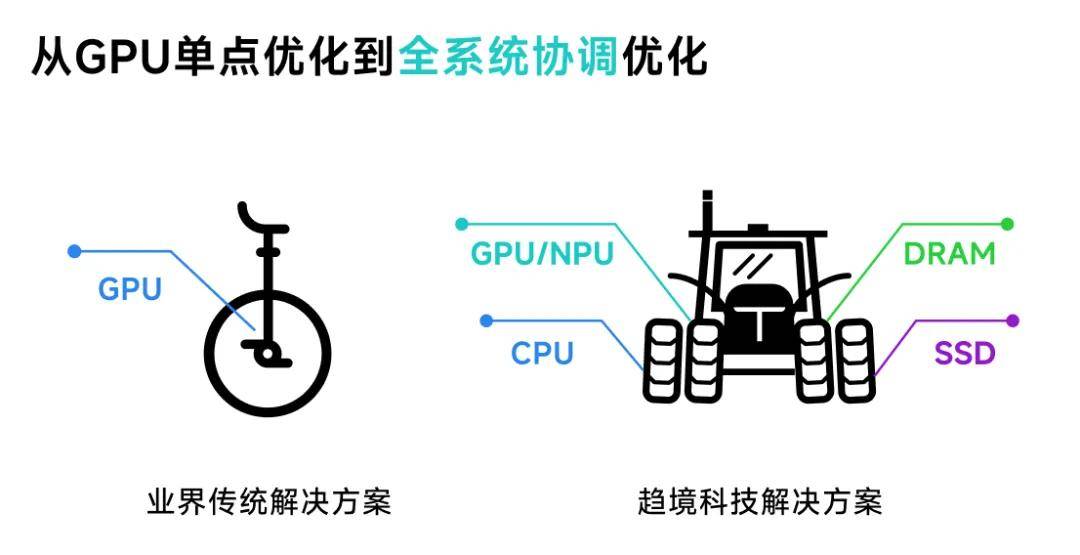

大模型发展过程中,最底层算力基础设施是以GPU为主,如果把其比做汽车发动机,可以看到,发动机如果性能好,汽车就可以跑的快,但想要汽车跑的更快,就不能仅靠发动机,还需要空气动力学、传动轴、轮胎等整车体系化能力的升级。

“现阶段很多AI Infra企业更多是聚焦对GPU进行效率优化,而我们则是进行了全系统架构设计。要真正的榨干所有硬件资源,从而突破GPU算力制约。”趋境科技CEO艾智远如此说道。

因此,趋境科技提出以存换算和全系统协同优化推理解决方案,通过协同存储、CPU、GPU、NPU等多种设备,相当于把机器内所有硬件资源全部用上,充分释放异构算力,将推理成本降低10倍以上。

趋境科技通过协同所有硬件资源,为大模型提供充足的算力的同时,也通过“以存换算”技术释放存力作为算力的补充,降低大模型对算力的需求。

早期大模型推理架构将每次推理视为独立请求,缺乏高效处理所需的“记忆”能力。尽管后续引入了近似问题缓存(Semantic Query Cache)和前缀缓存(Prefix KVCache Cache),但仍主要依赖于“死记硬背”。这些方案要求新问题与已处理问题高度一致,才能利用缓存去降低算力需求。

“以存换算”的技术便是针对这一问题所设计,通过调用存储空间和“融合推理(Fusion Attention)”技术,即便是面对全新的问题也可以从历史相关信息中提取可复用的部分内容,与现场信息进行在线融合计算。这一技术显著提升了可复用的历史计算结果,进而降低了计算量。

实际上,这就相当于给大模型增加了一个存储体,这个存储体存储的不是文档,而是模型推理过程中的中间结果,可以理解为大模型推理结果的记忆元。就像我们的大脑一样,储存了海量的运算好的信息,在我们想要表达或者推理的时候,能够从大脑中调用出一部分运算好的信息供我们使用。

“我们技术的本质,就是通过过往用户提问时,对大模型运算过程中的中间结果进行缓存,然后当用户提出全新问题时,即使与原来问题不一样,但也能从过往记忆中提取相关内容,再结合现场推理,输出最终结果。”艾智远如此说道。

通过这一新思路,趋境科技的大模型知识推理一体机充分利用了存储资源,采用“以存换算”的方式释放存力作为对于算力的补充,在RAG场景中,响应延迟降低20倍,性能提升达10倍。

在实际商用落地上,趋境科技主要提供产品是大模型知识推理一体机,以软硬一体交付方式为主,内置了开箱即用的知识推理平台和推理加速引擎,提供办公助手、智能检索、内容创作等应用,并支持横向拓展更多应用,能够在医疗、教育、金融、法律、企业培训等场景直接使用;另外也提供丰富的API接口,客户能够快速完成大模型的部署和使用,对接现有大模型业务和产品中进行二次开发。

事实上,当前在AI Infra在一赛道中,不管是创业企业,还是云厂商,抑或是硬件厂商,都虎视眈眈,不断加速自身的技术和产品布局。

而趋境科技作为一家2023年底刚刚成立的创业公司,艾智远认为自身能够持续生存并发展下去的关键,就在于持续保持核心技术的领先性上。

趋境科技会持续优化底层技术能力,“我们更希望的一种模式是,我们搭的是一个架子,房顶上的这些应用是由大家来开发,然后利用我们架子能够更好的降低成本。”艾智远如此说道。

以下为光锥智能与趋境科技CEO艾智远详细对话内容(经光锥智能编辑整理):

(1)布局大模型知识推理一体机,用以存换算解决不可能三角形

Q:趋境科技成立于2023年底,当时选择创业的契机是什么?目前公司的基本情况,包括团队建设,融资情况等?

A:趋境科技是由清华计算机系教授武老师与真知创投创始人兼董事长任旭阳共同发起,公司核心三人创始团队:我、陈超、陈祥麟,均出身武老师门下。

我是清华计算机系博士毕业,博士期间主要从事分布式系统优化、并行计算、分布式存储等相关领域研究领域。

首席战略官陈超,清华大学工程博士在读,拥有MIT&杜克大学双硕士,同时兼任真知创投董事总经理,负责真知创投技术驱动项目的孵化与投资。

研发负责人陈祥麟,清华大学硕士,拥有多年大数据与AI相关产品研发和落地经验。

趋境科技的长期技术合作方,是清华大学的KVCache.AI团队,目前的分工是趋境联合清华KVCache.AI团队共同做技术研发,同时趋境科技负责商业化转化。

清华KVCache.AI团队,由清华助理教授章明星负责,团队在包括OSDI、SOSP、ASPLOS、HPCA、FSE、VLDB、ATC、EuroSys 等国际顶级会议和期刊上发表论文二十余篇,数个国家级创新奖项。

我们双方和月之暗面、阿里、华为等业内主要厂商均有深度协作,刚刚共同发布了Mooncake的开源项目,共建以KVCache为中心的推理架构。

目前团队大概90%以上都是硕士,50%以上是博士,整体以清华系为主,还有来自包括新加坡国立、哈工大、中科院、北航、北邮等院校的毕业生。

Q:为什么会选择做大模型知识推理一体机这一赛道,背后衡量的点是什么?用“以存换算”的思路进行布局,能否详细的讲述一下这背后的思考?

A:我们的产品名为大模型知识推理一体机,主要是以软硬件一体的交付形态,到产品层面则是大模型知识推理平台,有办公助手、智能客服、智能搜索等等应用,客户开箱即用,客户也可以调用 API ,提供大模型的能力,对接到现有的产品中。我们核心观点是怎么能够降低大模型落地准入门槛,以及帮助企业能够真正落地专属大模型产品。所以我们实际做的,是一款高性能、低成本、高效率的解决方案,其能够助力千行百业的私有化大模型快速落地。

大模型在业务侧落地成本和延迟都非常高,在业务侧单次请求的prompt长度往往需要几千或者上万Token,甚至是基于COT,这就需要进行复杂推理,就像OpenAI的o1。事实上,我们在去年就已经发现:基于COT做深层次推理,能够让大模型效果更好。但这背后关键问题就在于推理成本很高。

比如在客服场景,用户咨询一个问题,这背后的大模型经过深层次推理,加上外部知识,可能需要几十秒钟才能完成一个问题的完整回复。这段时间内,大模型一直在进行计算,也意味着几十秒内这台机器的很多计算资源被独占。如果线上上万人,就需要横向扩展数百台机器,这个成本是不能接受的。

所以在去年我们讨论这个问题的时候,就发现私有化模型落地的最大问题,是有一个不可能的三角形,它既要效果,又要效率,还要成本。

效果,是我们希望有更大的模型,模型越大,效果越好。但模型越大,成本也就越高。并且成本的量级不是简单几倍数的提升,而是非常大的量级的提升。同时,模型大、成本低的情况下,还要求响应的延迟足够低,所以这就变成了不可能完成的三角形。

这个问题的关键是GPU算力的制约,因为现有技术下GPU的利用率已经较高,进一步提升的空间有限。

而我们之前的研究方向主要是并行计算、分布式存储等计算机体系结构相关的领域,我们关注一台服务器的全部硬件资源,而不仅仅是GPU。因此我们想到一个点,为什么大模型推理过程中,只能用GPU?GPU是很强,就好比汽车中的发动机,发动机做的好,汽车确实跑的快。但想要汽车跑得更快,不只是需要增强发动机本身,还需要结合空气动力学、传动轴、轮胎等性能。如果想要把性能发挥到极致,就要把整个机器所有性能都发挥极致,才能够达到最好的性能优化。

所以,我们就提出了全系统协同优化,相当于把机器内所有硬件资源全部用上,包括GPUCPU内存硬盘等,而其中的关键在于怎么利用这些资源。

与此同时,我们国产GPU卡,与英伟达的产品在实际性能上还是有一些差距。如果只关注GPU的优化,大模型的落地成本会进一步提升。

因此,在这基础之上,我们提出了2个核心观点,一个是以存换算,释放存力作为算力的补充,降低对算力的需求;二则是全系统异构协同优化,紧密联动 HBM/DRAM/SSD 和 CPU/GPU/NPU 全系统异构设备,突破显存容量的限制,充分释放全系统的存力和算力。

Q:“以存换算”背后的技术逻辑是什么?

A:大模型推理的时候,特别是在RAG场景相关应用上,需要不停地调用知识库里的内容,给到大模型做推理。

现阶段在智能问答、智能客服等场景中,知识库的运用实际上还是以RAG为核心方式。遇到用户的提问时,传统的做法是把这些问题和答案缓存下来,后续如果有用户提问相似问题,就可以给到答案,类似“死记硬背”。

但问题在于,用户的提问永远是千变万化的,很难命中原来一模一样的问题。

实际上,在RAG场景,我们可以做一个大的存储体,这个存储体存储的不是文档,而是模型推理过程中的中间结果,可以理解为大模型推理结果的记忆元。就像我们的大脑一样,储存了海量的运算好的信息,在我们想要表达或者推理的时候,能够从大脑中调用出一部分运算好的信息供我们使用。

传统的Attention计算,当遇到一个新的问题时,会调用问题的相关产品信息,组成一个比较大的prompt,给大模型做现场推理计算,就像要求一个人现场看完一本之前没看过的书,需要的整体理解和阅读时间周期都很长。

而我们的想法是,针对这个问题,已经有了一部分记忆元,在另外一个人提出问题时,就已经有相关知识记忆存储,就好像我在做现场推理的时候,这本书我已经看过了,但是没有看全,但基于看到的一些新内容+之前已有的相关知识,在做现场推理时,速度会快很多。

因此,我们不是在做死记硬背,而是在做融合推理。通过修改大模型里面关键的算子,做记忆与现场推理的融合计算,能够比原来传统推理有10倍性能的提升,尤其是在RAG场景中。

Q:以存换算这一技术,为什么大模型公司不能够自己做?

A:对于大模型公司而言,他们更多的关注点可能会放在模型效果上,所以技术方向也会偏重训练层。而我们主要面向的是ToB的企业,他们对于成本更加敏感,“以存换算”主要解决推理部署的成本问题,因此我们在这个方面技术上研究更加深入。

(2)生存发展的关键,是保持核心技术领先性

Q:大模型知识一体机是一个硬件产品?是否需要一套单独的软件算法系统,来进行单独的适配?最后落地给客户,是以硬件的形式交付,还是以软件的形式交付?

A:主要产品交付形态是一个软硬一体的推理一体机。之所以选择软硬一体的形态,是因为需要进行硬件协同,一个普普通通的机器是不能满足这一要求,因为从整个机器的设计上来讲,我们需要更多的内存和更好的CPU支持,但有可能是更少的GPU算力支持,包括对带宽、硬件的选型,基于客户业务诉求我们都会有很多的考虑。

我们做异构协同的话,必须把整台机器的硬件资源都进行一定的调配,甚至是有一些主板层面的设计。在给业务方交付时,以一体机的交付形态。既可以提供丰富的API接口给业务方使用,第三方厂商或者是ISV,只要调用API,就可以完成大模型推理。也可以提供推理平台,并内置了一些简单应用,类似企业搜索智能问答、各种智能体等,同时客户也可以根据业务需求再进行拓展。

对于一些终端客户来讲,他可能有些应用就已经足够了,我们更希望的一种模式是,我们搭的是一个架子,房顶上的这些应用是由大家来开发,然后利用我们架子能够更好的降低成本。

Q:目前在硬件的选择上有具体的倾向吗?未来在硬件层面有哪些规划?

A:目前几款主流的国产GPU和NVIDIA GPU的都能支持。未来我们考虑更多硬件层面的布局,例如主板的设计、分离式架构设计、存算融合等等。

Q:目前各大云厂商也都在做智算中心等AI Infra基础设施,您认为作为创企,要如何与大厂们进行竞争?同时,目前在行业中已经有了一批早期的创企,并取得了一定的成绩,作为后来者,趋境科技又该如何进行差异化竞争?核心优势在哪?

A:实际上,我们的技术思路和客群选择和当前的大厂以及AI Infra厂商都有所不同,因此目前没有明确的竞争关系。此外,AI Infra还是一个相对蓝海的市场,大家都有可以服务的客群。

另外,我们比较坚持的一点,就是要把“以存换算”和“全系统协同优化”技术持续做下去,我们观测到未来推理成本降低不止10倍,要降到千倍。

我们也遇到很多客户,72B的大模型很有用,但出于成本的考虑,最终只会选择7B或13B的模型,这就是一个妥协。还有些做智能客服的企业,为了控制成本,可能会在整个系统中只用10%的大模型。因此,降低大模型的准入门槛,是ToB侧客户落地大模型时最广泛的需求。

我们认为在自己专注的技术领域坚持研发投入,持续建立领先的技术优势、做客户真正需要的产品、提供更好的服务支持,才能在竞争中生存下去。

(3)做私有化大模型部署,与云厂商不存在竞争关系

Q:大模型很多算力都是花在训练上,我们为什么不做大模型的训练?

A:大模型训练的成本很高,对数据质量、人员标注能力都有很高的要求,训练不好很有可能出现灾难性遗忘等问题。实际上现阶段通用大模型,经过了一年多的技术演进,配合RAG技术和In-Context Learning(上下文学习),甚至比通过领域数据训练的模型效果还要好,已经能够满足大部分客户的业务使用场景。

而阻碍客户大模型落地的核心痛点是推理端算力的成本,因此我们更加关注大模型的私有化落地推理侧的性能优化问题。

Q:基于以存换算的技术思路,以存储的形式,尤其是私有化部署大模型的方式,是否会受到大模型更新迭代的影响?

A:我们实际上是在通用大模型之外,加入了知识推理能力。我们不仅做硬件加速,也做了深度推理,也就是o1的功能。因此,通用大模型的发展对这件事情反而是有促进作用,可以根据模型的能力更换通用大模型来达成AI能力的升级。我们不是训练大模型,而是通过推理来减少大模型幻觉,增强他的推理能力。

此外,基于Transformer架构的大模型底层的推理逻辑相似,新的模型的适配工作并不大,不需要太多的定制化开发。

Q:目前主要业务是以私有化部署为主,但云厂商们都号召大家把大模型部署在云上,那您认为未来私有化部署的空间是否被压缩?

A:我们反而觉得私有化是很大的一个空间,因为很多数据,比如公司的经营决策数据、财务数据、核心文档数据、客户信息、员工信息等,都需要私有化,这是企业的商业机密。

因此,一些企业会选择私有化这种最保险的方式,B端市场也是个很大的市场,有私有化诉求的这一类客户群规模还是比较大,需求也相对可控。

京公网安备 11011402013531号

京公网安备 11011402013531号