文|周鑫雨

编辑|苏建勋

Luma AI在视频领域叫板OpenAI故事,好比中途改打网球的杜兰特,打赢了网球男单大满贯纳达尔。

最近,这家成立于2021年的硅谷AI公司,在和《智能涌现》的交流中,复盘了视频生成模型Dream Machine AI爆火的过程。

在硅谷率先发布一款效果能对标OpenAI Sora的视频模型,对一家初创公司而言并不容易——更何况,Luma AI在视频生成领域算得上是“半路出家”:

2024年前,这还是个主攻3D生成、规模在10人左右的小公司。Luma AI数据产品负责人Barkley Dai告诉《智能涌现》,2023年12月决定转型做视频生成后,团队才扩充了视频领域的人才,规模增加到了50人。

他提到,Luma AI能成为视频生成领域的蚂蚁雄兵,技术实力、发布时机和运营策略缺一不可。

人才,是这家公司认为做出视频模型最重要的资产。2023年12月,决定从3D转型做视频生成后,Luma AI吸纳了40个AI领域的人才。

而和OpenAI、Google打擂台,Luma AI又对模型的算法和Infra做了诸多优化。Barkley对《智能涌现》表示,团队在Sora同款DiT架构的基础上,采用了独家改进的架构,保证生成效果的同时,还节省了训练和推理成本。

视频模型“Dream Machine AI”的发布时间,2024年6月13日,踩中了视频模型赛道的空白点——这也让Dream Machine AI具有了稀缺性,除了快手“可灵”之外,这是唯一真正对大众开放的视频模型;

而模型的“限免”策略,又立刻吸引了大量试用者:上线4天,Dream Machine AI的用户量就破了百万。Barkley对《智能涌现》透露,Dream Machine AI的投流费用是0,全靠KOL自发安利,和用户的口碑发酵。

爆火之后,提高用户留存,不让辉煌昙花一现,是Luma AI如今的命题。

2024年11月26日,在视频模型发布后近6个月,Luma AI在iOS和web端上线了Dream Machine AI创意平台。与之配套发布的,还有Luma AI自研的首款图像生成模型,Luma Photon。

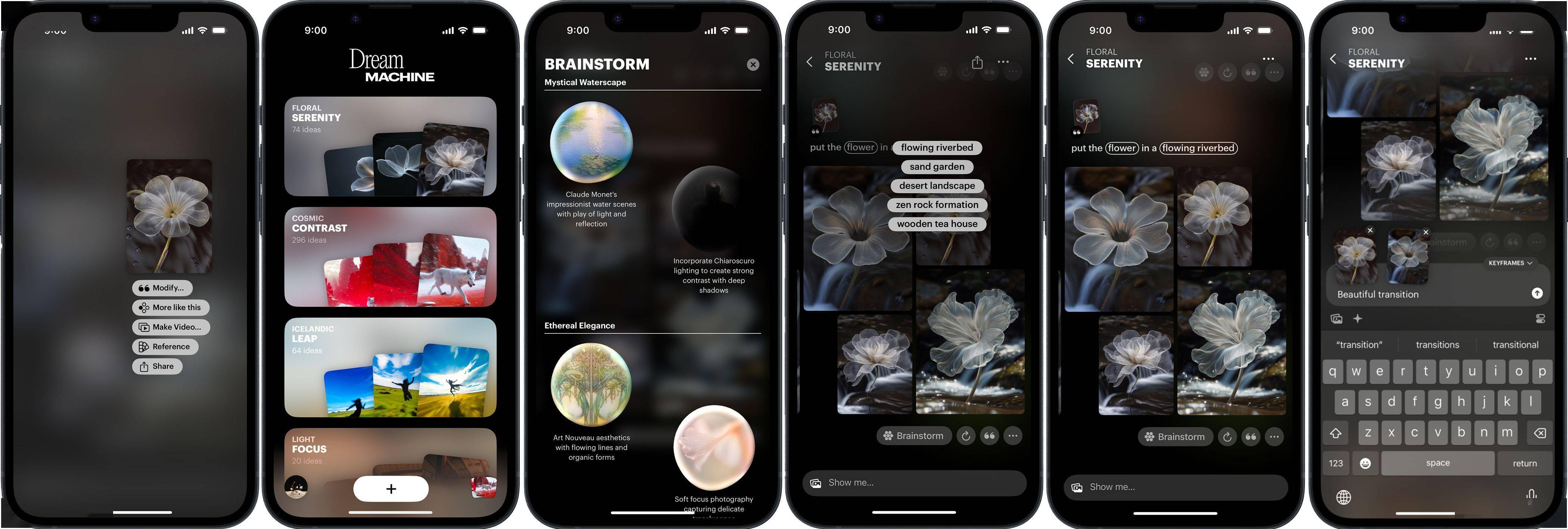

△Dream Machine iOS界面。

Luma AI产品设计师Jiacheng Yang(杨家诚)告诉《智能涌现》,与Midjourney、Adobe等专业设计工具不同,Dream Machine不需要用户学习如何写prompt(提示词),也不需要用户懂设计,“我们的目标就是做一款AI小白和设计小白都能轻易上手的AI视觉工具”。

据他介绍,Dream Machine共有5个核心功能:

(1)用自然语言进行对话,实现图片的创作生成和编辑;

(2)由AI提供创意点子,根据用户输入的prompt,自动提供创意、风格选项;

(3)视觉参照,根据用户输入的照片,生成带有相同主体或者风格的图片;

(4)将AI设计的图片转化为视频,供用户查看图片中主体在不同角度下呈现出的细节;

(5)将所有AI生成的素材发布在面板上,并生成可供分享的链接,有助于团队进行头脑风暴。

△Dream Machine视觉参照功能。

为什么选择用图像设计平台,去承接视频模型的用户?“想要扩大AI视觉领域用户的盘子,只有视频生成是不够的。图像生成的应用场景会更广泛,所以我们想做一个很好上手的设计平台,用户能够轻易上手的同时,也能展现我们的模型能力。”Barkley提到。

行业竞争,是作为初创企业的Luma AI不得不面对的问题。他们认为,打出差异化优势,是让模型和产品在行业中具有辨识度和获客的关键。

比如面对Midjourney等图像产品的竞争,Dream Machine把语言理解能力做到了“天花板”。以及,这也是一个最会设计字体的模型——相较于Midjourney和GPT生成的带文字的图片,Dream Machine图片中文字的设计感和清晰度是最高的。

△Dream Machine在图片中生成的配文。

和视频模型一样,Luma AI给Dream Machine花费的投流预算,是0。在Barkley看来,烧钱营销看的是回报率,这意味着最终还是要用产品说话。以及,“AI市场还很小,我觉得对AI公司来说,烧钱营销还为时尚早。还不如把营销的钱,投到产品研发上”。

以下《智能涌现》与Luma AI增长负责人Barkley Dai、Luma AI产品设计师Jiacheng Yang的交流,内容略经《智能涌现》编辑:

烧钱营销,AI公司还为时尚早

《智能涌现》:2024年6月发布视频模型Dream Machine的时候,团队有没有预料到会爆火?

Barkley:其实当时是远超我们预期的,我们一度出现服务器和GPU资源没有办法承受的情况。

《智能涌现》:如果要总结爆火的经验,你觉得是什么?

Barkley:其实最早发布的版本,还不是效果最好的版本。但我们决定全量免费放给所有的用户去使用。

在当时,还没有一个视频模型能够做到这样。所以短时间内吸引了很多用户的关注。

《智能涌现》:对于创业公司来说,做免费的决定是不是还挺不容易的?

Barkley:其实我们当时也给免费设置了一个额度,我觉得这是一个行业的standard practice(基本操作)。

只是当时的峰值对我们来说过高,大量的用户在短时间内涌入,服务器后台收到了太多的request。

《智能涌现》:公司能负担流量带来的推理成本吗?

Barkley:其实我们还是在技术层面做了很多成本的优化,比如不断去提升视频生成的速度,最开始我们的模型生成5秒的视频需要120秒,现在只需要20秒。

以及在保持原有生成质量的情况下,视频模型的推理还有很多优化的空间。所以在半年时间里,视频模型的成本是在下降的。

所以我觉得推理成本对我们来说不是特别大的负担,当然也是一笔开支,但未来会变低。

《智能涌现》:你提到Dream Machine是有免费额度的,那么使用完免费额度后的用户付费率怎样?

Barkley:说实话我们对付费率完全没有任何预期。因为当时我们对Dream Machine的定位是教育用户的产品,让用户知道Luma AI视频生成的潜力有多大。当时市面上还没有一个视频模型是按照对标Sora的水平发布的,所以我们对付费率完全没有对标的对象。

但现在发布的AI设计平台,我们的定位是最终去获客的产品。所以现在我们对它的收入和付费率有更高的期待。

《智能涌现》:Dream Machine在营销上投入了多少?

Barkley:0,我们在发布的时候没有做任何的营销付费。

当然我们提前去联系了很多创作者,他们试用后都觉得很兴奋,甚至大多数人之前用过Runway,还有人用过可灵。但他们用了我们的产品后,都觉得说“This is the next big thing”,在推特上自发帮我们推广。

但我们没有做任何的投放,因为我们还是坚信成功的因素就是产品本身。

《智能涌现》:烧钱营销,这一套打法在硅谷AI公司常见吗?

Barkley:我感觉硅谷大部分还是比较产品驱动的,运营这一套主要是中国公司。

视觉领域的市场还很小,我觉得对AI公司来说,烧钱营销还为时尚早。即便ChatGPT的用户很多,但是像一些视觉模型,用户还是很少数。

这个时候如果你做投流,去做跑马圈地,留存肯定不高,还不如把这些钱投入到模型和产品的研发上,用更好的模型和产品吸引用户的增长。

《智能涌现》:在发布视频模型之前,Luma AI的技术和产品还是围绕3D生成的。团队是什么时候决定做视频生成模型的?

Barkley:大约在2023年12月。

《智能涌现》:为什么从3D转向做视频和图像模型?

Barkley:我们原来其实也不会说自己是一个3D公司,公司的定位还是视觉领域的AI公司,我们想去理解这个世界在视觉上的构造,是如何帮助AI对世界进行理解的。

从创始团队的研究背景来看,一开始3D是Luma AI比绝大多数公司和团队更擅长的事。后续我们也确实做了很多3D生成上的技术突破。

但是3D可以被用于训练的数据量级,相较于图片和视频来说都会少很多。同时在使用场景上,目前手机和电脑还是主要的产品载体,但3D也会比视频更受到限制。

但是当我们有更多的算力、更多的人才,也有更多的能力去推进我们的愿景,也就是更好地了解世界,我们也自然地会从3D转向做视频。

《智能涌现》:这会不会让公司看起来战略有些摇摆?

Barkley:从我作为一个内部成员的视角来看,我觉得不管是3D还是视频生成,一直都是合理的。

因为不管是3D,还是视频和图片,都只是一种模态。如果我们最终想做到的是对这个世界的理解,那么不管是一种模态、一种生成,还是一种创意的发挥,我觉得只要目标不变,这些媒介就只是帮我们达成目标的手段。

《智能涌现》:从3D转型做视频生成,期间有遇到什么困难吗?

Barkley:我觉得整个过程还是比较顺利的,因为我们在做3D生成的时候,团队也就在十几人的规模,但当我们做视频生成以后,引入了很多视频领域的人才,现在团队规模已经超过了50人。

这个过程其实是吸纳了更多新成员去推进目标的实现,而不是说原来大家就在频繁地换方向。只是原来做3D的人,现在也在逐渐开始做视频方面,比如数据等各方面的工作。

《智能涌现》:做3D的经历对视频生成有帮助吗?很多反馈说Dream Machine的运动轨迹做得很好,这和3D积累下的空间理解能力有关吗?

Barkley:我觉得可能不一定有那么直接的关系。

但从我们发布最早版本的视频模型开始,我们对相机的轨迹运动,包括视频里有多少机位的变化,是十分侧重的。

所以当时用户也会普遍反馈说,Luma AI的模型虽然有时候生成结果不是那么稳定,但是它能给到很多的机位的移动,以及复杂的人物运动轨迹。

我觉得过去在3D上的一些经验,能够让我们在做视觉模型的时候,意识到提升机位的丰富度和运动轨迹的复杂度,能够提高用户对视频生成内容的消费意愿。

不过我觉得过去的经验,包括模型本身之间,其实没有那么大的关联性和借鉴意义。

《智能涌现》:所以技术转型最重要还是补充新的技术人才是吗?

Barkley:是的。

承接住模型的爆火,需要有产品

《智能涌现》:6月份Dream Machine走红后,你们怎么考虑用户留存的问题?

Barkley:我们发布Dream Machine的时候,就知道后面一定要有产品去承接用户持续稳定的需求。

比如你作为一个ChatGPT的长期用户,即便后续会出来很多能力做得和GPT差不多的模型,你还是大概率会选择使用ChatGPT。因为ChatGPT通过长期的深度学习,已经把握了用户习惯,能够更好地理解你的意图。

行业里永远会有更好的模型出现,但产品最终是能够让用户留存的点。

《智能涌现》:团队是从什么时候计划做这样AI设计平台的?

Barkley:这个想法其实在我们最开始做视频模型的时候就有了。所以产品的想法是去年(2023年)12月和视频模型同步推进的。

只是在产品的设计过程中,我们后来意识到,要想把整个设计流程涵盖,也必须要做到能够生成图片。所以在视频模型发布5个月以后,我们觉得图片模型也足够好的时候,把两部分同时整合成一个产品。

《智能涌现》:平台的目标用户是哪些人?专业设计师还是大众?

Barkley:其实我们觉得原来的Dream Machine,更多的用户还是偏专业的,至少是有做AI电影的经验,或者知道怎么用prompt去生成更好的效果。

但其实我们更希望现在的产品,让之前没有用过AI甚至没有设计经验的人用起来。比如,如果他们在工作中需要用这样的流程,可以非常容易地通过一轮一轮地和AI进行对话去实现。

我们在6月份发布的视频模型Dream Machine,其实还是需要一些使用门槛的。我们在那时候就在想,希望普通人也能access这些视觉工具,就好比视觉里的GPT。

但视觉是一个很小众的垂类领域。我们做设计平台的想法就是,如何去扩大这个群体。只有扩大群体,才能让视觉领域的AI获得更好的发展。

《智能涌现》:非专业设计师很难把一整套设计的工作流用得很深入。我的大部分生图需求,可能输入一个简单的prompt,用GPT,或者Midjourney就能满足。

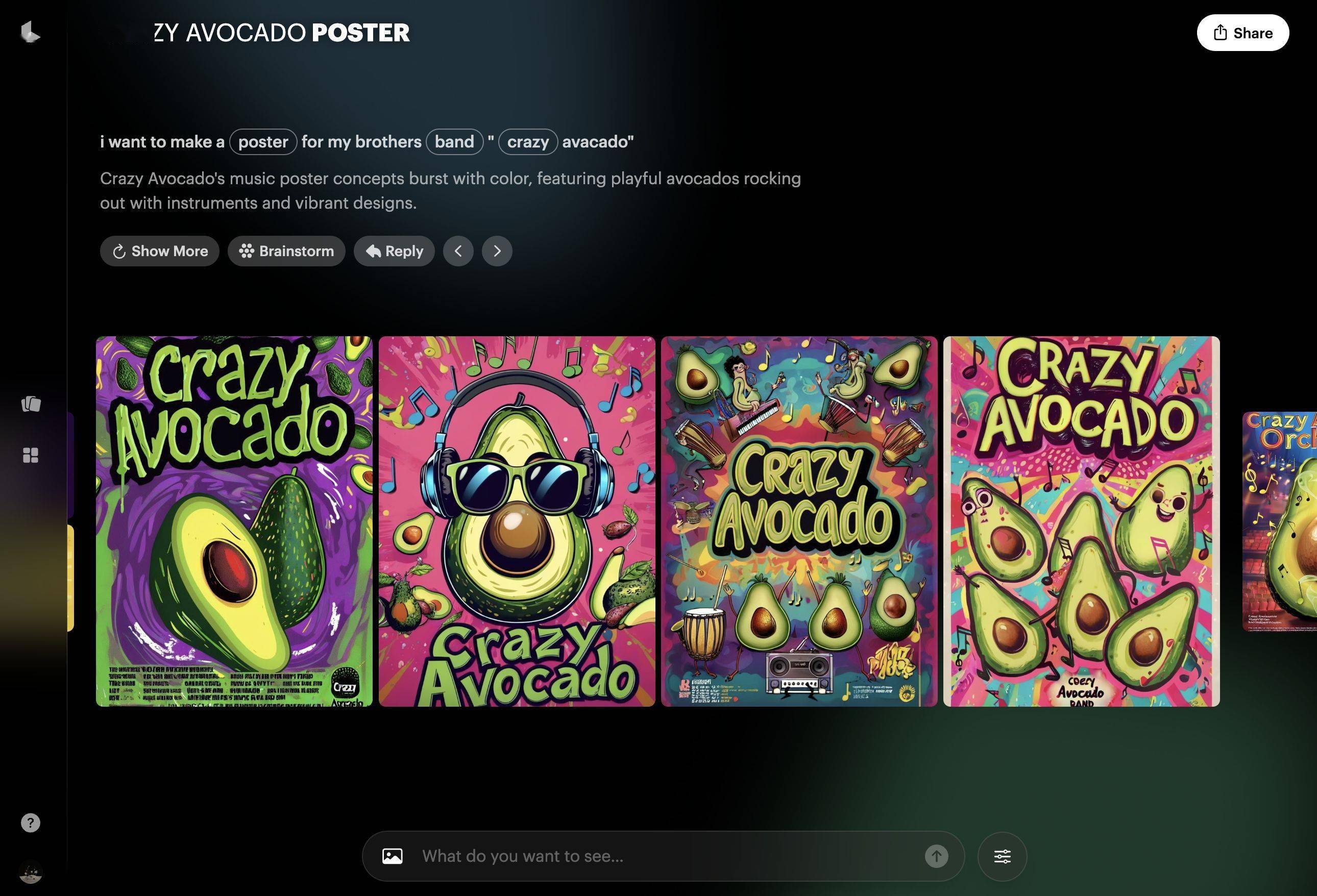

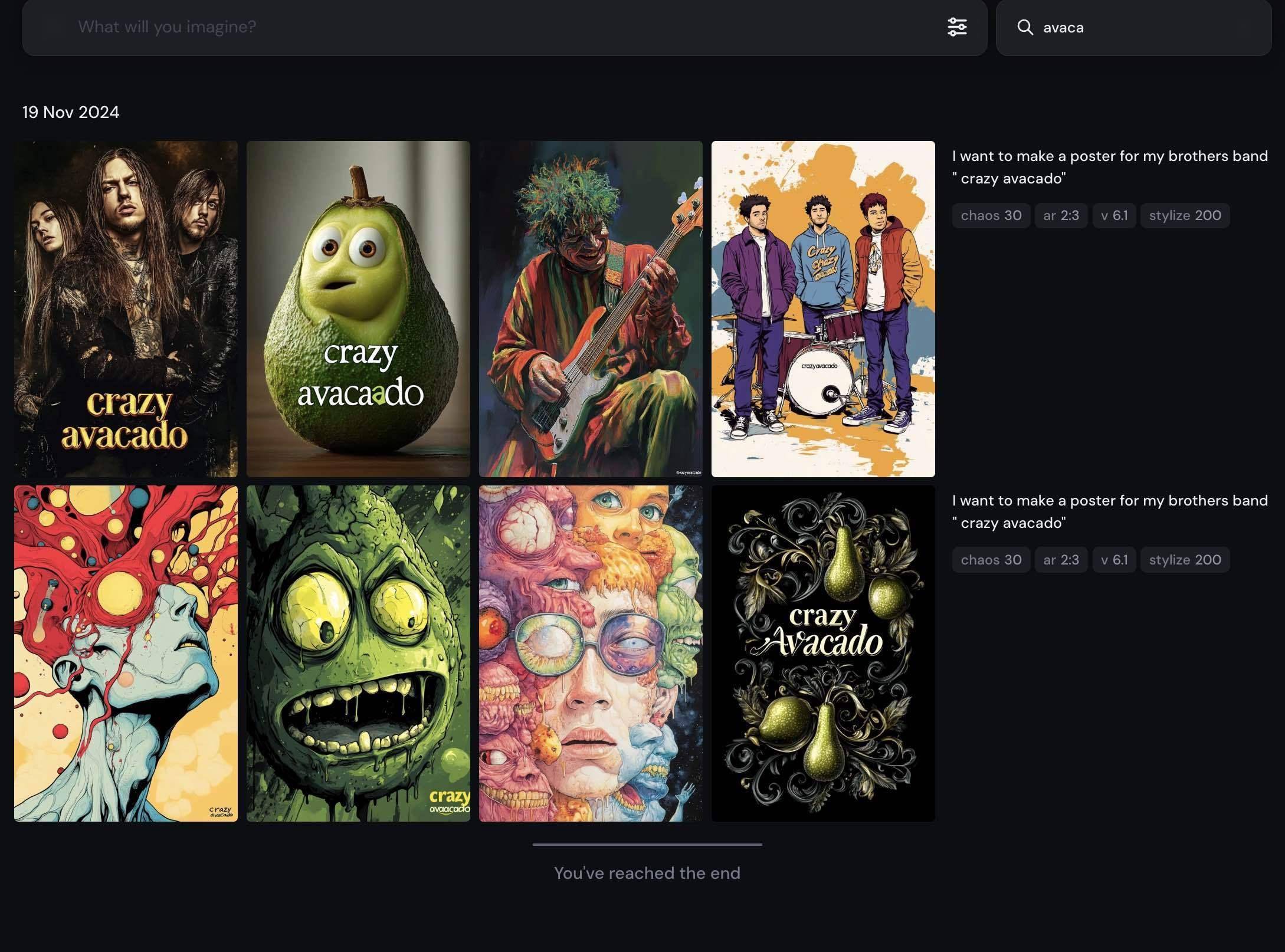

Jiacheng:我们的想法是,把用户能轻易感受到差别的功能做到最好,比如我们图像能力比GPT好,但是语言理解能力比Midjourney要好。

我用同一个最基础、完全不复杂的prompt,让Dream Machine和Midjourney对比一下:i want to make a poster for my brother band “crazy avocado”.(我想为我兄弟的乐队“疯狂牛油果”做一张海报。)

△Dream Machine根据“i want to make a poster for my brother band ‘crazy avocado’”生成的乐队海报。

△Midjourney根据“i want to make a poster for my brother band ‘crazy avocado’”生成的乐队海报。

你看Midjourney生成的海报,既不Crazy,也没有Avocado的元素,也看不出来是个乐队的海报。

语义理解的能力其实比你想象的重要,会影响很多场景的落地。因为生成随机的、好看的图片,在实用场景中意义不是很大。

如果要让Midjourney真正还原你的意图,你需要写很多prompt,包括海报的设计、上面写的文字、解释Crazy的风格等等。学会写prompt,我大概花了两三个月时间。

但我相信ChatGPT的大部分用户是不会去学的,他们就是进来问一个问题,得到一个结论。

我们做设计产品的思路,也是一样的。按照之前市面上的产品,如果我想要得生成还原我意图的图片,首先,我要花20美金买Claude或者GPT,帮我生成prompt;其次,我要再花20美金到40美金买Midjourney,生成图片;最后我还要花20美金的订阅,把这些图片变成视频。

算下来,文生视频起码要花60-80美元。现在用Dream Machine,可能10美元就能搞定了。

《智能涌现》:Dream Machine语言理解能力的来源,也是自研模型吗?

Barkley:语言模型用了第三方的API,我们再去构建了一个Agent。这个Agent能够理解用户意图,然后通过不同的prompting的方式,把用户意图转化为图像和视觉模型能够理解的指令。

《智能涌现》:Luma AI现在既有模型,又有产品,怎么去做商业化?

Barkley:产品还是会采用订阅的方式。模型就是提供API。

《智能涌现》:不做定制化?

Barkley:定制化不太适合初创公司,会分散精力。

目前没有专业视觉工具,在定义交互范式

《智能涌现》:一个俗套的问题,你们怎么看待巨头下场?按照国内的情况,字节和快手的下场,已经给很多初创公司带来了融资和获客上的压力。

Barkley:我们发现,这个问题其实是公司和股东之间的问题。只有股东才会关心:如果哪天一个巨头把你这个事情做了,会怎么样?

但实际上,我们公司很多Research都有这样的感觉:当公司达到一定规模,需要你去协调各种各样的东西的时候,你推进的速度会变得特别慢,创新的速度也会掉下来。

虽然Luma AI的团队在过去一年多的时间里也扩张了很多,但还是保持着快速创新、快速迭代的节奏。

我觉得有一个类比特别好:其实你在大公司里,真正去做视频模型和相应产品的团队,可能也只有几十个人。比如OpenAI看起来很大,但Sora的团队也就这么多。

当然说到更大的公司,比如Google,他们可能有比我们更好的distribution channel(扩散渠道),但他们同样会受制于各种流程上,一个新产品会有商业化等很多方面的concern,推进的速度不会那么快。

《智能涌现》:Luma AI的迭代节奏有多快?

Barkley:整体迭代速度一直是以几个月,甚至是1-2个月来计算的。期间会加入新的功能,底层模型的效果也在提升。

就像Dream Machine 1.0在2024年6月发布,1.5版本是在8月发布。1.6版本加了camera control(镜头控制)功能,在9月底发布。

《智能涌现》:一个新的设计工具型产品,怎么去获客?

Jiacheng:我觉得首先可以去分析ChatGPT是怎么获客的。你会发现,ChatGPT不光最好的程序员在用,你隔壁的大叔大妈也在用。

我觉得AI工具带来的最大的变化是,由于它本身的可塑性和灵活性,它可以服务几乎所有有视觉需求的人。

我并不觉得目前特定的视觉专业的软件,有非常好的交互,换句话说,目前没有专业视觉工具定义了整个行业的交互范式。

《智能涌现》:你怎么定义“好的交互范式”?

Jiacheng:比如ChatGPT就定义了整个行业ChatBot的交互范式,像现在美国的小孩都不是说ChatGPT,他都是说你有么有问你家的“Chat”。

这里的“Chat”,已经成了一个像“Google一下”的行为。

我们做Dream Machine也是一样的。谁能先把普通大众的想象,通过一个流畅、简单的方法,呈现出一个好看有趣,然后能分享给别人的或者有用的图片,谁就能在这个领域有优势。

《智能涌现》:从立项到上线,期间你们对交互形式进行了哪些探索?

Jiacheng:我们目前来说,包括行业对我们的认知,都是一个视频模型科研公司。

但是如今的AI技术是一个非常以用户体验为核心的产品,技术型产品的目标和迭代过程很明显,就是最好的用户体验。

我们能想到的最好的用户体验,就是用最自然的交流方式,把Dream Machine当成一个创意助手或者Creative Partner。你怎么和设计师互动,就怎么和系统互动。

有了这样一个目标,我们就会去了解我们的图片和视频模型,能够提供怎样的能力。同时也去了解整个行业处于怎样的发展阶段,第三方的语言模型能够给我们怎样的帮助。

期间,各种各样的Agent软件工具也在迭代,大家对于AI应用层的思考也有变化。所以一年以来,我们的产品就是一个持续迭代的过程,具体就是一个月根据行业变化打磨,再花一个月去修改。

这些东西总体统筹、融合起来,才有了现在这样的效果。

Barkley:期间我们也发现,在AI视频生成领域,目前图生视频比文生视频更加受欢迎,因为用户在乎可控性。

所以所有能够提升可控性的,都是用户非常需要的功能点。

《智能涌现》:期间行业哪些产品或者认知的动向,会对公司的产品研发节奏产生影响?

Barkley:其实我觉得过去一年时间里,我们的产品策略没有变太多,还是一直想做能让所有人轻松使用模型的产品,不会随着其他AI产品的发布去做任何的策略调整。

我觉得产品团队更关心的事一些Research上的动态和进展,比如我们想做风格转换、风格迁移的功能,就会去查有哪些最新的学术研究和论文,甚至产品团队会加入Research团队的讨论,去看研发功能的可行性。

《智能涌现》:产品团队在日常工作中是怎么和算法团队交流的?

Barkley:立项的时候,我们会从用户的角度,觉得风格借鉴这样的功能很重要。

但是从Research的角度,其实他们不确定这个功能能不能做出来,以及能达到怎样的效果。所以Research会先去做很多的实验,直到他们把算法做出来以后,我们看到这个功能的极限,再去思考怎么把功能融入到整体产品和体验上。

所以其实Research是一个更加不确定的过程,往往需要比较长的时间,也不知道要花多长时间训练。

《智能涌现》:期间也会舍弃很多暂时不够好的功能。

Barkley:对。所以其实很多功能我们会从用户的角度去想,有的功能Research团队能够在短时间内做出来,有的功能我们又继续投入,去做更长的研判,体现在未来的产品里。

!

京公网安备 11011402013531号

京公网安备 11011402013531号