AI人工智能正进入汹涌浪潮的新时代。

无论是底层算力芯片硬件,还是中间层开发框架,又或者顶层应用生态,都呈现出了百花齐放、百舸争流的无限活力,也常常会引发猜想和争论:

到底谁才是适应未来潮流的最佳AI计算平台?GPU是否真的让其他所有计算芯片都黯然失色?新势力如何崛起?传统势力如何激发活力?

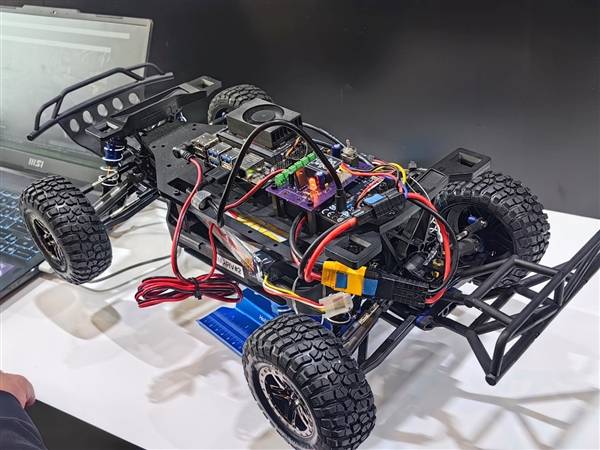

近日,一年一度的Arm Tech Symposia年度技术大会在亚太五大城市巡回举办,尤其是在国内的上海、深圳两站,带来了4场主题演讲、4场深度对话、13场生态伙伴技术演讲、33场Arm专题技术演讲、2场开发者工作坊,共有超过3500位行业专业人士、工程师、开发者参会探讨。

从这次技术盛宴中,或许我们可以得到一些思考。

AI已经诞生超过半个世纪,不断演进变革,如今更是迎来了全新的AI计算时代,极有潜力成为当代人类历史上最重要的技术。

事实上,AI一直都在,包括看似普通的手机解锁、影视特效、照片修复等等日常操作,都离不开AI的力量。

当然对许多人而言,ChatGPT的出现才让AI真正爆发,真正触达普通人的日常生活和工作,甚至是科学研究。

比如DeepMind最近使用AI预测蛋白质结构而荣获诺贝尔化学奖,比如AI将临床试验的时间缩短高达50%,这些努力都将挽救难以计数的生命,提高人类生存质量。

在中国,AI更是有着无穷的潜力和广阔的前景。有机构预测,到2026年底,中国的道路上将有100多万辆搭载L3级别ADAS(高级驾驶辅助系统)的汽车。

在智能终端领域,预计到今年年底,中国将有1.7亿台以上支持AI的智能手机,55%的PC都会支持AI功能。

正是这些AI,在改变着我们与世界交互的方式,让我们的生活更简单、更安全,为更美好的未来奠定了基础。

在技术上,AI比历史上任何一项技术变革都需要更高的算力、更大的内存、更好的能效,需要将大量算力部署在极度受限的功耗环境中,而这正是Arm的强项。

历史上,每一步计算技术的变革与转型,都需要具备卓越性能、能效、扩展性的计算解决方案,能够加速产品上市与普及,这正是面向未来的Arm计算平台的核心特性。

如今说起AI计算,很多人都会下意识地想到GPU,想到NVIDIA,想到黄仁勋。

确实,老黄打造的一代又一代高性能GPU,算力无可匹敌,生态更是牢不可破,一直是AI大模型训练、AI计算加速的首选方案,老黄甚至多次得意地宣称“GPU将会彻底取代CPU”。

不过说实话,老黄自己内心肯定也明白,这不过是宣传话术,他自己都不信,不然为什么还要费心费力打造Arm架构的Grace CPU来搭配GPU加速器组成完整的服务器?为什么还一直念念不忘要进入AI PC CPU市场?

诚然,GPU算力最强,还不断涌现各种AI加速芯片方案,NPU、TPU、ASIC、FPGA等都在争夺一席之地,但是几十年来,CPU的核心中枢地位从未改变。

在某个特定方面,CPU肯定不如五花八门的加速芯片,但它强就强在通用性和适应性,什么都能做,而且就像个指挥家,可以调动、联合任何其他硬件,满足各种各样的AI计算所需,发挥最高效率与能效。

更何况,CPU本身也在不断自我革新进化,计算性能突飞猛进,可以灵活地满足各种计算与控制需求。

那么,AI计算时代,我们需要什么样的CPU?

Arm 基础设施事业部产品解决方案副总裁Dermot O’ Driscoll指出,AI需求庞大,促使我们重新思考如何打造计算要素,同时我们正面临全新的需求,无是算力、性能、能效,还是上市时间,需求都在不断提升,因此我们需要重新思考一切。

构建计算的方式也必须随之演变。芯片不再是单一的模块或组件,这样无法充分释放性能和能效,需要整体的解决方案,需要深度的集成,需要充分的功能协作,从而实现更低的延迟、更高的带宽、更高的能效。

为了充分满足未来AI计算所需,我们需要强大、弹性的计算平台,需要释放足够的性能与能效,需要丰富、易用的开发工具,需要打造广阔的生态,需要方案快速上市落地。

基于这样的思考,Arm正在AI计算时代重塑自己,重塑整个行业。

Arm CPU历史源远流长,凭借其优秀强大的架构设计、丰富灵活的技术特性、超高的能效,已经进入我们工作生活的方方面面,几乎无所不在。

从智能手机到消费电子,从智能家居到智能汽车再到智能物联网,乃至从服务器到PC,到处都可以看到Arm芯片的影子。

迄今为止,合作伙伴基于Arm架构的芯片,出货量已超过3000亿颗!

如今,Arm已经不再是单一的芯片IP提供商,而是成功转型成为综合性的计算平台公司,特别是通过架构创新、软硬件深度融合,在这个AI时代持续引领计算的变革。

可以说,未来十年的Arm计算平台,都将持续为AI而优化,而所有这些功能将通过软硬件能力的结合来实现。

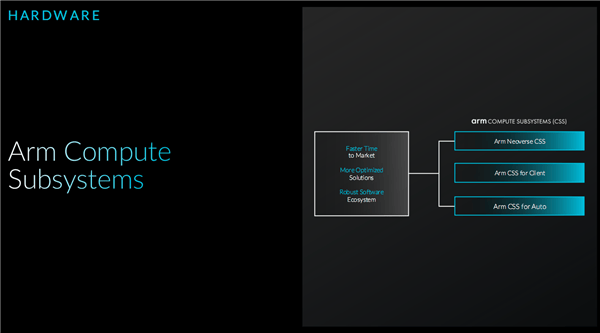

为了适应新的计算发展需求,Arm倾力打造了Arm计算子系统(CSS),采用更全面的系统级设计思维,针对服务器、客户端、汽车等不同应用市场都有对应的解决方案,服务于整个生态系统。

CSS特别强调硬件与软件的协同优化,尤其是扩展了底层技术,以满足不断演化的AI计算需求。

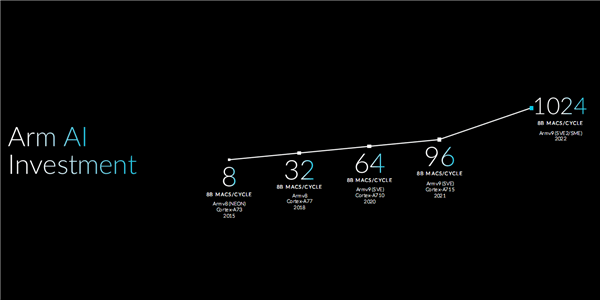

早在十多年前,Arm就已经悄然将AI功能引入Arm架构,Armv8架构又首次引入了64位技术,大大强化了计算能力。

不过,真正开启AI时代的,还是新一代的Armv9,经过多年连续投资与演化,又加入大量以AI为核心的功能,使得这一架构更加适用于未来发展,而这一进程还在持续。

Armv9架构有两大关键技术:

一是可伸缩向量扩展(SVE/SVE2),允许灵活的向量长度实现,使其能够在现在或将来的多应用场景下实现伸缩,允许CPU设计者自由选择向量的长度来实现。

已应用于一些领先的计算产品,

二是可伸缩矩阵扩展(SME),为开发者提供通用指令集,能够一次在多个硬件平台上实现Arm架构中的加速效果。

目前,Armv9架构和相关技术已经在大量产品中逐步落地,比如阿里巴巴的倚天710处理器,支撑着阿里倚天ECS的底层架构,可提供3.0GHz的高主频、双路256核心的高计算密度、空间节省50%的1U紧凑设计,等等。

再比如联发科的新一代天玑9400处理器,可利用SVE2加速工作负载,尤其是提升视频和图像处理,提供更好的照片质量。

Arm终端事业部产品管理副总裁James McNiven强调,Armv9作为最新的技术架构,设计伊始就是为支撑AI计算而生的,并且持续迭代更新,通过SVE、SVE2、SME等关键技术,不断优化AI计算体验,实现卓越的AI性能。

有了坚实的硬件,就相当于盖好了房子,而要想得到舒适的居住与生活体验,离不开精致的装修与布置,只有强大、全面、易用的开发,以及丰富、好用的软件体验,才能将硬件实力全部发挥出来,才能真正让人们感受到技术的进步,让生活和工作都更加美好。

如果没有良好的软件支持,再好的硬件也毫无意义,我们也见过一些令人惊艳的硬件,但由于软件表现不佳,甚至根本没有软件支持,结果没能发挥潜力。

业界趋势的变化,也充分说明了这一点,比如创业公司在AI浪潮前后在硬件和软件工程师的比例呈现了很大的变化。

Arm认为,更多的硬件带来更庞大的软件需求,而这样的需求又将进一步敦促硬件能力的提升,形成一个正向循环。

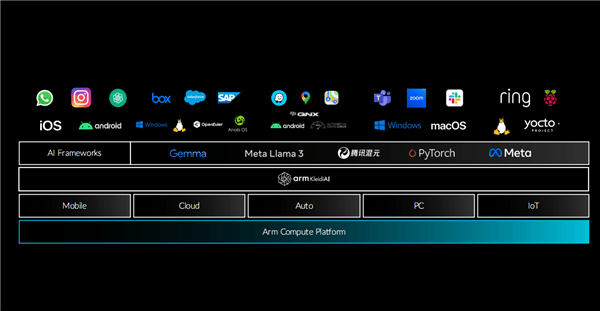

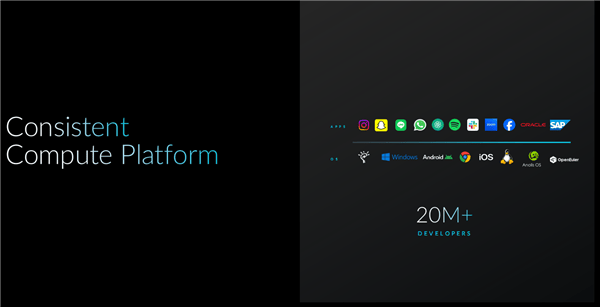

多年来,Arm平台汇聚了超过2000万的全球优秀开发者,积累了深厚的开发经验,而在AI时代,Arm更是适时打造了一整套的统一开发工具链,全面覆盖云侧、边缘侧、端侧等各个领域,为开发者提供强大支持。

Arm希望开发者不需要关心技术如何实现,而是专心思考想要开发什么,为此抽象化了许多硬件相关的技术细节,真正实现对开发者友好的设计,让他们能专注于打造优秀的软件与简单的整合。

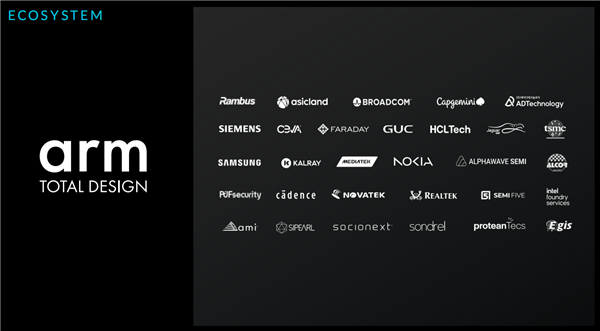

因此,Arm推出了Arm全面设计(ATD)生态合作平台,整合晶圆制造厂商、固件开发厂商、IP供应厂商、EDA设计厂商、芯片设计厂商等整个产业链,帮助生态系统合作伙伴专注于各自擅长的领域,更快、更具成本效益地开发出更好、更强大的产品。

截至今年10月,刚刚推出一年的ATD,生态企业已快速增加到30家,产品设计也在加速,尤其是基于Neoverse N系列或V系列计算子系统(CSS),以及采用chiplet芯粒设计的方案。

值得一提的是,联发科也在今年6月加入了ATD,预示着联发科也有望提出自己的Arm服务器芯片产品,还有传闻称联发科正在准备进入PC市场,芯片底层架构自然还是Arm。

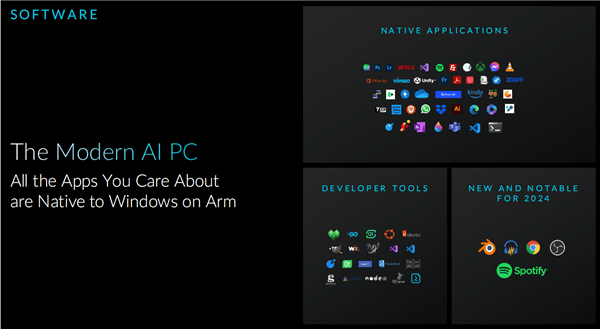

说到PC,基于Arm架构的AI PC也正在兴起,比如高通的骁龙X Elite/Plus系列就掀起了一股新的浪潮。

对于大家最关心的Arm架构AI PC软件生态问题,进展也是相当神速,无论是开发者工具,还是原生应用,都在日益丰富,满足人们的日常生活和工作已经问题不大,当然空间依然是巨大的。

联想全球中小企业产品和解决方案总经理郑爱国指出,联想将Windows on Arm(WoA)视为一项前瞻性的长期战略布局,一方面不断投入打造领先的产品,另一方面继续与包括Arm、微软在内的众多合作伙伴携手,共同推进生态的繁荣发展,为用户带来更多元化、更高质量的产品体验。

Arm还与开源社区有着持续的良好合作,特别是在中国市场,Arm与龙蜥社区、欧拉社区、OpenCloud OS等都有合作。

Arm 中国区业务全球副总裁邹挺表示,“支持全球开源社区是确保软件在基于 Arm 技术硬件上“开机即用”的重要一环。Arm 投入了大量的工程资源与时间用以支持开源项目,并通过持续扩大开源合作伙伴关系,为全球软件开发者提供更多访问资源,以助力其实现更高性能。”

本次大会上,阿里云智能集团研发副总裁、龙蜥社区理事长马涛就分享了阿里云专为云原生时代设计的处理器Anolis 23,并阐述了阿里云的AI思考、异构计算概念,以及如何结合软硬件协同优化的方式、开源社区的众测共创,有效应对AI时代的复杂挑战。

此外,Arm还在构建AI框架、AI软件库、AI技术——KleidiAI。

它能确保全球领先的AI框架,可以快速运行在Arm平台上,释放最佳性能,而且当新的AI模型发布时,需要额外的工作,就可以第一时间运行并展现良好性能。

比如,在基于Arm架构的AWS Graviton处理器上运行Llama 3大模型时,词元(token)首次响应时间可提高2.5倍。

可说,无论现在还是未来,Arm CPU都将是AI运行的基石,同时结合Arm面向基础设施、汽车、终端等多个市场推出的Arm计算子系统、Arm全面设计,以及强大的Arm生态优势,Arm已成功转型为面向未来的应用广泛且至关重要的计算平台技术提供商。

预计到2025年底,全球将有超过1000亿台具备AI能力的Arm设备,为AI的深入普及提供坚实支持。

京公网安备 11011402013531号

京公网安备 11011402013531号