9 月 13 日消息,元象 XVERSE 发布中国最大 MoE 开源模型XVERSE-MoE-A36B。

该模型总参数 255B,激活参数 36B,官方号称效果能“大致达到”超过 100B 大模型的“跨级”性能跃升,同时训练时间减少 30%,推理性能提升 100%,使每 token 成本大幅下降。

MoE(Mixture of Experts)混合专家模型架构,将多个细分领域的专家模型组合成一个超级模型,在扩大模型规模的同时,保持模型性能最大化,甚至还能降低训练和推理的计算成本。谷歌 Gemini-1.5、OpenAI 的 GPT-4 、马斯克旗下 xAI 公司的 Grok 等大模型都使用了 MoE。

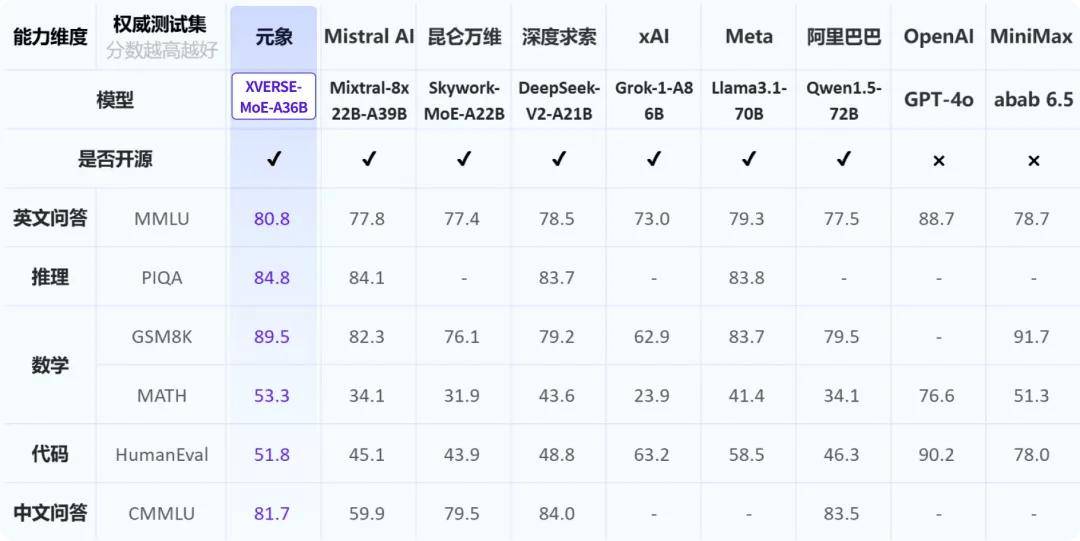

在多个评测中,元象 MoE 超过多个同类模型,包括国内千亿 MoE 模型 Skywork-MoE、传统 MoE 霸主 Mixtral-8x22B 以及 3140 亿参数的 MoE 开源模型 Grok-1-A86B 等。

附相关链接:

Hugging Face:https://huggingface.co/xverse/XVERSE-MoE-A36B 魔搭:https://modelscope.cn/models/xverse/XVERSE-MoE-A36B Github:https://github.com/xverse-ai/XVERSE-MoE-A36B

京公网安备 11011402013531号

京公网安备 11011402013531号