据 LexisNexis 发布的《法律行业生成式人工智能研究报告》调查结果显示,超过三分之一的律师和法学生使用过生成式 AI,几乎五分之一的律师在工作中使用过生成式 AI,且已经运用在各种类型的任务中。

由于法律相关文件多以文本为主,且在法律工作中,有大量的工作是对于文字的分析与处理。这与 LLM 本身的 text-in/text-out,ChatGPT 等生成式人工智能擅长处理文字的特性更为契合。因此,生成式人工智能在法律领域的应用广泛。

但斯坦福、耶鲁等机构近期发表研究称,经过实验测试,LexisNexis、GPT-4 等用于法律领域的 AI 工具准确率最高仅到 65%,幻觉问题是需要关注的重要问题。该项研究结果在Reddit 上引发了热议。

解读要点:

为什么法律类 AI 应更有前景?法律 AI 应用的市场情况如何?

在实际应用中,法律 AI 主要聚焦于哪些工作场景?

哪些场景下的法律 AI 是靠谱的?背后的技术原理是什么?

法律 AI 应用市场尚未成熟,还存在哪些风险?

01法律 AI 在实际应用中,聚焦于哪些工作场景?

律师等法律专业人士的业务范围广泛且繁杂,即包含民事诉讼、刑事辩护等诉讼业务,又包含公司法务、知识产权保护、投融资等业务方向,涉及到的详细工作包括诉讼服务、法律咨询、起草/审查合同等。

虽然生成式 AI 在法律领域的应用广泛,但因 LLM 的推理能力等自身的局限性,目前市面上的法律类 AI 应用通常关注法律文书审核、案件检索等相对简单标准化、重复性高、专业人员参与程度低的场景。

根据 LexisNexis 的《法律行业生成式人工智能研究报告》,生成式人工智能目前在法律工作场景中被使用最多的是法律检索,其次是起草文件,同时还有文件分析和尽职调查。

图:关于受访者更倾向于在哪些法律工作场景中使用生成式AI技术的调查结果(源自LexisNexis)

根据报告《First Global Report on the State of Artificial Intelligence in Legal Practice》调查,大约 38%的律师工作是重复性任务,这些任务可以通过 AI 进行改进。文档审查、合同起草和法律研究是律师认为可以通过 AI 改进的最常见的任务。这些任务的共同点在于都涉及大量的信息处理和模式识别,是 LLM 等 AI 技术所擅长的。[2]

此外,报告调查结果显示,受访者们认为最不可能使用基于 AI 工具的工作类型是管理知识产权、预测诉讼结果和风险、合规和风险管理以及争议解决。

目前,市面上的法律类 AI 应用主要分为面向 B 端企业和 C 端用户两大类。面向 C 端的应用,主要为针对普通用户的法律助手,提供聊天式的法律助手服务,如回答用户法律疑问、提供相应的法律依据和相关判案等;面向 B 端企业受众的应用,则可以细分为以下几个应用场景:

① 合同管理:包括合同起草、编辑、合同分析等;

② 法律文件:包括起草专利、法律文书、取证等、文件搜索等;

③ 法律助理:针对律师和律师事务所提供用于回答问题、执行特定任务的法律聊天机器人;

④ 法律相关研究:包括语义判例搜索、先例搜索、研究备忘录等。

以下针对上文提到的面向不同受众、应用场景的法律类 AI 应用,展开详细介绍。

法律 AI 应用之合同管理类

大部分的公司通常使用内部团队管理合同,由于合同数量大、管理流程复杂,由此催生了服务法律团队的合同生命周期管理(contract lifecycle management)相关的公司。关于合同起草、编辑、合同分析等合同管理类的 AI 应用,较为典型的有 lronclad 和 Robin。

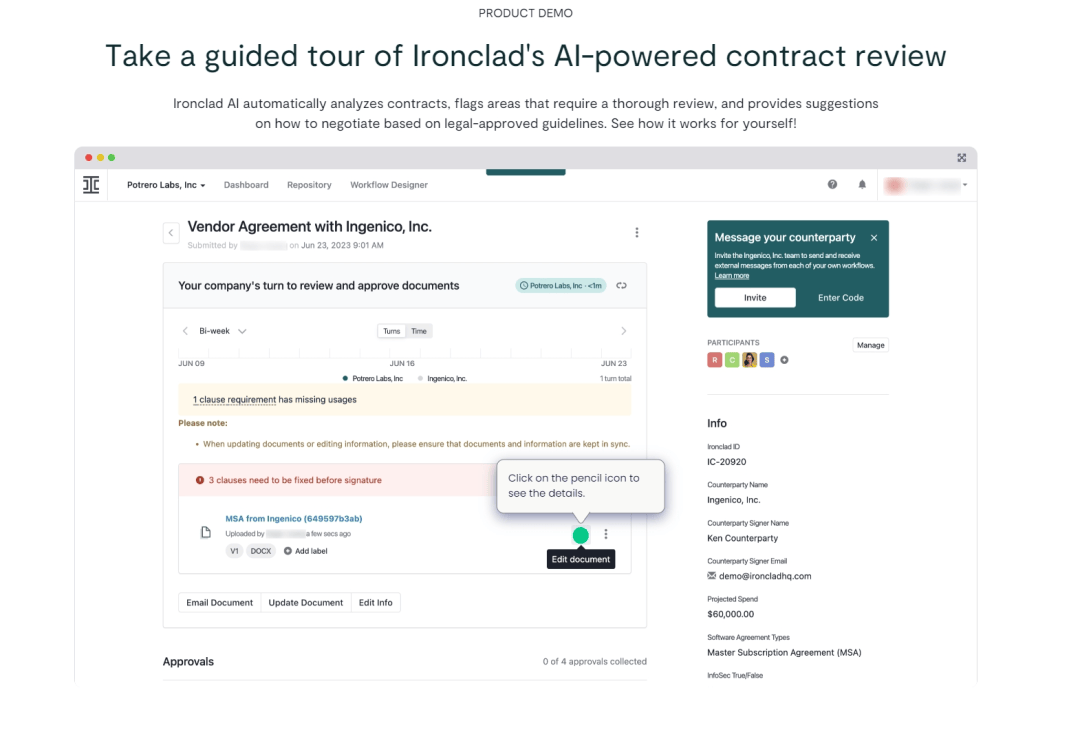

lronclad:是一个合同生命周期管理 (CLM) 平台,可帮助业务和法律团队管理合同流程的各个方面,包括起草、编辑、协商、搜索、签署和存储合同等。同时,还能自动为用户处理大量、低风险的合同,无需法律人员的参与。例如,lronclad 推出的 AI Assist 功能,能基于 AI 技术帮助用户解释合同条款、标记问题和修改意见。[3]

图:lronclad 的 AI 合同审查功能演示

Robin:Robin 主要针对于法律团队的合同报告生成和分析。服务包括合同审查服务、合同搜索与分析、合同报告生成以及托管服务。以合同审查服务为例,基于 AI 技术辅助的编辑功能可以减少合同中的修订情况,确保合同内容的一致性,以及可以自动执行合同内容的总结、定义术语的检查以及合同的重新起草等任务。

法律 AI 应用之法律文件类

从一个成熟的律师的时间分配来看,其过半的时间主要用于法律文件的起草和审查。而 AI 工具旨在提升律师在法律文件方面的工作效率。

法律文件类相关的应用较多,以典型的 Luminance 为例展开介绍。Luminance 的定位是法律 AI Copilot,是面向律师的 AI 平台。基于其专有的法律 AI 大模型,Luminance 具备自动生成、审查和分析合同及其他法律文件的能力,能够端到端的进行法律文件处理。例如,Luminance 每分钟可以自动阅读和理解数百页详细且复杂的法律文档,使得律所能够以更快的速度开展必要的尽职调查工作。此外,公司还推出了聊天机器人「Ask Lumi」,通过 Copilot 允许用户在 Microsoft Word 中打开任何合同,向 Lumi 询问有关合同修改的任何问题。[4]

图:Luminance 官网介绍

此外,聚焦于个人伤害索赔领域的 Evenup 也值得关注。Evenup 利用 AI 为诉前人身伤害案件自动生成需求函,包括车祸、警察暴力、儿童虐待、自然灾害等案件,相比传统人工流程可显著提升速度。[5]

法律 AI 应用之法律助理类

随着律所员工和其他业务成本的增加,降本增效正成为业内的大趋势。而法律助理类的 AI 应用帮助律师从繁重的文书工作中解放出来,提高工作效率的同时,专注于更加复杂和战略性的工作。

Harvey 是典型的法律助理类 AI 应用。Harvey 以大型律师事务所作为目标客户,定位是律师的通用性助理。Harvey 平台提供了一套针对所有执业领域和工作流程的律师和律师事务所量身定制的产品。其 AI 助手可以通过自然语言指令帮助起草、分析、回答问题等,如可以帮助用户调研并回答法律、监管和税务等多个领域的复杂研究问题。同时,可以一次性千个合同文档转换为结构化数据进行分析。此外,还提供定制化服务,使用客户提供的特有工作产品和模板训练,定制专属的模型,嵌入至员工的工作流中。[6]

法律 AI 应用之法律研究类

据《First Global Report on the State of Artificial Intelligence in Legal Practice》调查,法律研究和文档自动化是律师们使用 AI 工具最频繁的两个场景。在调查中,有 79.7%的受访者选择了法律研究作为可以通过 AI 进行改进的任务。这可能是因为 AI 能够快速地搜索和分析大量法律文档和案例,从而帮助律师更高效地进行法律研究。

02LegalTech 的趋势下,背后的技术原理是什么?如何提高实际可用性?

「AI+法律行业」的发展主要分为三个阶段,目前正处于「LLM+法律」的第三阶段。[7]

第一阶段:2000-2011 年,AI 主要应用于 E-discovery(指对电子数据的识别、收集、处理、审查和制作),搜索、排序和分类数据,用于减少浏览大量法律文件所需的时间; 第二阶段:2012-2020 年,在 E-discovery 的基础之上,以 NLP 为主的 AI 技术进入合同管理、诉讼预测、法律研究等法律工作流程中; 第三阶段:2021 年至今,以 LLM 为主的 AI 技术发展迅速,出现了大量针对法律文书审核、案件检索、合同撰写及审核的法律 AI 应用。尽管 LLM 等 AI 技术的发展,使得越来越多的法律 AI 能够辅助文档审查、合同起草和法律研究等任务。但法律 AI 存在的「幻觉」问题或明显错误的输出,成为其在实际应用中最大的「难题」。在法律工作中,错误风险是不对称的,微小的错误可能导致重大的法律后果。

例如,在去年美国的一起诉讼案件中,一位资深律师在向法院提交的文件中,引用了 ChatGPT 捏造的 6 个不存在的案例。同时,一项研究发现,通用大型语言模型(LLM)在法律查询中平均有 58%到 82%的时间产生幻觉。[8]

斯坦福大学和耶鲁大学的论文《Hallucination-Free?Assessing the Reliability of Leading AI Legal Research Tools》指出,法律类 LLM 产生的幻觉主要为事实性幻觉,即 AI 工具产生的回应中包含的错误信息或虚假断言某个来源支持某个主张。事实性幻觉涉及到模型对其训练数据、输入提示或真实世界事实的不忠实。在法律环境中,主要关注第三种情况,即模型的回应与法律事实真相不符。[9]

法律类 LLM 产生幻觉的原因主要有几点:一是在检索挑战,法律查询往往不具有单一明确的答案,且法律意见随时间由法官撰写,这些意见会相互建立在先例之上,这使得决定要检索什么信息在法律设置中变得具有挑战性;二是文档相关性,在法律背景下,文档的相关性不仅仅基于文本相似性,还需要考虑非文本元素,如管辖区和时间等;三是生成有意义的法律文本的复杂性,法律文件通常由律师来写,依赖于大量的背景知识来正确理解和应用。需要能够在保持适当法律背景的同时,从不同文本中综合事实、裁决和规则。

因此,法律类 LLM 的幻觉问题更容易在复杂法律研究、案例法分析、合同分析和起草、事实性查询等场景中出现。

业内常用的做法是采用检索增强生成(RAG)技术来解决大语言模型的幻觉、知识更新问题。

RAG 技术为大型语言模型(LLM)提供从某些数据源检索到的信息,以此作为生成答案的基础。通常是搜索加上 LLM 提示的结合,即让模型根据搜索算法找到的信息作为上下文来回答查询,同时查询和检索到的上下文都被注入到发送给 LLM 的提示中。

简单来说,RAG 的本质是将一些参考资料复制粘贴到 LLM 的上下文中,然后要求它在给出答案时使用这些参考资料。当 RAG 技术应用到法律 LLM 中时,就像让 LLM 进行「开卷考试」一样,通过参考相关资料,从而提高回答的准确性和可靠性。

首先,用户提出法律问题;然后,LLM 系统搜索相关的法律文档、案例、法规等资料;接着,LLM 将找到的相关资料和用户的问题一起构成一个完整的提示;最后,LLM 根据提示中的资料和问题生成回答。

尽管 RAG 技术可以改善 LLM 在回答法律查询时的性能,但幻觉问题依然是存在的。据上述提到的斯坦福大学和耶鲁大学的论文,对基于 RAG 的专有法律 AI 工具的性能进行了评估,结果显示 LexisNexis 的 Lexis+ AI 和 Thomson Reuters 的 Westlaw AI-Assisted Research 和 Ask Practical Law AI 在回答查询时,分别有 17%到 33%的时间会产生幻觉。

03法律 AI 应用市场尚未成熟,还存在哪些风险?

受限于 LLM 的智能化程度以及法律领域的高数据壁垒和知识壁垒,大多数律所在实施 AI 技术时往往采取谨慎的态度。针对于 C 端普通消费者也存在一定的风险,大模型存在的各种幻觉问题,同时普通消费者没有法律背景,对于法律 AI 给出的答案没有分辨能力。法律 AI 市场仍处于不成熟的阶段,缺乏主导技术......

订阅机器之心Pro会员通讯

京公网安备 11011402013531号

京公网安备 11011402013531号